中科大华为发布生成式推荐大模型:昇腾 NPU 可部署,背后认知一同公开

推荐的大型模型同样具备生成能力,并且首次成功部署于国产昇腾 NPU 上!

在信息爆炸的时代,推荐系统已成为生活中不可或缺的部分。Meta 首先提出了生成式推荐框架 HSTU,将推荐参数扩大至万亿级别,取得了显著成效。

最近,中科大与华为携手开发了推荐大模型的部署方案,适用于多个应用场景。在探索过程中还发现了什么经验与见解?最新的公开分享来了。

报告的亮点包括:

-

总结推荐范式的演变过程,指出具备扩展定律的生成式推荐范式是未来的发展趋势;

-

复现并分析不同架构的生成式推荐模型及其扩展定律;通过消融实验和参数分析,解析 HSTU 的扩展定律来源,并为 SASRec 赋予可扩展性;

-

验证 HSTU 在复杂场景和排序任务中的性能及扩展性;

-

团队展望未来的研究方向并总结观点。

具备扩展定律的生成式推荐范式正逐渐成为未来趋势

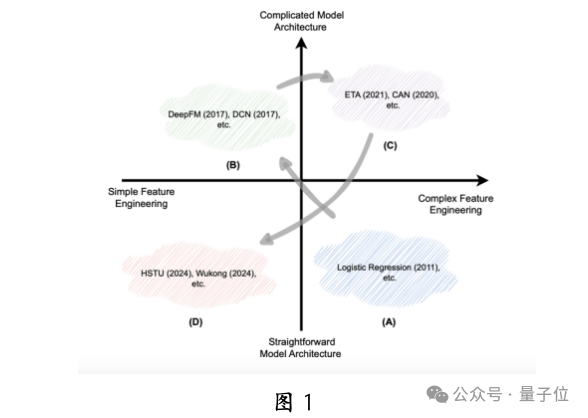

如图 1 所示,推荐系统的发展趋势是逐步减少对手工设计特征工程和模型结构的依赖。在深度学习兴起之前,由于计算资源的限制,人们倾向于使用手工设计的特征和简单模型(图 1A)。

随着深度学习的发展,研究者们专注于复杂模型的设计,以更有效地拟合用户偏好,并提高对 GPU 并行计算的利用效率(图 1B)。

然而,随着深度学习能力逐渐达到瓶颈,特征工程重新引起了关注(图 1C)。

目前,大语言模型的扩展定律成功激励了推荐领域的研究者。扩展定律描述了模型性能与关键指标(如参数规模、数据集规模和训练资源)之间的幂律关系。通过增加模型的深度和宽度,并结合大量数据,可以有效提升推荐效果(图 1D),这种策略被称为推荐大模型。

近期,像 HSTU 这样的生成式推荐框架在这一方向上取得了显著成果,验证了推荐领域的扩展定律,推动了生成式推荐大模型的研究热潮。团队认为,生成式推荐大模型正在成为颠覆现有推荐系统的下一个新范式。

在这样的背景下,探讨哪些模型真正具备可扩展性,理解其成功应用扩展定律的原因,以及如何利用这些规律提升推荐效果,成为当前推荐系统领域的热门研究话题。

基于不同架构的生成式推荐大模型的扩展性分析

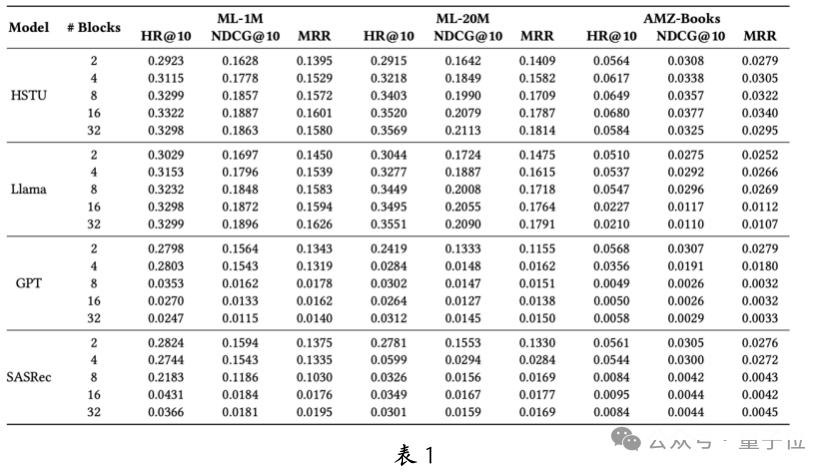

为评估生成式推荐大模型在不同架构下的扩展性,团队对比了 HSTU、Llama、GPT 和 SASRec 四种基于 Transformer 的架构。

在三个公开数据集上,通过分析不同注意力模块数量下的性能表现(见表 1)。结果表明,当模型参数较小时,各架构的表现相似,而最优架构因数据集而异。

然而,当参数扩展时,HSTU 和 Llama 的性能显著提高,而 GPT 和 SASRec 的扩展性则不足。尽管 GPT 在其他领域表现良好,但在推荐任务上却未能达到预期。团队认为这是因为 GPT 和 SASRec 的架构缺乏为推荐任务专门设计的关键组件,无法有效利用扩展定律。

生成式推荐模型的可扩展性来源分析

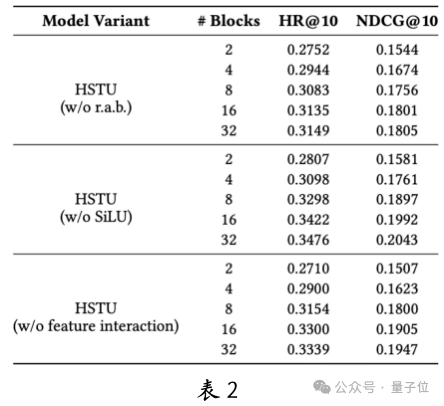

为了探讨 HSTU 等生成式推荐模型的可扩展性来源,团队进行了消融实验,分别去除了 HSTU 中的关键组件:相对注意力偏移(RAB)、SiLU 激活函数和特征交叉机制。

实验结果(见表 2)显示,单模块的缺失未显著影响模型的扩展性,但 RAB 的去除导致性能明显下降,表明其关键作用。

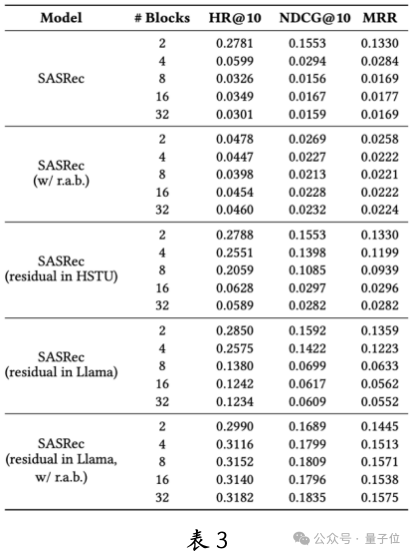

进一步分析影响模型扩展定律的因素,团队比较了 SASRec 和扩展性良好的 HSTU、Llama 之间的差异,发现主要差异在于 RAB 及注意力模块中的残差连接方式。

为验证这些差异是否为扩展性的关键,团队为 SASRec 增加了 HSTU 的 RAB,并调整了其注意力模块的实现方式。

实验结果(见表 3)表明,单独添加 RAB 或修改残差连接未显著改善 SASRec 的扩展性。然而,双组件同时修改后,SASRec 展现出良好的扩展性。这说明,残差连接模式与 RAB 的结合,为传统推荐模型赋予了可扩展性,为今后的推荐系统扩展性探索提供了重要启示。

生成式推荐模型在复杂场景和排序任务中的表现

复杂场景中的表现

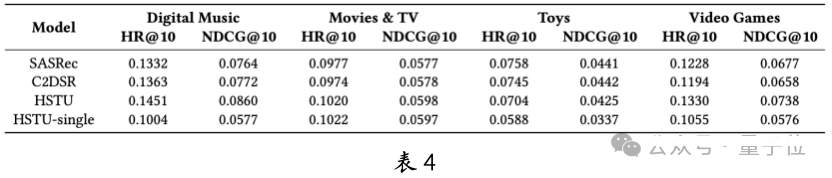

HSTU 在多域、多行为和辅助信息等复杂场景中表现出色。以多域为例,HSTU 在 AMZ-MD 的四个域中始终超越基线模型 SASRec 和 C2DSR(见表 4)。

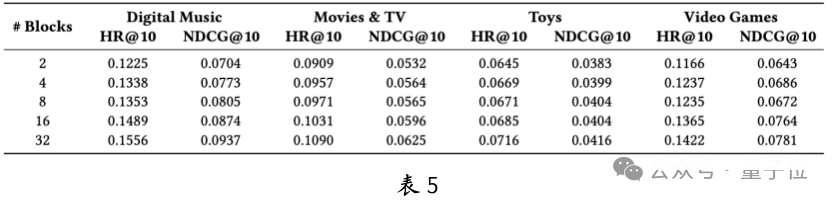

与单域独立训练的 HSTU-single 相比,多域联合训练的 HSTU 的表现更佳,证明了多域联合建模的优势。表 5 显示,HSTU 在多域行为数据上的扩展性显著,尤其在 Digital Music 和 Video Games 等较小规模场景中,这表明 HSTU 在解决冷启动问题上具有潜力。

在排序任务中的表现

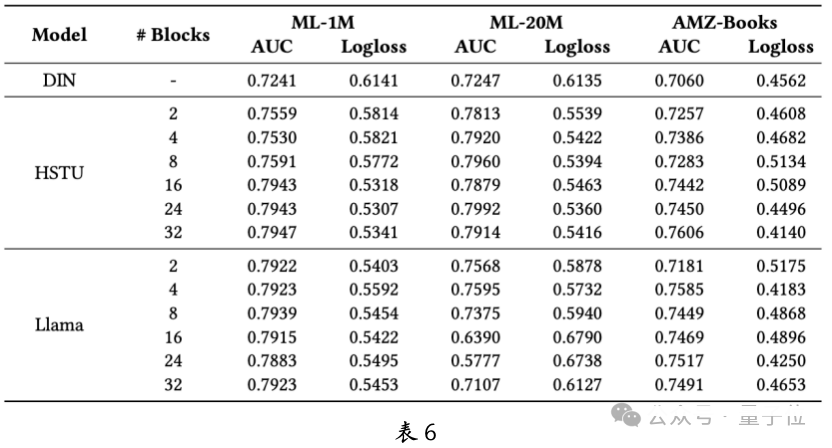

排序在推荐系统中占有重要地位,团队对生成式推荐模型在排序任务中的有效性和扩展性进行了深入探讨。如表 6 所示,生成式推荐大模型在性能上显著优于 DIN 等传统推荐模型。尽管在小规模模型中,Llama 的表现超过了 HSTU,但 HSTU 在扩展性方面优势明显,而 Llama 的扩展性较弱。

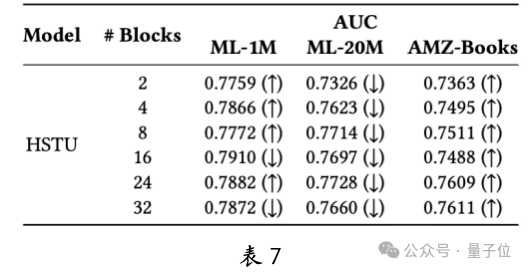

团队还研究了负采样率和评分网络架构对排序任务的影响,并进行了全面分析。此外,还探讨了缩减 embedding 维度对性能的影响。缩小 embedding 维度(表 7)改善了小数据集 ML-1M 和 AMZ-Books 的性能,但在大数据集 ML-20M 上则有所下降。这表明推荐大模型的扩展定律不仅受垂直扩展(如注意力模块数量)的影响,还受水平规模(如 embedding 维度)的影响。

未来方向与总结

在技术报告中,团队指出了数据工程、Tokenization、训练和推理效率等推荐大模型未来研究的潜力方向,这些方向将有助于解决当前的挑战并拓宽应用场景。

本文来自微信公众号:量子位(ID:QbitAI),作者:认知智能全国重点实验室 & 华为诺亚方舟,原标题《中科大华为发布生成式推荐大模型,昇腾 NPU 可部署,背后认知一同公开》