同级别最强:Mistral Small 3.1 登场,128K 上下文、单张 4090 可跑,优于 Gemma 3 和 GPT4o-mini

GoodNav 3 月 19 日消息,Mistral AI 于 3 月 17 日发布了一篇博文,介绍其最新的 Mistral Small 3.1 模型,该模型拥有 240 亿参数和 128K 的上下文能力,支持本地运行以降低成本,部分性能超过 OpenAI 的 GPT-4o mini。

根据博文的说明,Mistral Small 3.1 旨在实现高效运行,能够在单张 RTX 4090 显卡的计算机或配备 32GB 内存的 Mac 上进行本地运作,特别适合虚拟助手等需要快速、精准响应的应用场景,使其成为预算有限的中小企业和开发者的理想选择。

该模型不需依赖云端 AI 系统,能够支持本地数据处理,从而降低敏感信息泄露的风险。此外,它还支持低延迟函数的调用,可以在自动化或代理工作流程中快速执行相关功能。

Mistral Small 3.1 适用于多种需要多模态理解的企业及消费者应用,例如文档验证、诊断、设备端图像处理、质量检测视觉分析、安全系统中的物体识别、基于图像的客户支持及通用助手等。

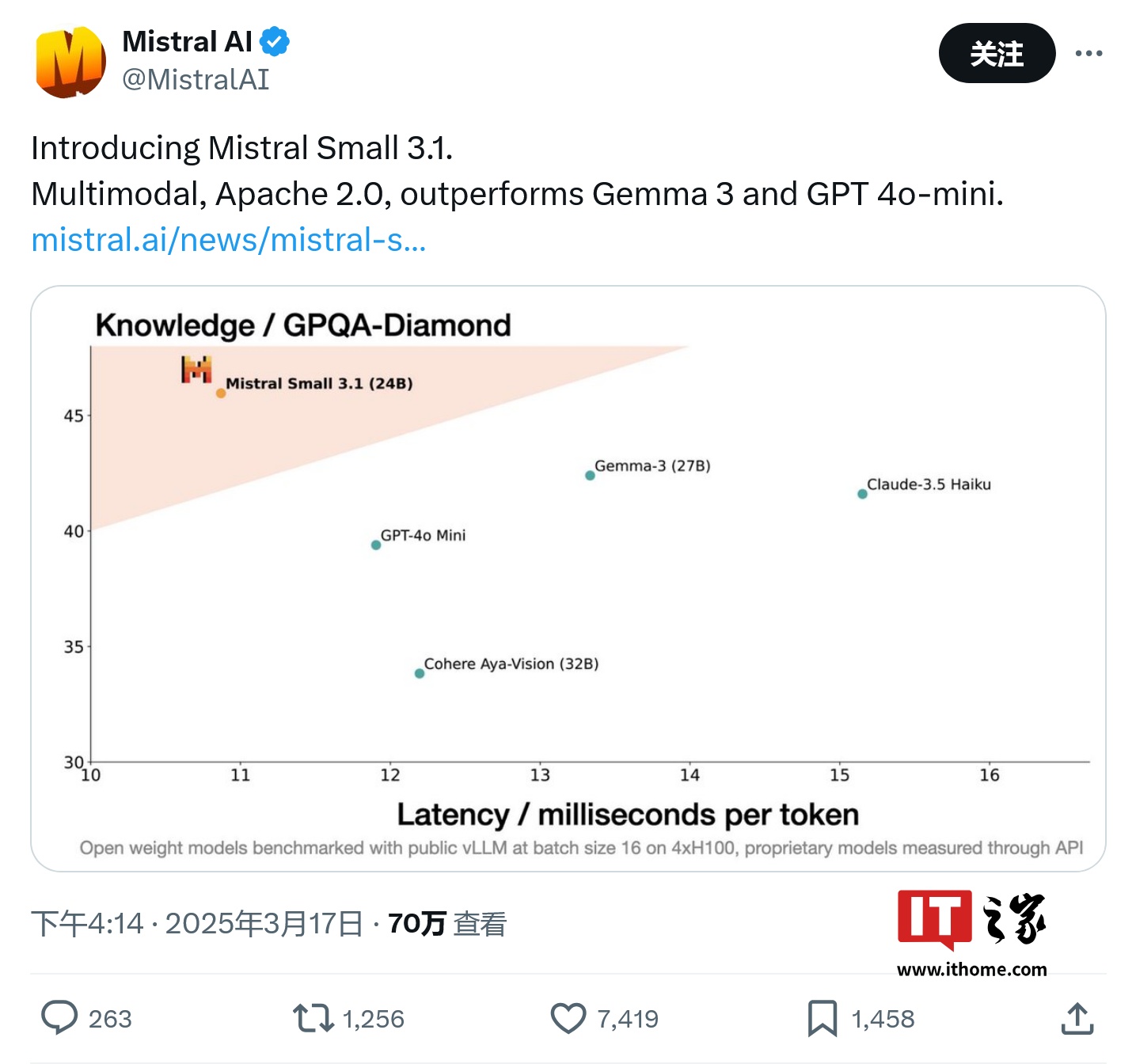

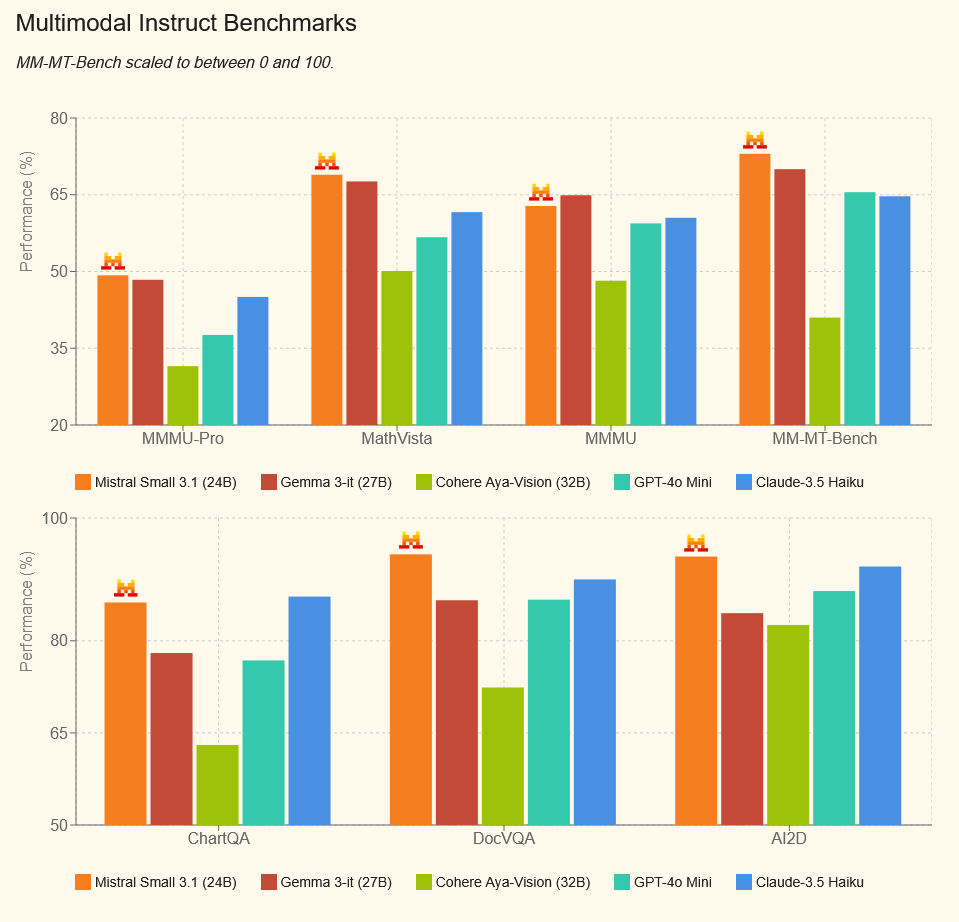

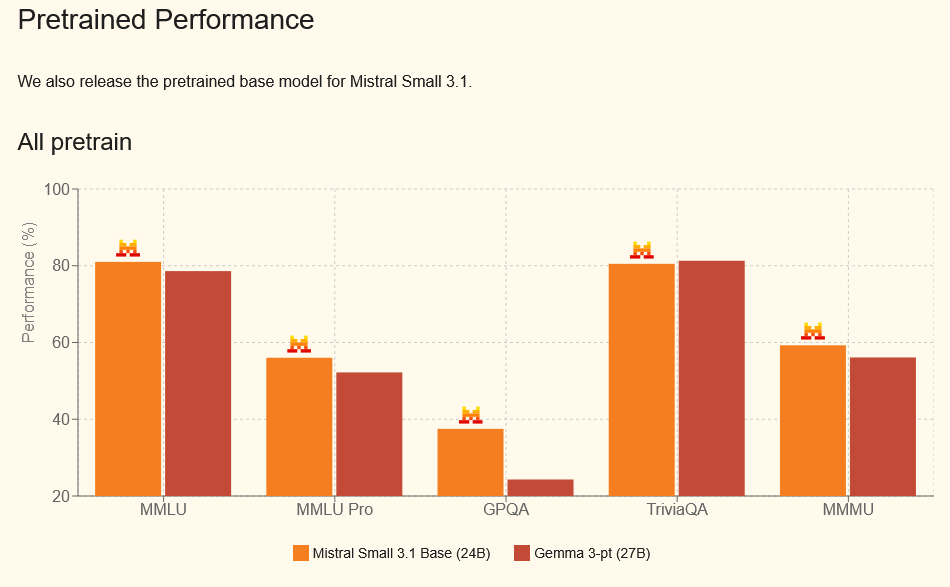

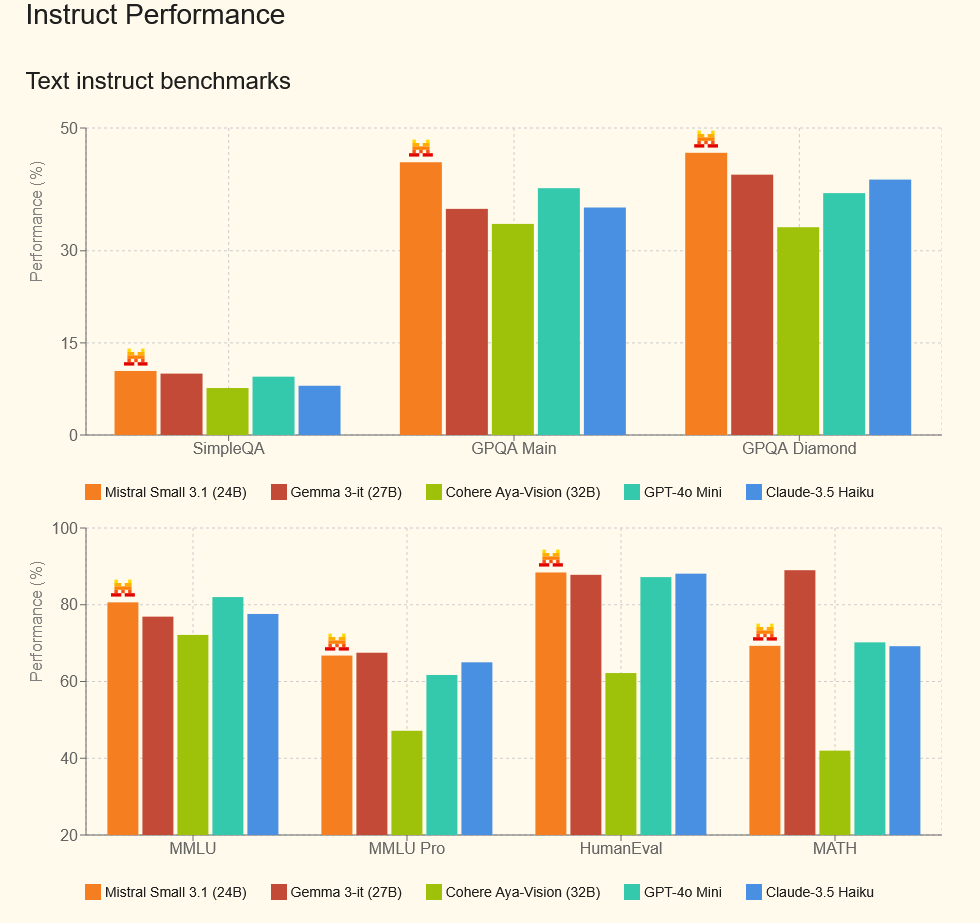

Mistral Small 3.1 在多项基准测试中表现优异,展示了其在多语种理解、长文本处理及多模态指令跟随方面的强大能力。

在多语言理解能力上,Mistral Small 3.1 超越了 Gemma-3、Cohere Aya-Vision、GPT-4o Mini 和 Claude-3.5 Haiku 等其他模型。

在视觉和文本信息处理方面,Mistral Small 3.1 在视觉推理、图表信息提取和图解分析等领域表现出色,其推理速度可实现每秒高达 150 个 tokens。

在解答问题、知识检索、代码生成及数学问题解决方面,Mistral Small 3.1 同样展现了强大的性能。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...