英伟达宣布创造满血 DeepSeek-R1 模型 AI 推理性能的世界纪录

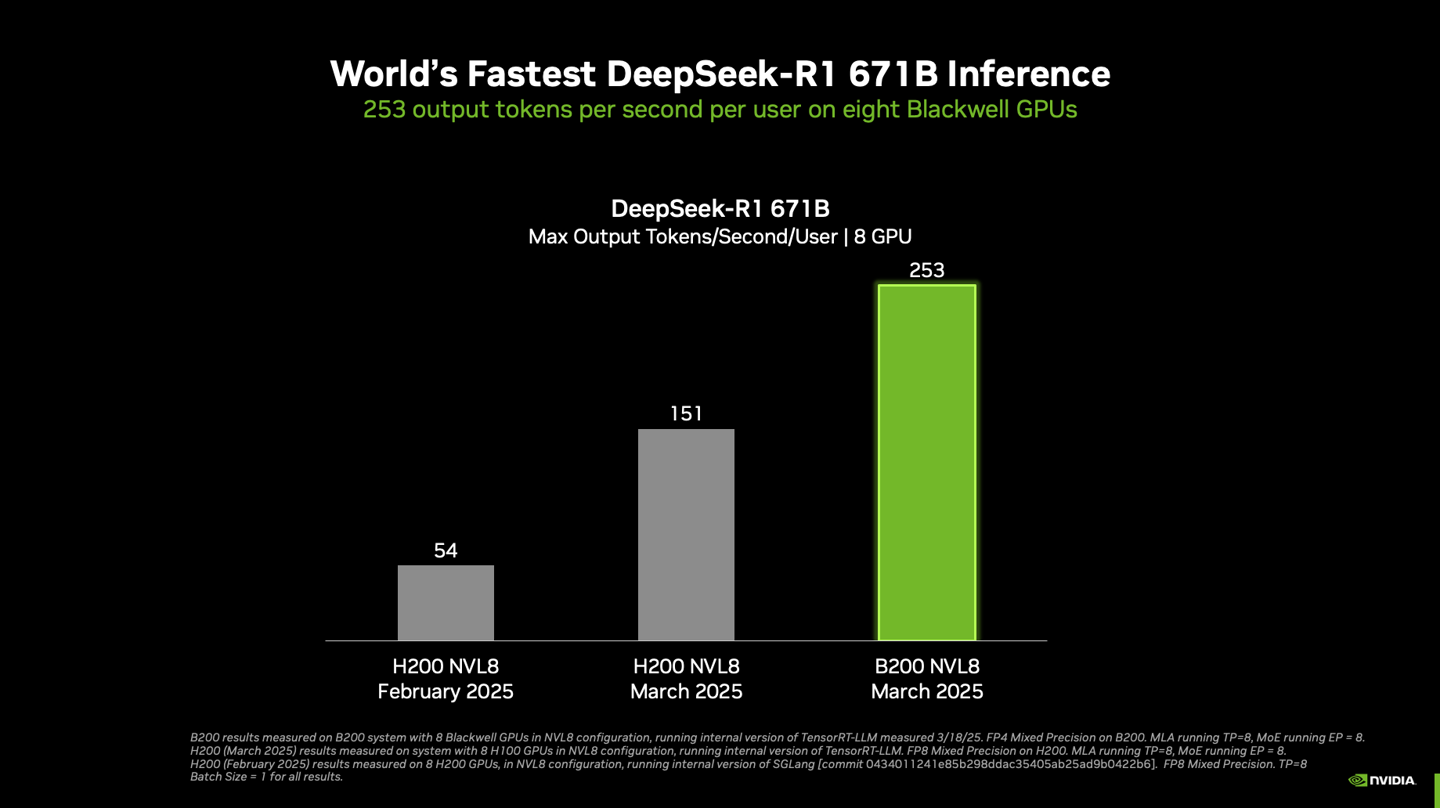

GoodNav 3 月 19 日消息,英伟达在今日举行的 NVIDIA GTC 2025 会议上宣布,其 NVIDIA Blackwell DGX 系统打破了 DeepSeek-R1 大模型推理性能的世界纪录。

根据介绍,搭载八块 Blackwell GPU 的单个 DGX 系统能够在运行 6710 亿参数的完整 DeepSeek-R1 模型时,每位用户每秒实现超过 250 token 的响应速度,且系统的最高吞吐量超过每秒 3 万 token。

英伟达表示,随着 NVIDIA 平台在最新的 Blackwell Ultra GPU 和 Blackwell GPU 上不断突破推理的极限,其性能也将持续提升。

-

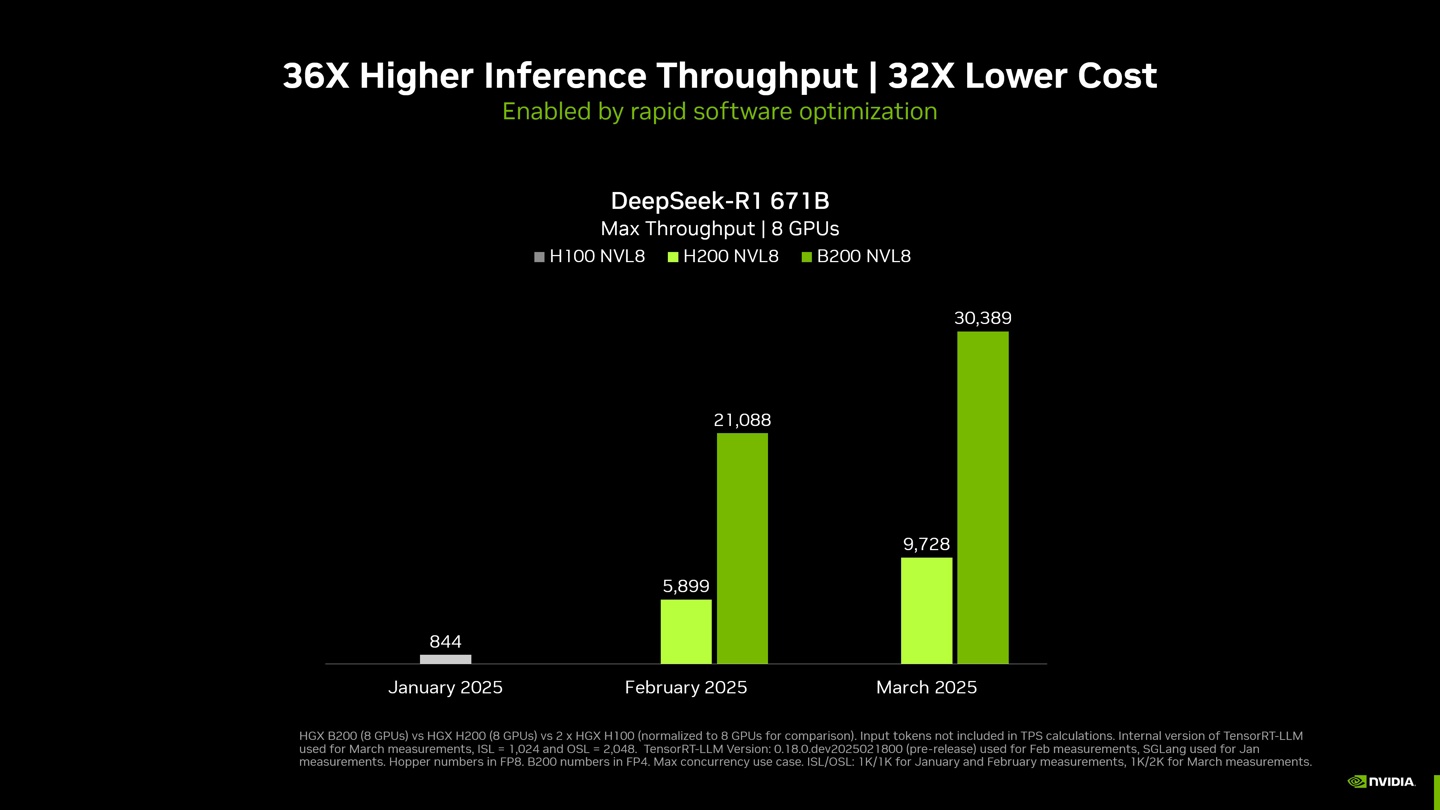

单节点配置:DGX B200(8 块 GPU)与 DGX H200(8 块 GPU)

-

测试参数:最新测试采用 TensorRT-LLM 内部版本,输入 1024 token / 输出 2048 token;此前测试为输入 / 输出各 1024 token;并发性

-

计算精度:B200 采用 FP4,H200 采用 FP8 精度

英伟达指出,自 2025 年 1 月以来,通过硬件和软件的结合,他们成功将 DeepSeek-R1 671B 模型的吞吐量提升了大约 36 倍。

-

节点配置:DGX B200(8 块 GPU)、DGX H200(8 块 GPU)、两个 DGX H100(8 块 GPU)系统

-

测试参数:仍然采用 TensorRT-LLM 内部版本,输入 1024 token / 输出 2048 token;之前测试为输入 / 输出各 1024 token;并发性 MAX

-

计算精度:B200 采用 FP4,H100 / H200 采用 FP8 精度

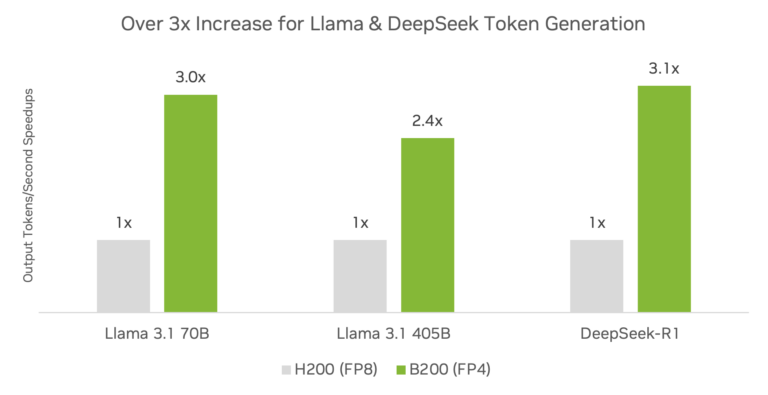

与 Hopper 架构相比,Blackwell 架构结合 TensorRT 软件显著提升了推理性能。

英伟达表示,使用 TensorRT 软件和 FP4 精度的 DGX B200 平台与 DGX H200 平台相比,对于 DeepSeek-R1、Llama 3.1 405B 和 Llama 3.3 70B 的推理吞吐量提升已超过 3 倍。

| 精度 | MMLU | GSM8K | AIME 2024 | GPQA Diamond | MATH-500 |

| DeepSeek R1-FP8 | 90.8% | 96.3% | 80.0% | 69.7% | 95.4% |

| DeepSeek R1-FP4 | 90.7% | 96.1% | 80.0% | 69.2% | 94.2% |

英伟达表示,在对模型进行量化以利用低精度计算优势的过程中,确保精度损失最小化是生产部署的关键。需要注意的是,在 DeepSeek-R1 模型上,TensorRT Model Optimizer 的 FP4 训练后量化(PTQ)技术相比 FP8 基准精度,仅在不同数据集上造成了微不足道的精度损失。