受 DeepSeek-R1 启发,小米大模型团队登顶音频推理 MMAU 榜

GoodNav 3 月 17 日报道,@小米技术 的官方微博今天发布消息称,小米大模型团队在音频推理领域取得了重要进展。受 DeepSeek-R1 的启示,该团队首个将强化学习算法应用于多模态音频理解任务,经过一周的努力,便以 64.5% 的 SOTA 准确率登顶国际权威 MMAU 音频理解评测榜,并已同步开源。

以下是官方全文:

强化学习展现“反直觉”优势 —— 小米大模型团队登顶音频推理 MMAU 榜

当面临一段汽车行驶中的座舱录音,AI 是否能够判断出汽车可能存在的故障?在交响乐演出时,AI 是否能够揣测作曲家在创作这段音乐时的心情?在早高峰时期地铁站混杂的脚步声中,AI 是否能预测闸机口可能发生的碰撞风险?在大模型时代,人们希望机器不仅能识别语言内容和声音类别,更渴望机器具备复杂的推理能力。

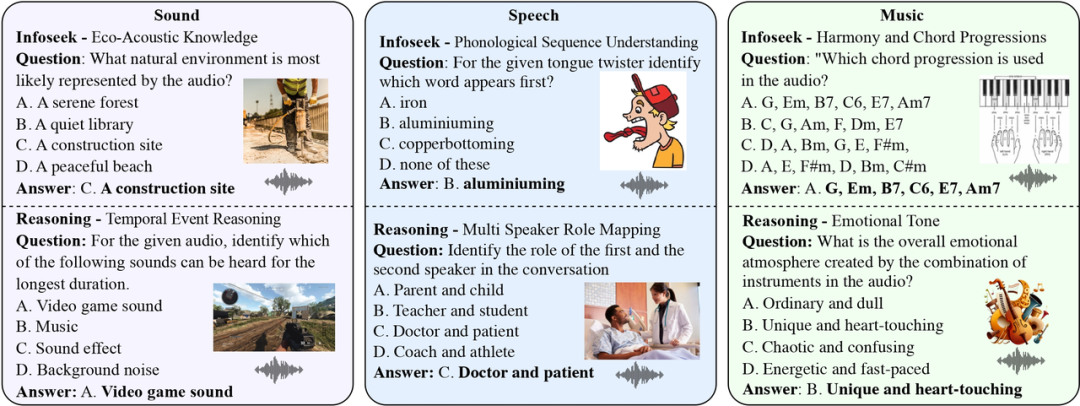

MMAU(Massive Multi-Task Audio Understanding and Reasoning)评测集(https://arxiv.org/ abs / 2410.19168)是量化这种音频推理能力的标准,它通过一万条包含语音、环境声和音乐的音频样本,并结合人类专家标注的问答对,测试模型在 27 种技能上的表现,例如跨场景推理和专业知识等,期望模型能够接近人类专家的逻辑分析水平。

作为基准,人类专家在 MMAU 上的准确率为 82.23%。这一评测集难度很大,目前 MMAU 官网榜单上表现最突出的模型是 OpenAI 的 GPT-4o,准确率达 57.3%;紧随其后的是 Google DeepMind 的 Gemini 2.0 Flash,准确率为 55.6%。

阿里推出的 Qwen2-Audio-7B 模型在此评测集上的准确率为 49.2%。由于其开源特性,我们尝试使用清华大学发布的 AVQA 数据集(https://mn.cs.tsinghua.edu.cn/ avqa/),对该模型进行微调。AVQA 数据集仅包含 3.8 万条训练样本,通过全量有监督微调(SFT),模型在 MMAU 上的准确率提升到 51.8%,提升幅度并不显著。

DeepSeek-R1 的发布为我们在此项任务上提供了新思路。DeepSeek-R1 的 Group Relative Policy Optimization (GRPO) 方法,让模型通过\”试错-奖励\”机制,实现自主进化,展现出类似人类的反思和多步验证等推理能力。同时,卡内基梅隆大学也发布了论文预印本“All Roads Lead to Likelihood: The Value of Reinforcement Learning in Fine-Tuning (https://arxiv.org/ abs / 2503.01067)”,通过巧妙的实验揭示了一个有趣的结论:当任务存在明显的生成-验证差距(Generation-Verification Gap),即生成结果的难度远超过验证结果正确性的难度时,强化学习相较于有监督微调显示出独特优势,而 AQA 任务恰好是一个显著的生成-验证差距的典型任务。

简单来说,离线微调方法如 SFT,好比是通过做题库来训练,你只能依据已有的题目和答案,但面对新问题时可能无能为力;而强化学习方法如 GRPO,更像是老师要求你多想几种答案,并告诉你哪些答案更好,让你主动思考,激发自身能力,而不是单纯接受“填鸭式”教育。当然,如果训练数据充足,比如有学生愿意投入大量时间死记硬背题库,最终或许能取得不错的效果,但时间效率低下。而主动思考更易于实现举一反三的效果,强化学习的实时反馈能帮助模型更快锁定高质量答案的区域,而离线方法则需要遍历全可能性空间,效率较低。

基于以上见解,我们尝试将 DeepSeek-R1 的 GRPO 算法迁移到 Qwen2-Audio-7B 模型上。令人惊喜的是,在仅使用 AVQA 的 3.8 万条训练样本的情况下,强化学习微调后的模型在 MMAU 评测集上达到了 64.5% 的准确率,这一成绩比当前榜单第一的商业闭源模型 GPT-4o 高出近 10 个百分点。

有趣的是,当我们在训练时强制要求模型输出 <thinking></thinking> 推理过程时,准确率反而下降至 61.1%。这表明显式的思维链结果输出可能不利于模型的训练。

我们的实验揭示了几个传统认知中不同的结论:

-

关于微调方法:强化学习在 3.8 万条数据集上的表现显著超过监督学习在 57 万条数据集上的结果

-

关于参数规模:与千亿级模型相比,7B 参数的模型通过强化学习依然能展现强大的推理能力

-

关于隐式推理:显式思维链输出反而成为性能的瓶颈

尽管当前准确率已超过 64%,但仍距人类专家的 82% 水平有差距。在我们目前的实验中,强化学习策略相对粗糙,训练过程中对思维链的引导不够充分,我们会在后续进行更深入的探索。

此次实验验证了强化学习在音频推理领域的独特价值,并为后续研究指明了方向。当机器不仅能“听见”声音,更能“听懂”声音背后的因果逻辑时,真正的智能听觉时代将会到来。

我们已将训练代码、模型参数开源,并提供了技术报告,供学术界和产业界进行参考交流。

训练代码:https://github.com/xiaomi-research/r1-aqa

模型参数:https://huggingface.co/mispeech/r1-aqa

技术报告:https://arxiv.org/abs/2503.11197

交互 Demo:http://120.48.108.147:7860/