阿里通义团队开源 R1-Omni:多模态模型 + RLVR,让各模态作用清晰可见

GoodNav 3 月 11 日报道,随着 DeepSeek R1 的发布,强化学习在大型模型领域的潜力得到了进一步开发。Reinforcement Learning with Verifiable Reward(RLVR)方法的提出,为多模态任务开辟了新的优化路径,这在几何推理、视觉计数乃至经典图像分类及物体检测等任务中,RLVR 显示出了超越传统监督微调(SFT)的显著效果。

不过,当前的研究主要集中于 Image-Text 多模态任务,尚未展开到更为复杂的全模态场景。因此,通义实验室团队探讨了 RLVR 与视频全模态模型的结合,并于今日宣布开源R1-Omni 模型。

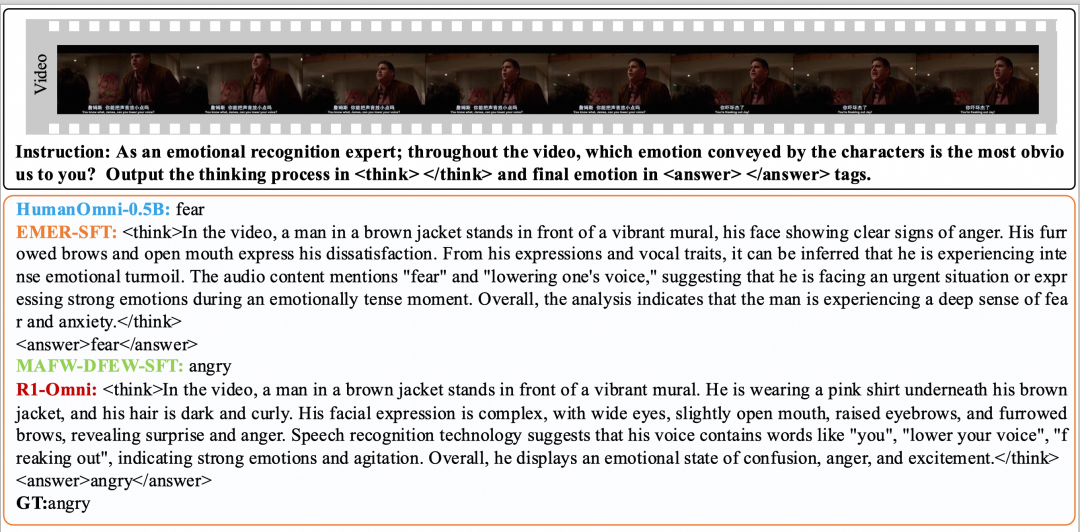

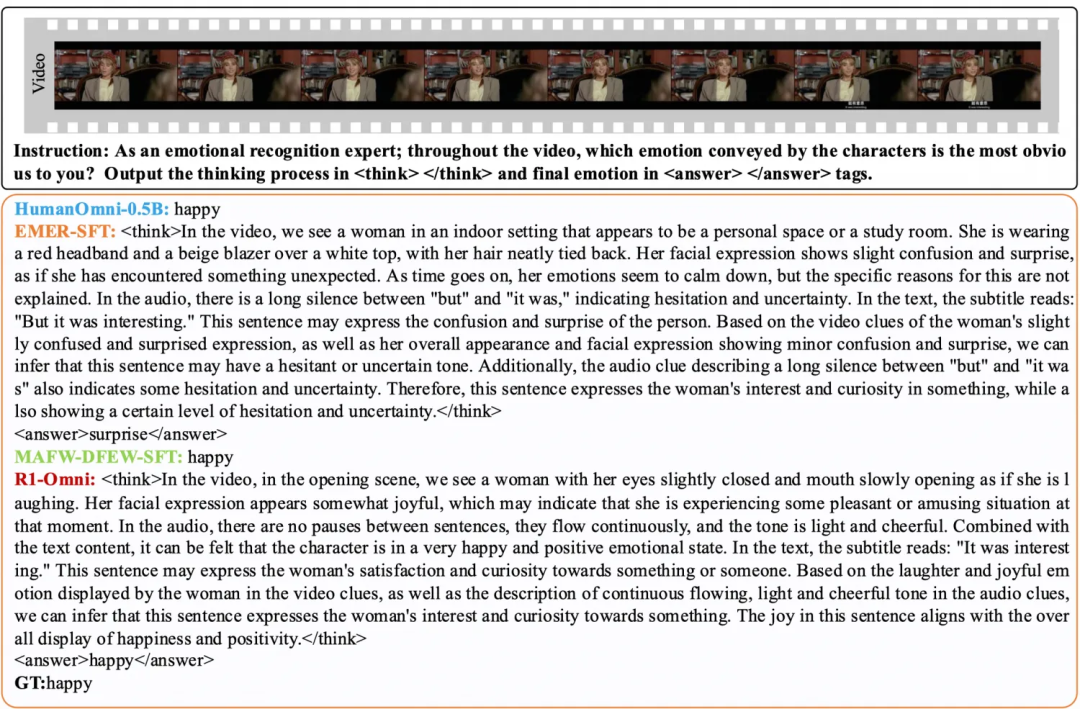

R1-Omni 的一个主要优势在于其透明性(推理能力)。借助 RLVR 方法,音频和视频信息在模型中的角色变得更加明晰。

例如,在情绪识别的任务中,R1-Omni 能够清楚地指出哪些模态信息对特定情绪的判定起到了关键影响。

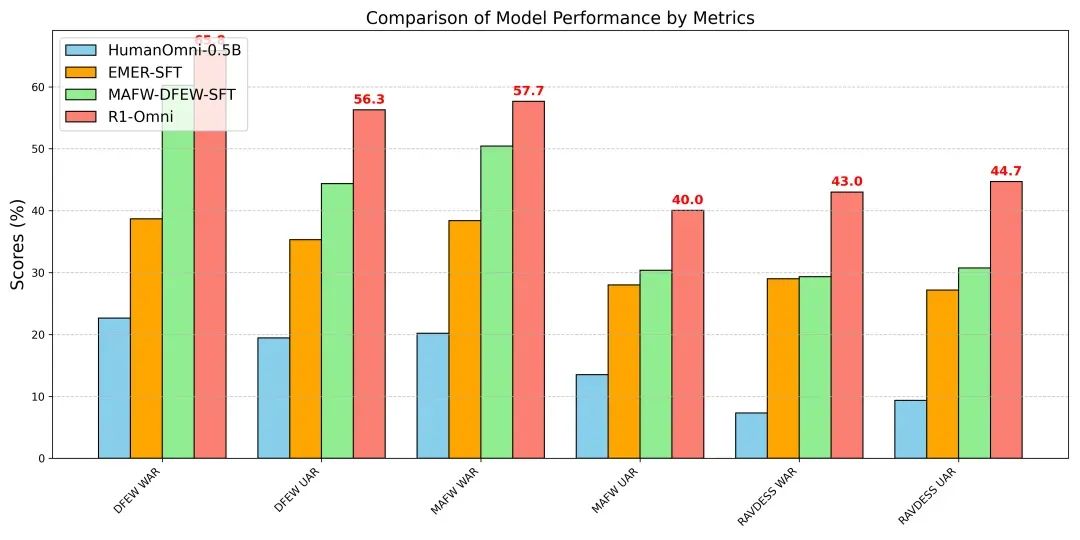

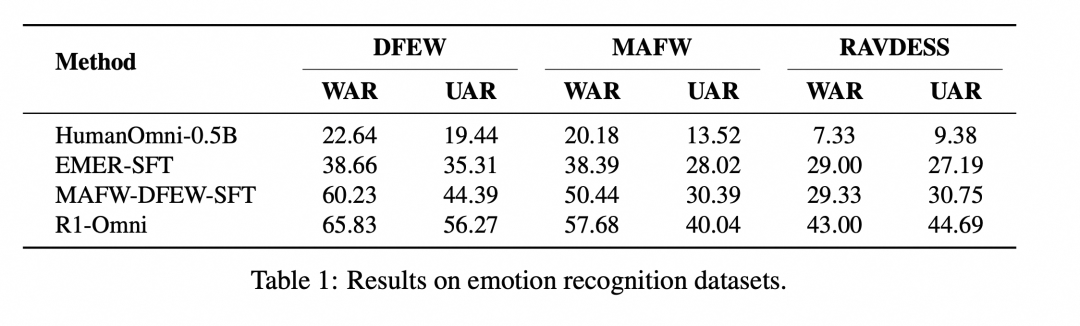

为验证 R1-Omni 的效果,通义实验室团队将其与原始的 HumanOmni-0.5B 模型、冷启动阶段模型以及在 MAFW 和 DFEW 数据集上进行监督微调的模型进行了比较。

实验结果表明,在同分布测试集(DFEW 和 MAFW)上,R1-Omni 相比原始基线模型平均提升超过 35%,在 UAR 上相比 SFT 模型则提升超出 10%。在不同分布的测试集(RAVDESS)上,R1-Omni 也展现了优秀的泛化能力,WAR 和 UAR 均提升超过 13%。这些结果充分验证了 RLVR 在增强推理能力和泛化性能方面的显著优势。

以下是 R1-Omni 的开源链接:

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...