美团开源首发 INT8 无损满血版 DeepSeek R1,部署 A100 实现 50% 吞吐提升

GoodNav 3 月 7 日消息,美团的机器学习团队于 3 月 4 日发布了最新的开源成果,成功实现了对 DeepSeek R1 模型几乎无损的 INT8 精度量化。

DeepSeek R1 的原始模型权重使用 FP8 数据格式,对 GPU 芯片类型存在严格限制,仅支持英伟达的新型 GPU(如 Ada 和 Hopper 架构的芯片),而其他型号的 GPU(如 A100)则无法直接进行部署。

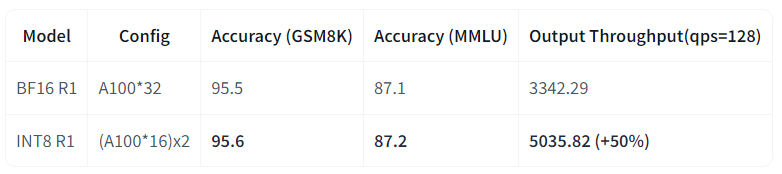

目前,量化代码已被纳入开源的 LLM 推理框架 SGLang,量化模型也已上传到 Hugging Face 社区,以便用户使用。根据官方测试,在 A100 上部署满血版 DeepSeek R1,基于 INT8 量化相比 BF16 提高了 50% 的吞吐量。

开源地址如下:

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...