阿里云推出最新通义千问 QwQ-32B 推理模型,仅 1/20 参数媲美 DeepSeek R1

GoodNav 3 月 6 日报道,研究表明,强化学习显著提升了模型的推理能力,例如 DeepSeek-R1 通过整合冷启动数据和多阶段训练,达到最先进的表现,使其能够进行深度思考和复杂推理。

阿里云通义千问官方今日发布了最新的推理模型 QwQ-32B。这款模型具有320亿参数,其性能可与包含6710亿参数(其中370亿被激活)的 DeepSeek-R1 相媲美。

这一成果突显了将强化学习应用于经过大规模预训练的强大基础模型的有效性。此外,我们在推理模型中集成了与 Agent 相关的能力,使其在使用工具时能够进行批判性思考,并根据环境反馈调整推理过程。

目前,QwQ-32B 已在 Hugging Face (https://huggingface.co/Qwen/QwQ-32B) 和 ModelScope (https://modelscope.cn/models/Qwen/QwQ-32B) 开源,并遵循 Apache 2.0 开源协议。同时,用户还可以通过Qwen Chat(https://chat.qwen.ai/?models=Qwen2.5-Plus)直接体验。

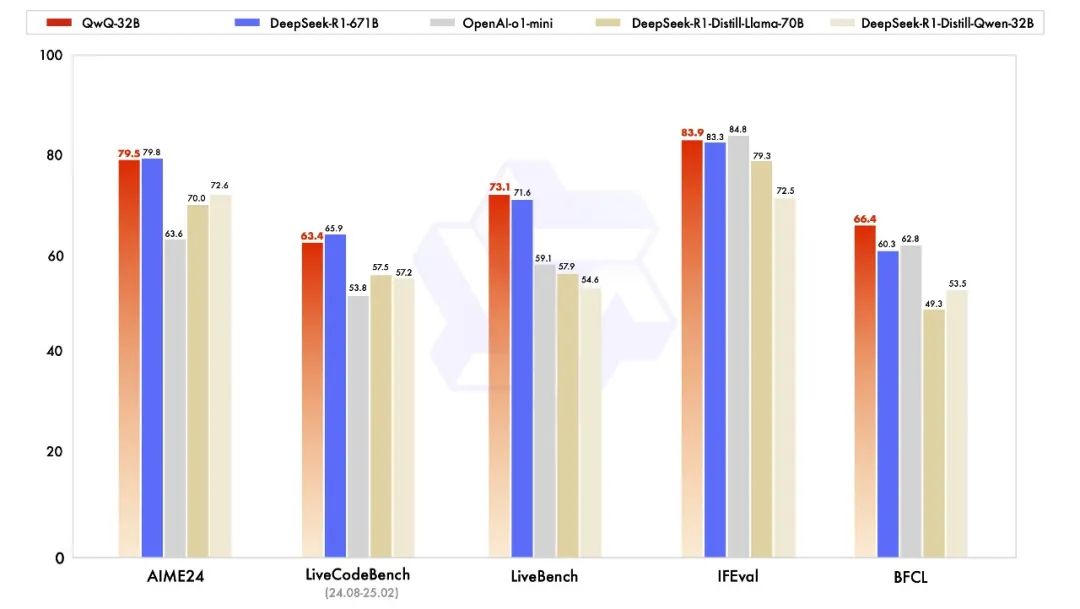

在性能测试方面,阿里云对 QwQ-32B 进行了数学推理、编程能力及通用能力的评估,并展示了其与其他领先模型的性能对比,包括 DeepSeek-R1-Distilled-Qwen-32B、DeepSeek-R1-Distilled-Llama-70B、o1-mini 以及原始的 DeepSeek-R1。

在数学能力测试的 AIME24 评测集和评估代码能力的 LiveCodeBench 中,千问 QwQ-32B 表现与 DeepSeek-R1 不相上下,显著优于 o1-mini 及同尺寸的 R1 蒸馏模型;在由 Meta 首席科学家杨立昆主导的“最难 LLMs 评测榜” LiveBench、谷歌等提议的指令遵循能力 IFEval 评测集,以及由加州大学伯克利分校等发起的评估准确调用函数或工具的 BFCL 测试中,千问 QwQ-32B 的得分都超过了 DeepSeek-R1。

阿里云表示,这是 Qwen 在大规模强化学习(RL)以增强推理能力方面的重要起步。通过这一过程,我们不仅看到了扩展 RL 的巨大潜力,也发现了预训练语言模型中尚未开发的可能性。

在开发下一代 Qwen 的过程中,阿里云计划将更强大的基础模型与规模化计算资源支持的 RL 相结合,以促进朝人工通用智能(AGI)迈进。此外,阿里云正在积极探索将智能体与 RL 整合,实现长时推理,旨在通过推理时间的延伸来释放更高的智能,敬请期待。