AI 玩《超级马力欧兄弟》:Claude 3.7 操作最溜,推理模型表现不佳

GoodNav 3 月 4 日报道,加利福尼亚大学圣地亚哥分校的 Hao 人工智能实验室(Hao AI Lab)于上周五开展了一个创新研究,将人工智能(AI)应用于经典游戏《超级马力欧兄弟》,以评估其性能。研究结果表明,在参与测试的 AI 模型中,Anthropic 的 Claude 3.7 表现最佳,其次是 Claude 3.5。相较之下,谷歌的 Gemini 1.5 Pro 和 OpenAI 的 GPT-4o 则表现不尽如人意。

需要指出的是,此次实验所使用的并非1985年最早发布的《超级马力欧兄弟》版本。游戏是在一个模拟器上运行,并通过一套名为 GamingAgent 的框架与 AI 进行连接,使 AI 能够控制马力欧。GamingAgent 是 Hao 人工智能实验室自主开发的,它为 AI 提供基本指令,例如“如果附近有障碍物或敌人,就向左移动或跳跃以避免”,同时还提供游戏中的截图。之后,AI 通过生成 Python 代码的方式来操控马力欧。

根据实验室的描述,这个游戏环境迫使每个 AI 模型“学习”如何计划复杂操作和制定游戏策略。有趣的是,实验显示像 OpenAI 的 o1 这种推理模型(通过逐步思考问题来得出解决方案)表现逊色于“非推理”模型,尽管它们在大多数基准测试中通常表现更佳。研究人员指出,推理模型在实时游戏中的劣势之一是其通常需要数秒的时间来决策。而在《超级马力欧兄弟》中,时机至关重要,哪怕是短短一秒的差距可能意味着安全通过或坠落死亡的不同结果。

多年来,游戏一直是衡量 AI 性能的重要方法。然而,部分专家对直接将 AI 在游戏中的表现与技术进步结合的做法表示质疑。与现实世界相比,游戏通常较为抽象且简单,并且能够理论上为 AI 训练提供无限的数据。

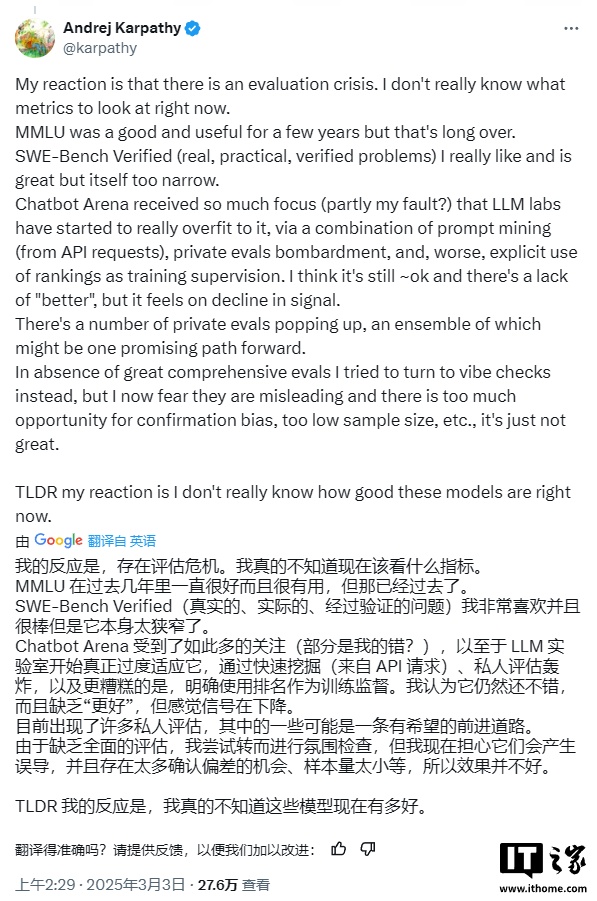

值得注意的是,最近一些引起关注的游戏基准测试结果激起了 OpenAI 研究科学家与创始成员安德烈·卡帕西(Andrej Karpathy)所提到的“评估危机”。他在 X 平台上的一篇帖子中写到:“我现在真的不知道该关注哪些 AI 指标。”他总结道:“我的反应是,我实在不知道这些模型的实际表现有多好。”

尽管如此,至少我们依然可以观看 AI 玩马力欧,这本身就是一种有趣的体验。