Hugging Face 研究“AI 降本增效”:给予更长运算时间让低成本小模型输出比拟大模型准确结果

GoodNav 12 月 29 日报道,当前行业中的模型性能往往与训练时投入的资源成正比。除了大型公司在模型训练上花费巨大资源,很多小型企业和独立开发者却缺乏足够的资金。为了解决这个问题,许多团队正在努力探索降低成本、提高效率的替代方案。

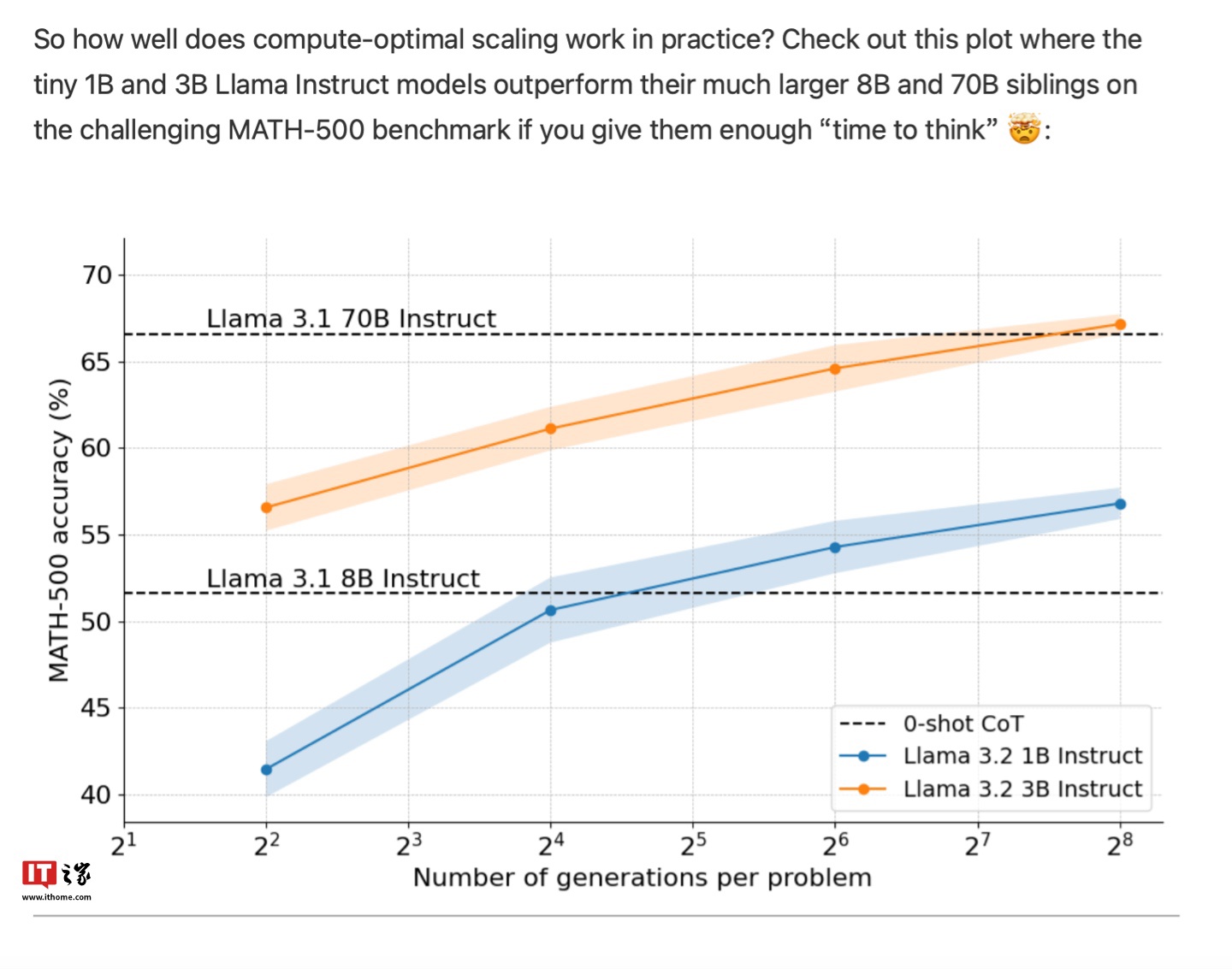

Hugging Face 在本月中旬发布了一份报告,提出了一种名为“扩展测试时计算”(Test-Time Compute Scaling)的方法,即通过延长计算时间来补偿模型的较小规模。他们提出给予“低成本小模型”充分的时间,使其能对复杂问题生成大量输出,并利用验证器对这些结果进行评估和修正,从而反复输出,与“高成本大模型”相媲美的结果。

Hugging Face 团队表示,他们利用这种方法,通过 10 亿参数的 Llama 模型进行了数学基准测试,声称在某些情况下超越了参数量高达 70 亿的大型模型,验证了通过延长计算时间提升模型输出效果的可行性。

此外,谷歌 DeepMind 最近也发布了类似的研究论文,认为可以动态为小模型分配计算资源,并设置验证器对模型的输出结果进行评分,以引导模型持续生成正确答案,帮助企业用较少的资源部署满足精度要求的语言模型。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...