ModernBERT 模型公布,接任“Hugging Face 下载榜第二”2018 年经典原版

GoodNav 12月29日消息,Hugging Face、NVIDIA及约翰霍普金斯大学的研究团队联合推出了热门编码器模型BERT的新版本——ModernBERT,该版本声称在保持效率的同时,新增了对长达8192个Token的上下文处理能力。

开发团队表示,自2018年发布BERT模型以来,尽管该模型仍被广泛应用,并在Hugging Face的下载排行榜中名列第二,仅次于RoBERTa,每月下载量超过6800万次,但如今这款模型已经显得有些过时。

在BERT模型首次发布六年后,Hugging Face和其他团队借鉴了近年来大规模语言模型的发展,对BERT的架构和训练过程进行了改进,最终推出了ModernBERT模型,以替代原版BERT。

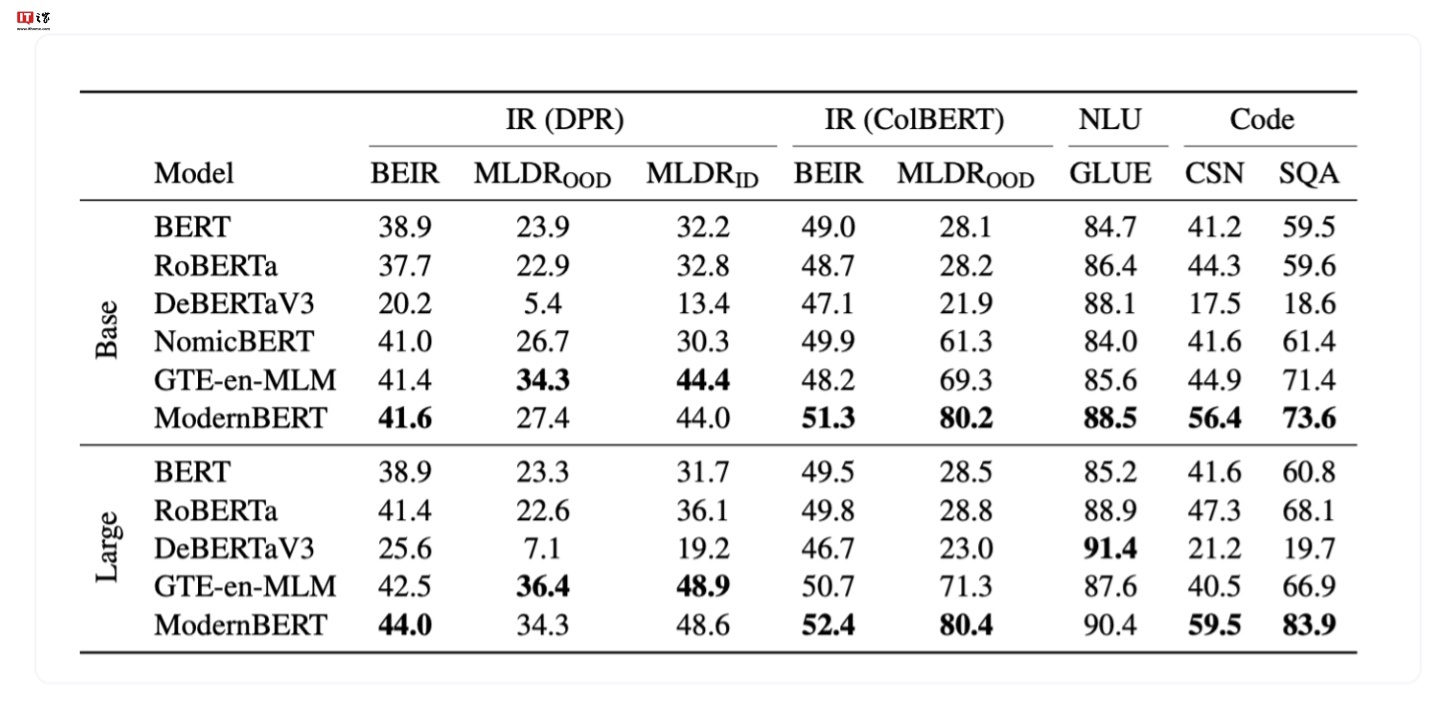

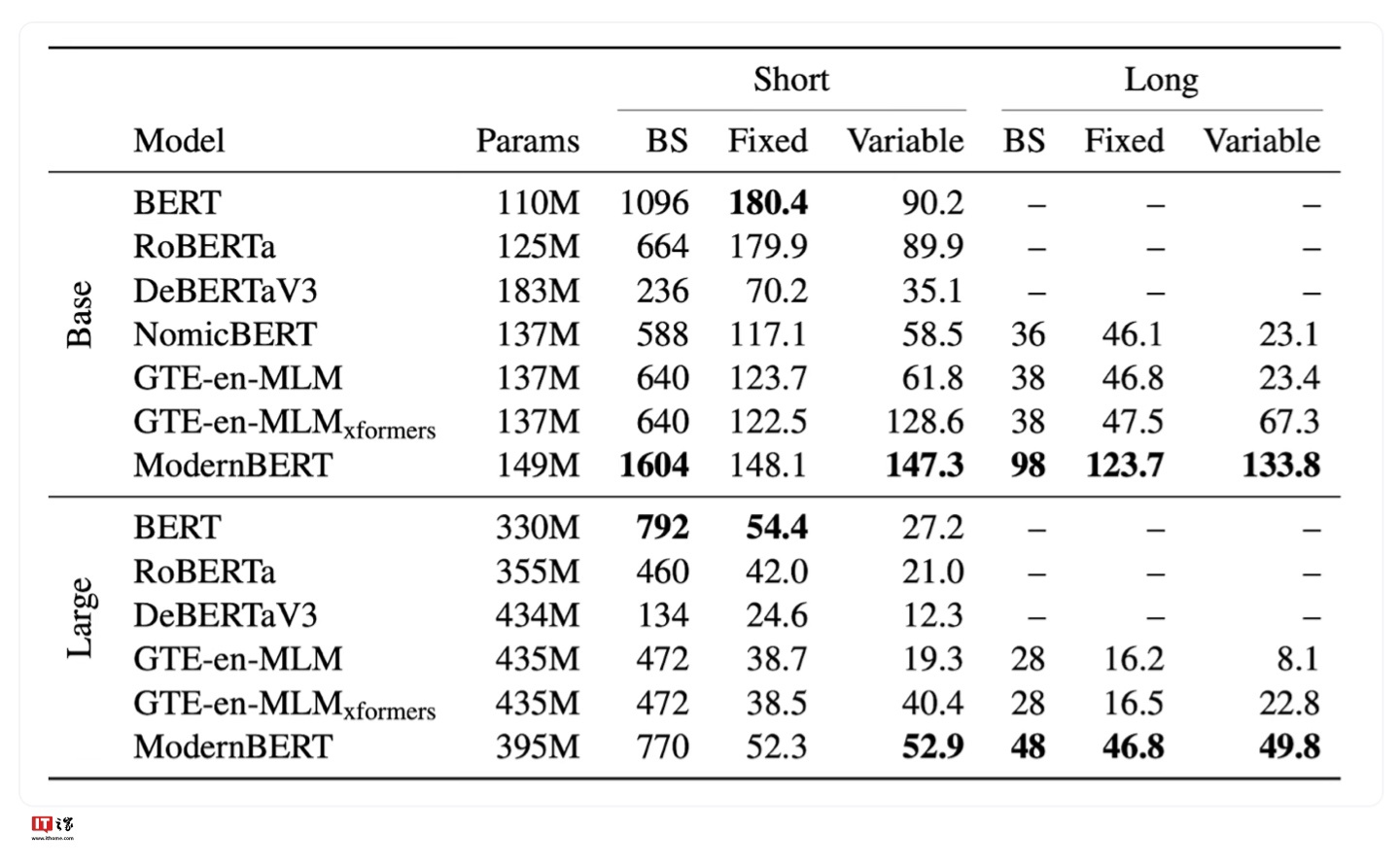

据悉,相关开发团队使用了20000亿个Token进行ModernBERT的训练,使得该模型在多项分类测试和向量检索测试中达到了业内领先水平。目前,开发团队已公布了两个版本的模型,分别为1.39亿参数和3.95亿参数版本,项目地址如下(点此访问)。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...