“深思熟虑”的 AI:OpenAI 提出全新安全对齐方法

GoodNav 12 月 25 日报道,OpenAI 的研究团队提出了一种新方法,名为“深思熟虑的对齐”(Deliberative Alignment),旨在提高 AI 模型的安全性,并且在 o 系列模型中已经取得了显著的成果。

项目背景

确保大型语言模型(LLMs)遵循明确的道德和安全标准目前面临许多挑战。现有的对齐技术,如监督微调(SFT)和基于人类反馈的强化学习(RLHF),存在一些局限性,包括被操纵的风险,这可能导致生成有害内容、拒绝合理请求、或在陌生场景下处理困难等问题。

这些问题往往源于当前安全培训的缺陷,即模型通过数据间接推断标准,而非直接学习。这种方法通常缺乏对复杂提示的考虑,限制了它们在微妙或对抗性情境中的表现。

深思熟虑的对齐(Deliberative Alignment)

备注:该方法通过直接教导模型安全规范,训练模型在生成响应之前推理这些规范,将安全原则融入推理过程。

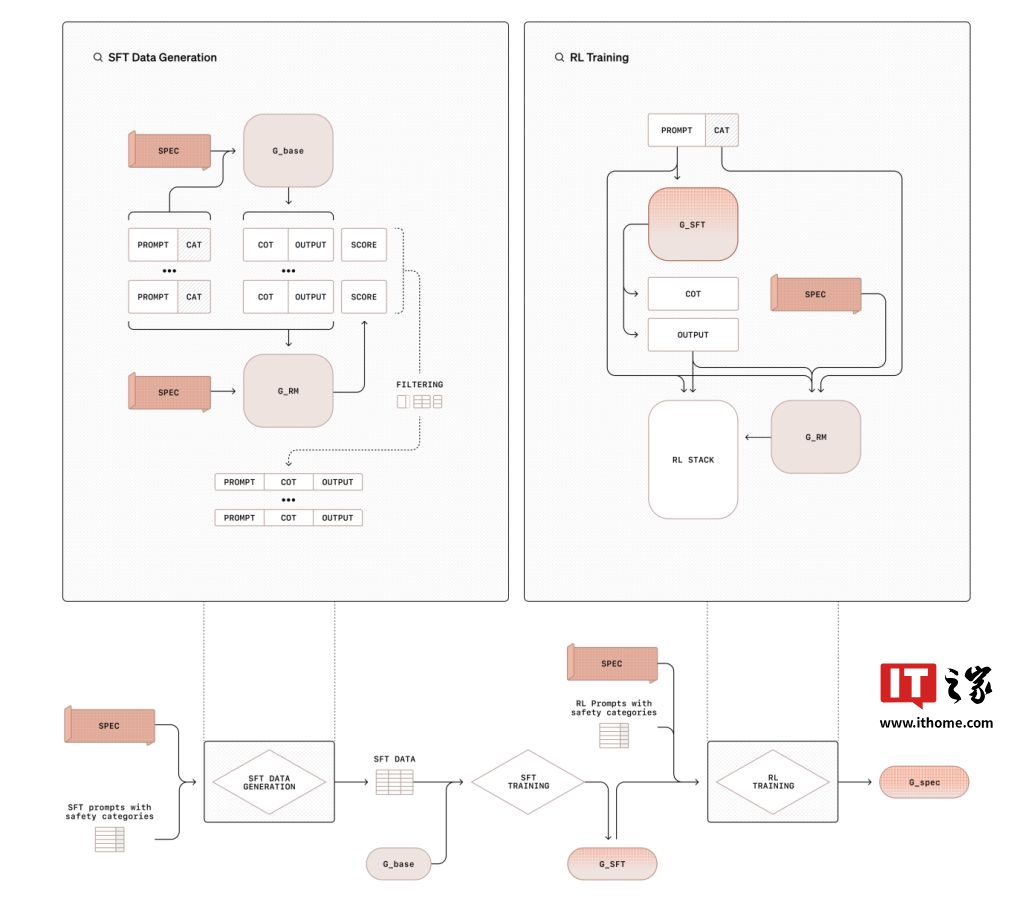

整个过程分为两个阶段。第一阶段,利用监督微调(SFT)训练模型参考并推理安全规范,利用从基础模型生成的数据集。第二阶段则是通过强化学习(RL),使用奖励模型根据安全基准评估性能,进一步优化模型的推理能力。

与依赖人工标注数据的方法不同,“深思熟虑的对齐”使用模型生成的数据和思维链(CoT)推理,显著降低了安全训练对资源的需求。

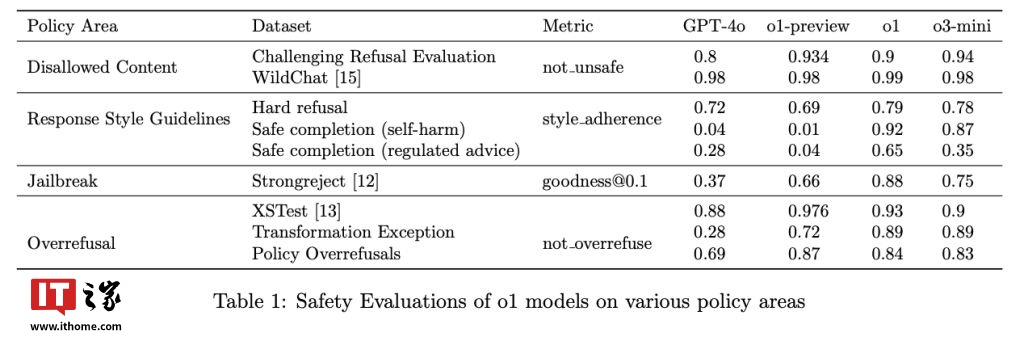

OpenAI 的 o1 模型已经应用了该技术,在抵抗越狱提示方面表现优异,StrongREJECT 基准测试中得分高达 0.88,远超 GPT-4o 的 0.37;此外,该技术还有效减少误拒,在 XSTest 数据集中,o1 模型对于良性提示的准确率达到 93%。

“深思熟虑的对齐”通过训练模型进行明确的安全策略推理,为复杂的伦理挑战提供了可扩展且可解释的解决方案。

参考

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...