沃顿商学院教授发文解析 o1:能力仍有短板,「人机协同智能」或成 AGI 最重要难题

OpenAI 最近发布了全新的 o1 Pro 版本,这一系列的模型到底有何强大之处?它是否能为人工智能的发展指明方向?沃顿商学院的教授在三个月前的一篇博客中给予了「神预言」般的回答。

o1 preview 发布三个月后,满血版的 o1 Pro 上周以每月 200 美元的价格正式上线,阿尔特曼称其为「当今最智能的模型」。

那么,正式的 o1 Pro 到底有多强大呢?

显然,它不是通向 AGI 终点的超级存在,但这是 scaling law 之后的一个重要里程碑吗?它是否代表着未来大语言模型(LLM)的发展方向?是否如 OpenAI 的研究者 Jason Wei 所言,足以成为一个「传奇」?

就在 o1 Pro 发布时,沃顿商学院副教授、GenAI 实验室联合主任 Ethan Mollick 提到他三个月前撰写的博客,这篇博文既可以视为模型发布前的「神预言」,同时也像是一盆有理有据的「冷水」。

Ethan Mollick 指出,早在 9 月我们第一次见到 o1 preview 时,他就撰写了这篇文章,详尽阐述该模型对当前及未来的意义。虽然模型质量重要,但更关键的是理解其对人工智能未来潜在的影响。

接下来,我们将通过这篇文章作为时间的桥梁,将三个月前突出的 o1 preview 和现阶段的 o1 Pro 进行对比,或许能为当下带来更多启示。

「草莓」大显身手

不久前,我接触到了备受关注的被称为「草莓」的增强型推理系统,现在 OpenAI 已经发布了它,我终于可以分享我的看法。

这个模型确实令人惊讶,但其能力依然有限,最值得关注的是,它的出现指引了人工智能的发展趋势。

新模型命名为 o1-preview(Mollick 对 OpenAI 等人工智能公司的命名感到不满),它使得 AI 在解决问题之前先进行思考,从而可以处理需要规划和迭代的复杂问题。

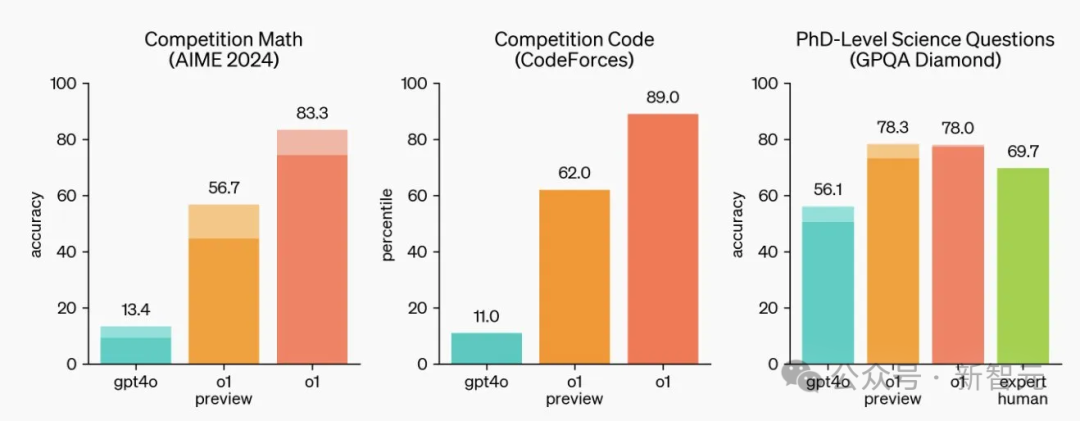

根据熟悉的基准结果图,o1-preview 在数学和科学领域表现尤为突出,甚至在一些极其困难的物理问题上超过了博士级别的人类专家。

但要明确的是,o1-preview 不是在所有方面都有提升,例如在写作方面并未优于 GPT-4o;但在需要计划的任务上,变化显著。

由于评估复杂任务输出较为困难,展示「草莓」模型的改进(及一些限制)可以通过游戏来表明——比如填字游戏(crossword puzzle)。

不要小看填字游戏,它的下限很低,但上限极高,最难的填字游戏可达地狱模式,且非常考验逻辑推理能力。

电影《模仿游戏》中有这样的情节:二战期间,人工智能之父 Alan Turing 负责英国的密码破译项目 Enigma 为了招募数学和密码学人才,他在报纸上登出了一个填字游戏作为测试,最后的现场考核也是要求参与者在规定时间内进行填字游戏。

电影《模仿游戏》剧照

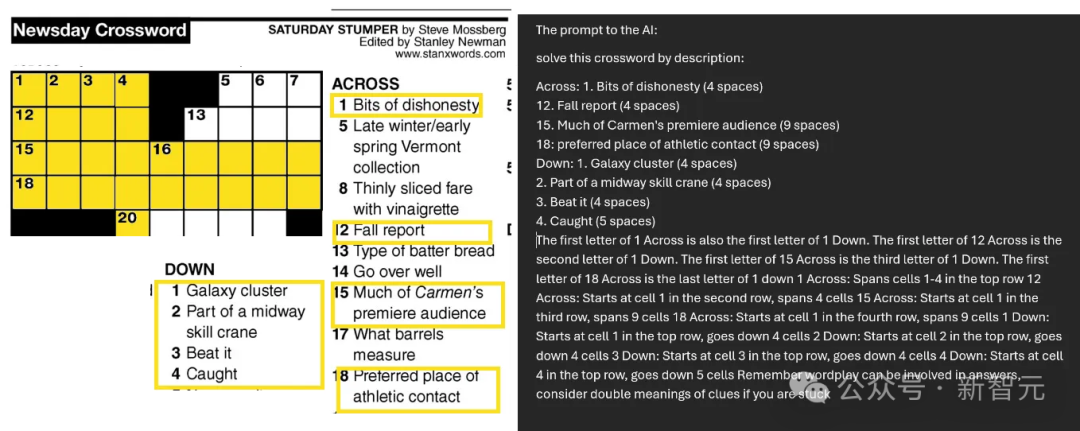

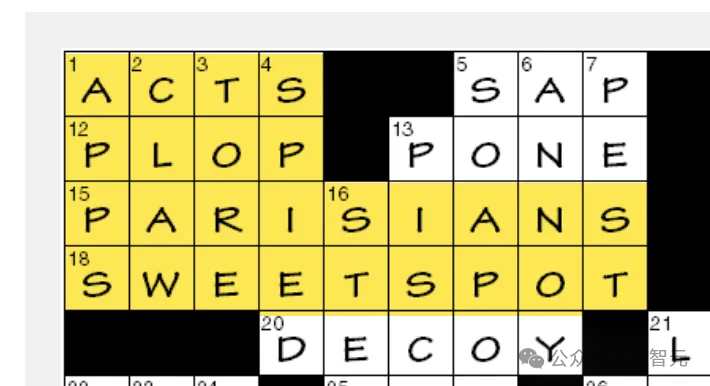

由于 o1 preview 还无法从图像中提取文本,Mollick 只能手动输入线索以供模型使用。下图为一个相当具有挑战性的难题,而 Mollick 仅选取了 18 条线索中的 8 条提供给 o1。

填字游戏对 LLM 尤其困难,因为需要迭代的方式来解决:尝试并逐步排除多个相互关联的答案——这是之前的大型模型无法做到的,因为它们一次只能添加一个 token/单词。

如下图所示,若给 Claude 提供线索,它首先给出序号 1 的答案(猜测为 STAR,但该答案错误),然后基于此尝试解答其余部分。

然而,由于第一步就出错了,Claude 永远无法接近正确答案。如果没有良好的规划流程,它只能盲目前进,而不知自己前进的方向是否正确。

Claude 的尝试

而面对同样的问题时,「草莓」会如何处理呢?

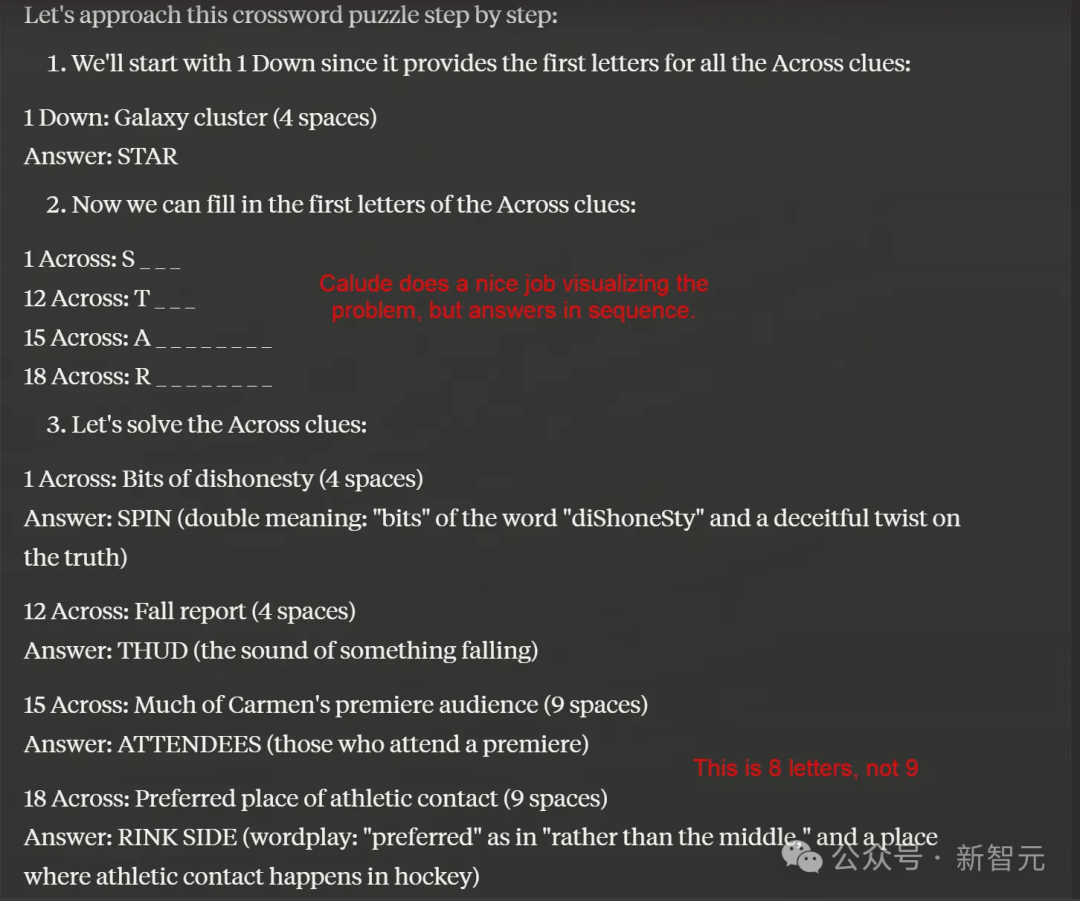

它会首先开始「思考」,这个过程持续了整整 108 秒(但大多数问题都能更快解决)。

而且,o1 在思考时不是无声无息,而是会「自言自语」,输出它的「思维链」,让你看到它的思考过程。以下是其中一个示例(还有更多未展示内容),这些想法非常启发人,值得花时间阅读。

在这个过程中,「草莓」反复迭代,不断创造想法,最终结果令人印象深刻。

但需注意的是,o1-preview 似乎仍然基于 GPT-4o,并且在语义理解上有时过于拘泥于字面意思。

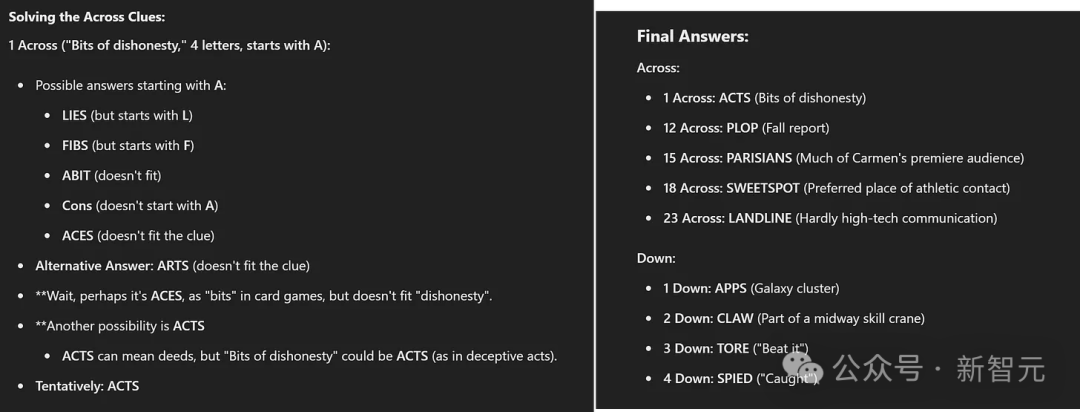

例如,下图右侧的 1 Down 答案为「Galaxy cluster」,这显然不是在指真正的星系,而是指三星 Galaxy 手机——「APPS」。

该 AI 没有识别到这一层含义,而是不断尝试各种星系团的名称,最终认定 Down 1 是 COMA(真实存在的星系团),可想而知其他结果也不正确。虽然并不完全符合规则,但也相当具创意。

公平起见,Mollick 本人也未能识别这一层意思。如果将「Down 1 是 APPS」这个线索提供给 o1,便可以看到模型在接下来的 1 分钟内迅速迭代出想法(下图左侧),并正确推导出了 Across 1 的答案是「ACTS」。

这是 o1 基于线索得出的最终答案,完全正确,成功解决了难题,尽管它虚构了一条不存在的新线索。相比之下,作为副教授的 Ethan Mollick 甚至连这个正确答案都未能接近。

由此我们可以发现,o1-preview 实现了一些「草莓」所不能完成的任务,但它依然不是无懈可击:错误和幻觉依然存在,仍然受到底层模型 GPT-4o 限制的影响。

虽然 Claude 有很多优点,但在复杂规划或解题方面,o1 的表现远远优于,代表了这些领域的巨大飞跃。

从协同智能到…

o1-preview 显示出我们正面临人工智能范式的转变。「规划」是智能体的一种表现形式,人工智能能在没有人类辅助的情况下得出结论和解决问题。

从上述例子可以看出,AI 完成了很多繁重的思考工作,并生成了完整的结果,人类作为合作伙伴的角色反而被弱化,整个过程由 AI 主导并给出答案。

当然,我们可以筛选推理链的输出,发现 AI 的错误,但 Ethan Mollick 感觉在他作为任务布置者和 AI 输出内容之间,包括在引导解决方案的过程中,几乎没有任何联系。这未必是坏事,但显然与以往不同。

随着这些系统的不断升级,并逐渐接近真正的自主智能体,我们需要弄清人类如何与它们保持同步——既要捕捉错误,又要及时察觉到我们正在尝试解决的问题。

o1-preview 正在缓缓拉开序幕,解锁我们尚未见过的人工智能能力,尽管它目前仍然存在局限。这给我们提出了一个关键问题:随着人工智能的发展,我们如何进化人类与 AI 的合作?这是 o1-preview 目前无法解答的问题。

参考资料:

-

https://x.com/emollick/status/1864857524840616345

本文来自微信公众号:新智元(ID:AI_era)