美国哥伦比亚大学研究:大语言模型正在变得越来越像人类大脑

GoodNav 在 12 月 20 日报道,经过几年的发展,以 ChatGPT 为代表的大型语言模型(LLMs)在理解和生成自然语言方面的能力逐渐增强,但这些模型在多大程度上能够模拟人脑在语言处理过程中所使用的神经机制,仍然有待更深入的研究。

据 Tech Xplore 18 日的报道,哥伦比亚大学及费因斯坦医学研究所的研究小组最近进行了相关研究,旨在探讨 LLM 与人脑神经反应之间的相似性。研究发现,随着 LLM 技术的不断进步,这些模型不仅在性能方面取得了显著提升,而且在结构上也与人类大脑越来越相似。

论文的第一作者加文·米施勒(Gavin Mischler)在接受 Tech Xplore 采访时表示:“撰写这篇论文的灵感来源于近年来 LLM 和神经 AI 研究的快速发展。”

“几年前,一些研究显示 GPT-2 的词嵌入与人脑对语言的神经反应有一定的相似性,但在这个快速发展的人工智能领域,GPT-2 目前已算不上最强。”

“自从 ChatGPT 发布以来,涌现出了许多性能更强的模型,但关于这些新模型是否依然表现出相似的大脑特征的研究却相对较少。”

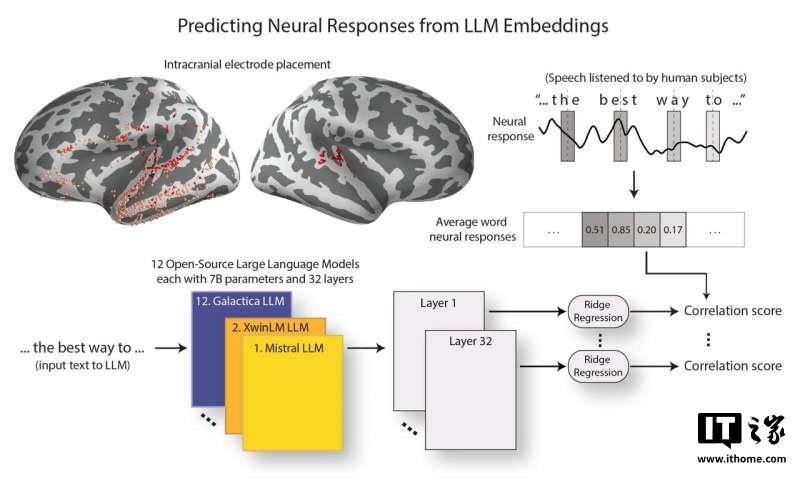

米施勒及其团队的主要目标是探讨最新一代 LLM 是否仍然展现与人类大脑的类似特征。研究团队对 12 种不同的开源 LLM 进行了分析,这些模型在架构和参数数量方面几乎相同。同时,他们通过在神经外科患者的脑部植入电极来记录患者听到语言时的大脑反应。

米施勒解释说:“我们将相同的演讲文本输入 LLM,并提取其词嵌入,这些嵌入是模型内部用来处理和编码文本的表示。为了评估 LLM 与大脑的相似性,我们尝试预测大脑对词语反应的神经活动,借此了解它们的对应关系。”

在数据收集之后,研究团队利用计算工具分析了 LLM 与大脑的对齐程度,特别关注与语言处理相关的大脑区域和 LLM 的哪个层次最为匹配。已知大脑对语言的反应是通过对语音的声学、语音学等成分的逐步分析,建立语言的抽象表征。

米施勒表示:“我们的研究发现,随着 LLM 能力的提高,其词嵌入与大脑对语言反应的相似性也在上升。更令人惊讶的是,随着模型性能的提升,它们与大脑层次结构之间的对齐程度也在增加。这意味着,在语言处理过程中大脑不同区域提取的信息,与高性能 LLM 的不同层次提取的信息之间更加一致。”

这些研究成果表明,表现最优的 LLM 更准确地反映了大脑的语言处理反应。此外,这些模型的优异表现可能与其早期层次的高效性有关。

相关研究结果已在《自然・机器智能》期刊上发表,链接为:点此前往