Meta 推出 Apollo 开源模型,让 AI “看懂”视频

GoodNav于12月18日报道,Meta与斯坦福大学合作,推出了一系列新的AI模型Apollo,显著提升了机器对视频内容的理解能力。

需要注意的是,尽管人工智能在图像和文本处理上已取得显著进展,然而让机器真正理解视频仍然是一个巨大的挑战。

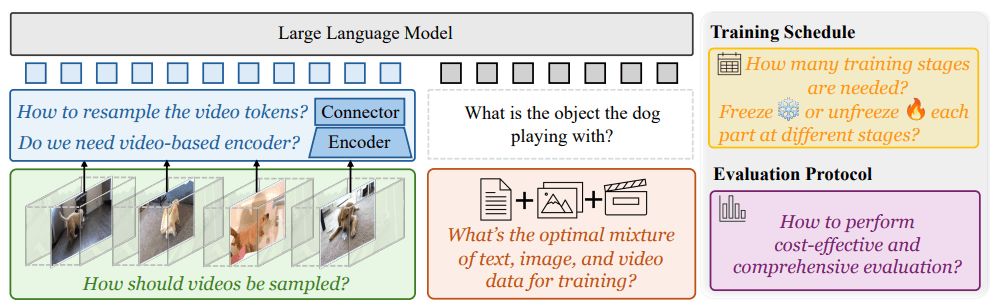

视频中包含复杂且动态的信息,处理这些信息对人工智能来说更加困难,不仅需要更强的计算能力,还面临设计最佳AI视频解读系统的诸多挑战。

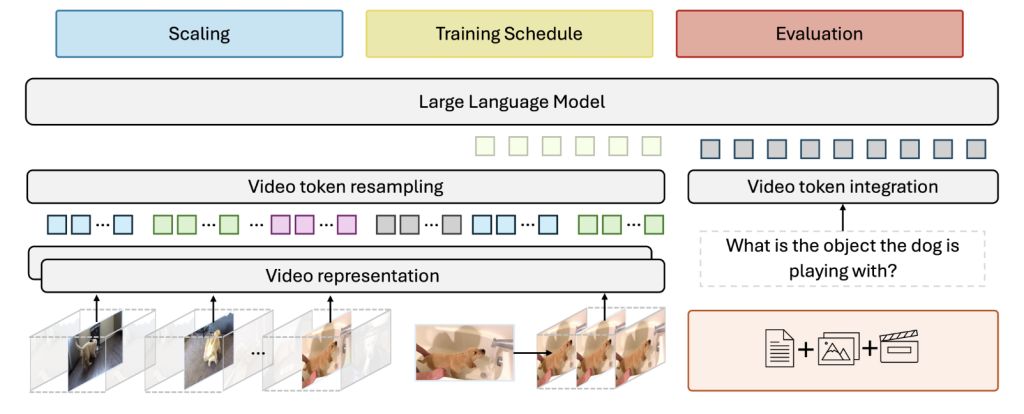

在视频处理研究中,研究者们发现,保持每秒恒定的帧采样率能够得到最佳效果。因此,Apollo模型使用了两个不同的组件,一个用于处理单独的视频帧,另一个用于跟踪对象及场景随时间的变化。

此外,在处理后的视频片段之间添加时间戳,有助于模型理解视觉信息与文本描述之间的关系,从而保持时间感知。

在模型训练方面,团队的研究显示,训练方法的重要性高于模型的大小。Apollo模型采用分阶段训练的方式,按顺序激活模型的不同部分,这种方式优于一次性训练所有部分。

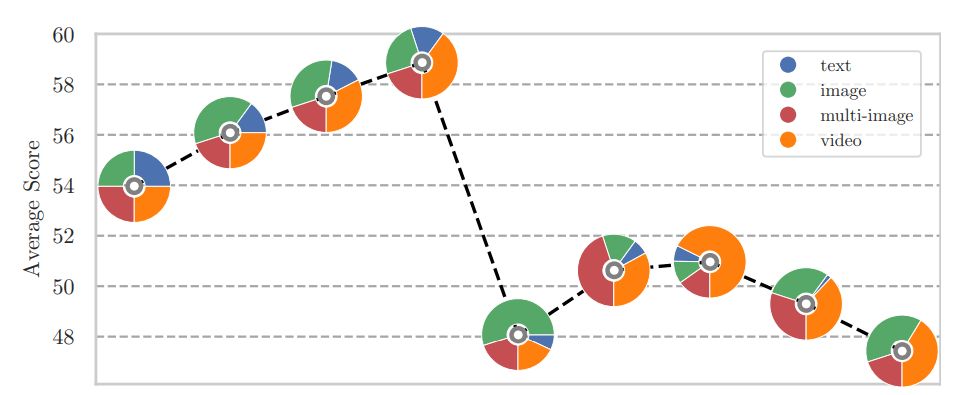

此外,Meta还不断优化数据组合,发现10~14%的文本数据,剩余部分则略微偏向视频内容,以更好地平衡语言理解与视频处理能力。

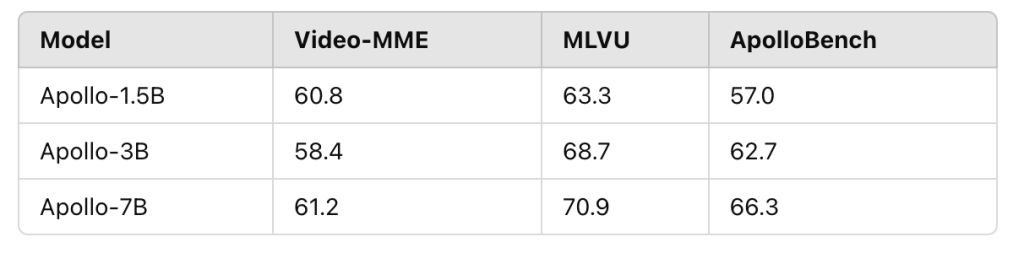

Apollo模型在各个规模上均表现出色,较小的Apollo-3B超越了Qwen2-VL等同规模的模型,而Apollo-7B则超越了更大参数的同类模型。Meta已开源了Apollo的代码和模型权重,并在Hugging Face平台上提供公开演示。

参考

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...