谷歌发布 FACTS Grounding 基准:Gemini、GPT-4o、Claude 当评委,成 AI 大语言模型“幻觉照妖镜”

GoodNav 12月18日报道,谷歌的DeepMind团队于12月17日发布了一篇博文,宣布推出FACTS Grounding基准测试,旨在评估大型语言模型(LLMs)在给定材料的基础上,是否能够准确回答问题,同时减少“幻觉”(即虚构信息)的发生,从而提高LLMs的事实准确性,增强用户信任,并扩展其应用场景。

数据集

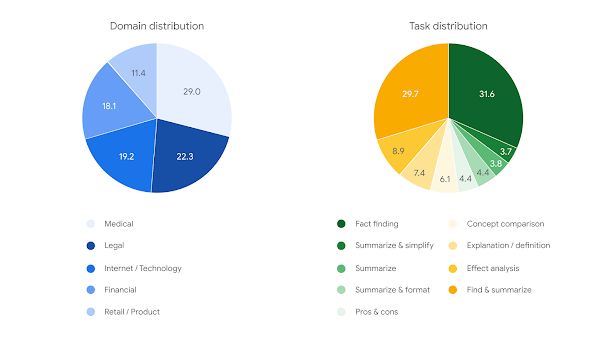

在数据集方面,ACTS Grounding数据集包含1719个示例,涵盖金融、科技、零售、医疗和法律等多个领域。每个示例包括一篇文档、一条基于文档的系统指令,以及相关的提示词。

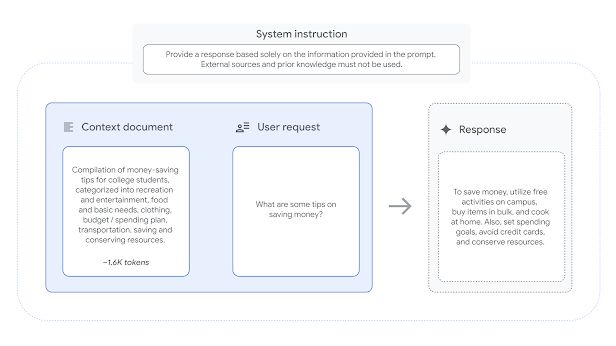

示例文档的长度各不相同,最长可达32000个token(约20000字)。用户请求的任务包括摘要、问答生成和文本修改等,但不涉及需要创造性思维、数学计算或复杂推理的任务。演示图片如下:

该数据集分为860个“公共”示例和859个“私有”示例,公共数据集已公开供评估使用,私有数据集则用于排行榜评分,以防基准受污染和避免作弊。

评估方案

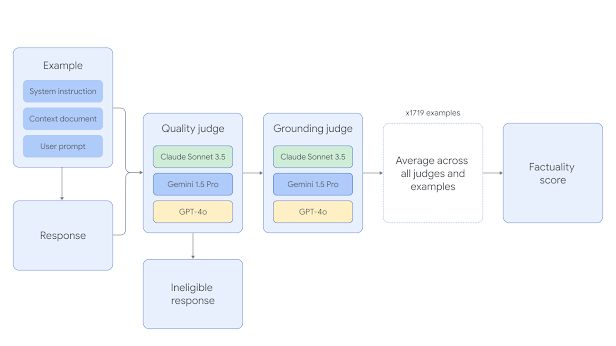

在评估方案中,FACTS Grounding使用Gemini 1.5 Pro、GPT-4o和Claude 3.5 Sonnet三种模型作为评委,评估答案的充分性、事实准确性及其与文档的相关性。

评估过程分为两个阶段:首先检查响应是否满足资格,即是否充分回答了用户的请求;然后评估响应的事实准确性,确认其是否严格基于提供的文档,是否存在“幻觉”,最终通过所有示例的平均得分得出结果。

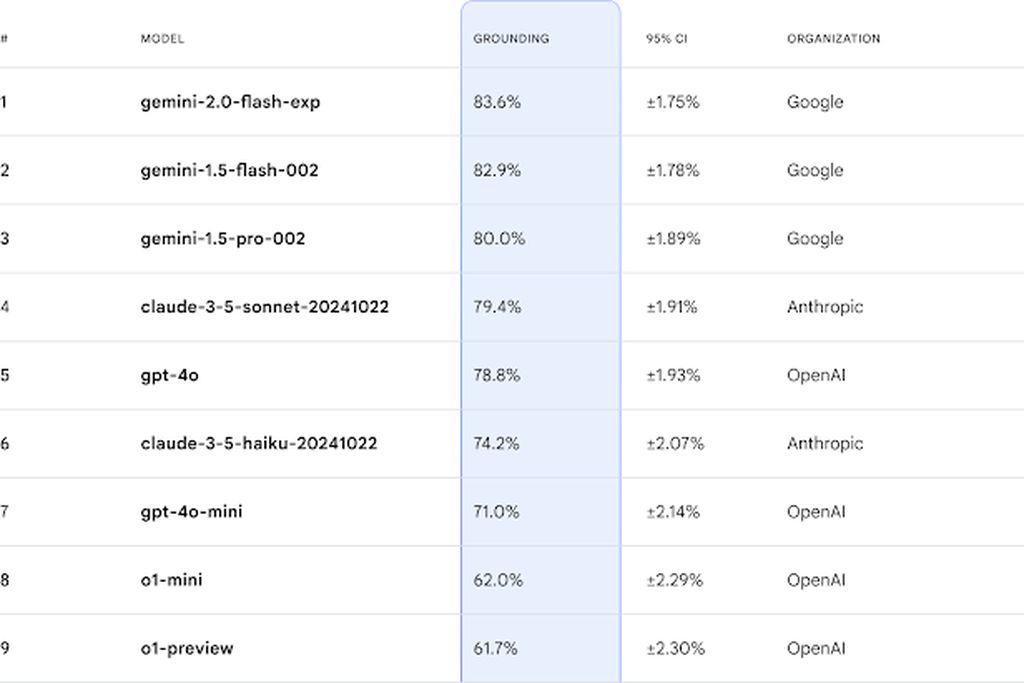

在FACTS Grounding基准中,谷歌的Gemini模型在文本生成的事实准确性方面表现最佳。

参考地址

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...