语言游戏让 AI 自我进化,谷歌 DeepMind 推出苏格拉底式学习

在没有外部数据的情况下,AI 能否自行进化?

这个问题听起来颇为惊悚,因此谷歌 DeepMind 的相关研究迅速引发了广泛关注。

论文链接:https://arxiv.org/pdf/2411.16905

这项新方法被称为「苏格拉底式学习」(Socratic Learning),它能够让 AI 系统自主地进行递归增强,超越初始的训练数据限制。

研究者表示,只要满足以下三个条件,训练于封闭系统的智能体就可以掌握所需的各种能力:

a)接收足够数量的一致反馈;

b)经验/数据的覆盖范围必须足够广泛;

c)具备足够的能力和资源。

本文探讨了在假设条件 c)不构成瓶颈的情况下,封闭系统中的 a)和 b)可能带来的限制。

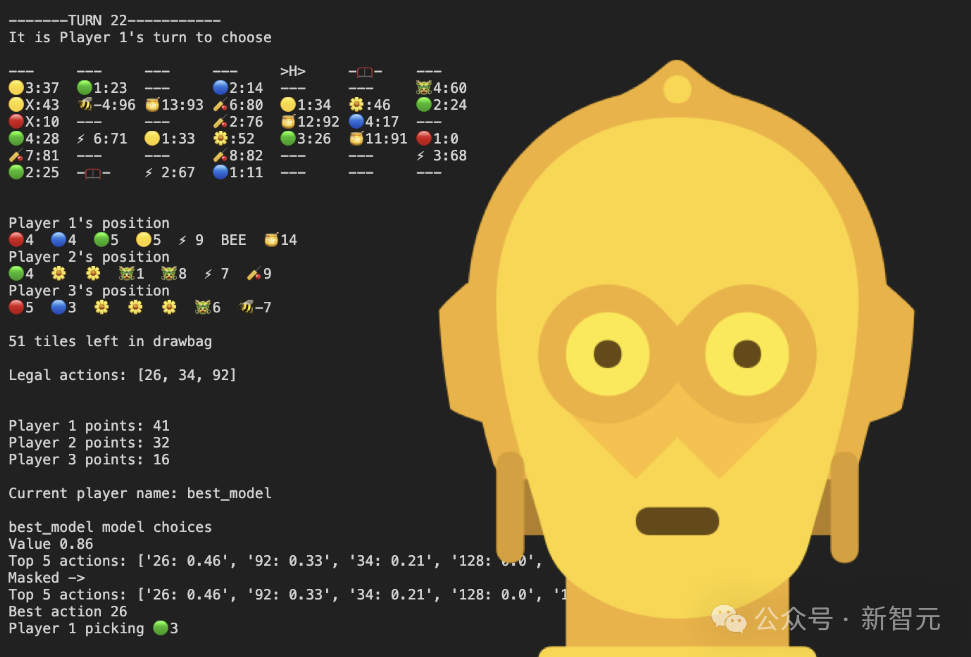

苏格拉底式学习的核心在于语言游戏(即结构化互动),智能体可以在其中交流、解决问题,并接收反馈(以分数的形式)。

在这个过程中,AI 在封闭环境中自主进行游戏,生成数据并提升自身能力,无需外部输入。如果游戏失去趣味,AI 还可以自行设计新游戏,发展更多的抽象技能。

Socratic Learning 消除了固化结构的局限性,使得 AI 的表现能够远远超出其初始的知识和数据,仅受时间的制约。

向真正自主的 AI 迈进

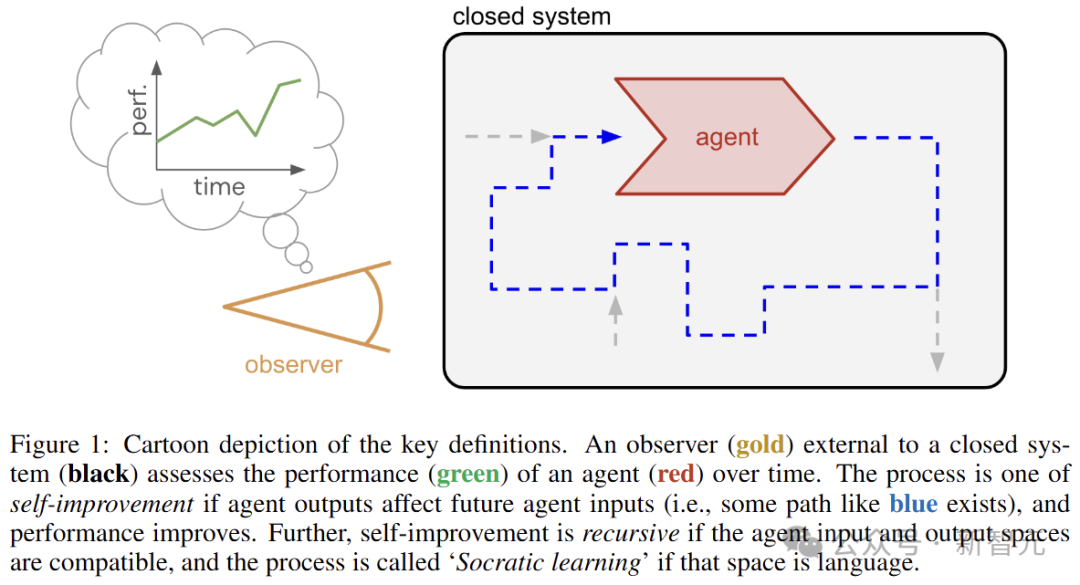

考虑一个随时间演变的封闭系统(无输入、无输出),如图所示。

在该系统中,有一个具备输入与输出的实体(智能体),并且随着时间的推移,它也在变化。系统之外有一个观察者,负责评估智能体的表现。

由于系统是封闭的,观察者的反馈无法传导回系统中。因此,智能体必须依赖内部来源提供学习反馈,例如损失、奖励函数、偏好数据或批评者。

以蓝色虚线所示的路径为例,智能体的输出将影响未来的输入,并提升其性能(自我改进过程),如果输入和输出空间兼容,这种提升便是递归的。

自我提升的一个典型案例是自我博弈,系统让智能体充当游戏的两方,通过生成无限的体验数据并反馈成功来指导学习方向。

反馈在此过程中是关键,AI 的意义是相对于外部观察者而言的,但在封闭系统中,反馈只能来自内部的智能体。

这为系统带来了挑战:保持反馈与观察者反馈的统一,并在整个过程中保持一致。

强化学习中的自我纠正能力在此并不适用,因为可以自我纠正的只是给定反馈的行为,而非反馈本身。

苏格拉底式学习

在递归自我提升方面,相较于输出仅影响输入分布的一般情况,限制性更高,但中介作用较少,通常将智能体的输出映射到输入的环境实例。

这种类型的递归是许多开放流程的一种特性,而开放式的改进恰是 ASI 的核心特征。

输入和输出空间兼容的一个例子就是语言。人类许多行为都是通过语言介导的,尤其是在认知方面。

语言的一个显著特征是其可扩展性,即在现有语言中可以发展出新的语言形式,例如自然语言中的形式逻辑或编程语言。

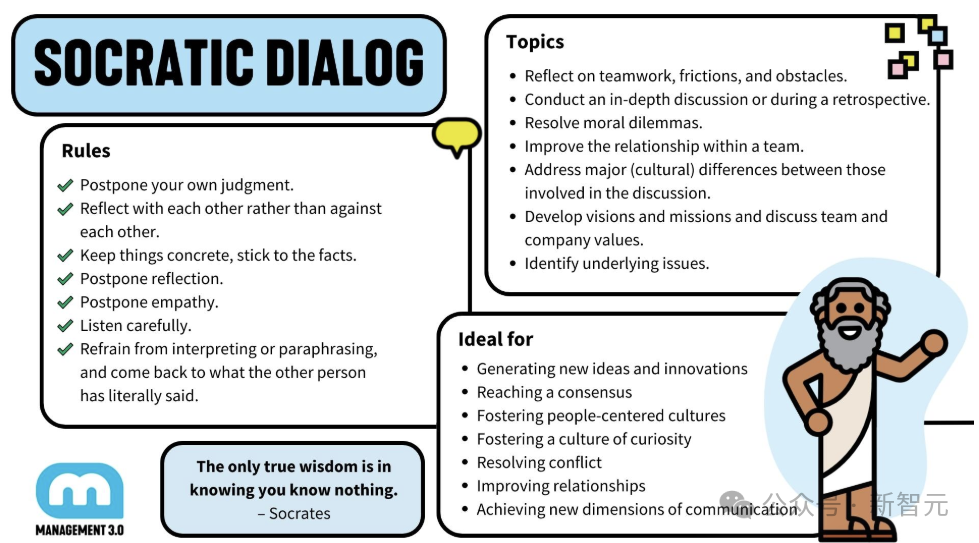

综上所述,本文选择研究智能体在语言空间中的递归自我提升过程。苏格拉底式学习模仿了苏格拉底通过提问、对话及重复的语言互动寻找或提炼知识的方式。

苏格拉底并未去外界收集现实观察,这与本研究强调的封闭系统相适应。

局限性

在自我提升的三个必要条件中,覆盖范围和反馈原则上适用于苏格拉底式学习,并且是不可简化的。

从长远来看,如果计算和内存的能力实现指数级增长,那么规模限制只是暂时的。但另一方面,即便在资源受限的情况下,苏格拉底式学习也可能产生有效的高级洞见。

覆盖范围意味着苏格拉底式学习系统必须持续生成数据(语言),并且随时间保持或扩大多样性。

对于大型语言模型(LLM)来说,生成数据并不难,关键在于在递归过程中防止漂移、崩溃或生成的分布过于狭窄。

反馈要求系统持续生成关于智能体输出的反馈,这在结构上需有一个能够评估语言的批评者,并与观察者的评估标准保持一致。

然而,在语言空间中明确指标通常仅限于特定任务,而 AI 反馈需要更加通用的机制,特别是在输入分布发生变化时。

当前的 LLM 训练模式并不具备足够的反馈机制以支持苏格拉底式学习。例如,预测下一个标记的损失与下游使用不一致,无法推断训练数据之外的情况。

按定义,人类偏好是一致的,但不能在封闭系统的学习过程中使用。将人类偏好存入学习的奖励模型中在短期内或许可行,但长期来看可能导致偏差,并且在分布外数据上的表现也不佳。

换句话说,纯粹的苏格拉底式学习是可行的,但需要通过强大且一致的批评者生成广泛的数据。当这些条件满足后,这种方法的上限仅取决于可供的计算资源。

语言游戏是你所需要的一切

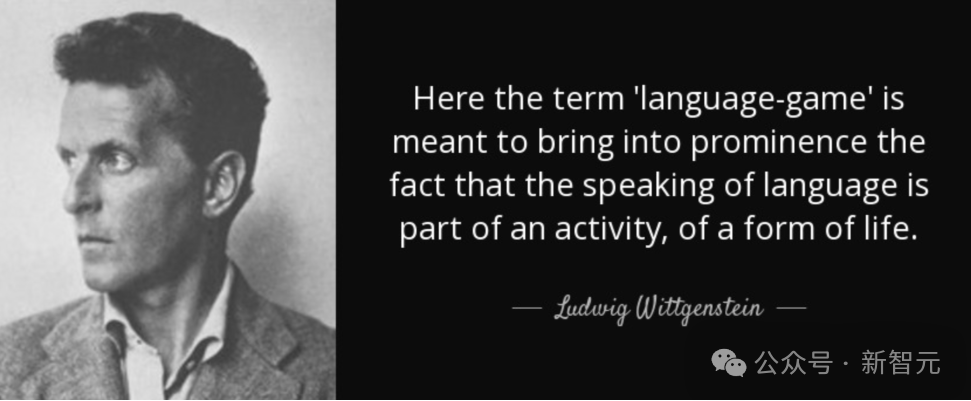

语言、学习和基础是经过深入研究的话题。其中一个特别有用的概念是哲学家维特根斯坦提出的「语言游戏」。

对他而言,捕捉意义的并非文字,而是语言互动的本质。

具体来说,语言游戏被定义为交互协议(一组可用代码表达的规则),指定一个或多个智能体(玩家)之间的互动,这些智能体具有语言输入和输出功能,并在游戏结束时每个玩家都有一个标量评分函数。

通过这种方式定义的语言游戏满足了苏格拉底式学习的两个主要需求:提供了一种可扩展的机制,用于生成无限的交互数据,同时自动提供反馈信号(分数)。

从实用角度看,游戏也是极好的入门途径,因为人类在创造和强化大量游戏和玩家技能方面有着丰富的经验。

实际上,许多常见的 LLM 交互方式也可被良好地表示为语言游戏,例如辩论、角色扮演、心智理论、谈判、逃脱防御,或来自人类反馈的强化学习,后者则是在封闭系统以外的场景中。

维特根斯坦曾坚决表态,他反对语言的单一性质或功能。

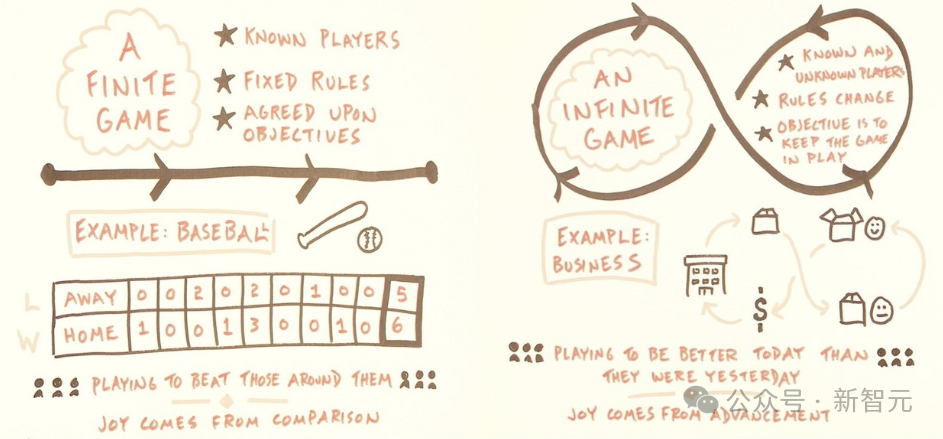

相较于单一通用的语言游戏,采用多种狭义但定义明确的语言游戏的优势在于:对于每一种狭义游戏,都可以设计一个可靠的评分函数(或评论者),这对通用游戏而言是非常困难的。

从这个角度来看,苏格拉底式学习的全过程就像是一个元游戏,在其中安排智能体进行游戏与学习(一个「无限」的游戏)。

苏格拉底因「影响青年思想」而被判死刑并执行。这也意味着,苏格拉底的方法并不能确保与外部观察者的意图保持一致。

语言游戏作为一种机制并未回避这一点,然而,它所需的并非在单个输入和输出的细致对齐的批评者,而是一个能够判断哪些游戏应该被玩耍的「元批评者」:根据对整体性能的贡献来筛选游戏。

此外,游戏的有用性不需要事先评估,能够在经过一段时间的游戏之后进行事后判断,毕竟事后发现异常往往比事前阻止要来得更容易。

那么问题来了,假如从苏格拉底及其门徒开始,数千年来一直无干扰地进行思考与改进,那目前我们的文化、知识和智慧将会达到什么样的高度呢?