DeepSeek-VL2 AI 视觉模型开源:支持动态分辨率、处理科研图表、解析各种梗图等

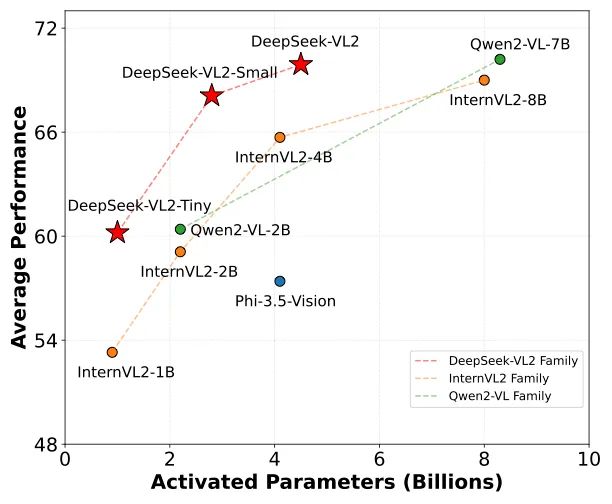

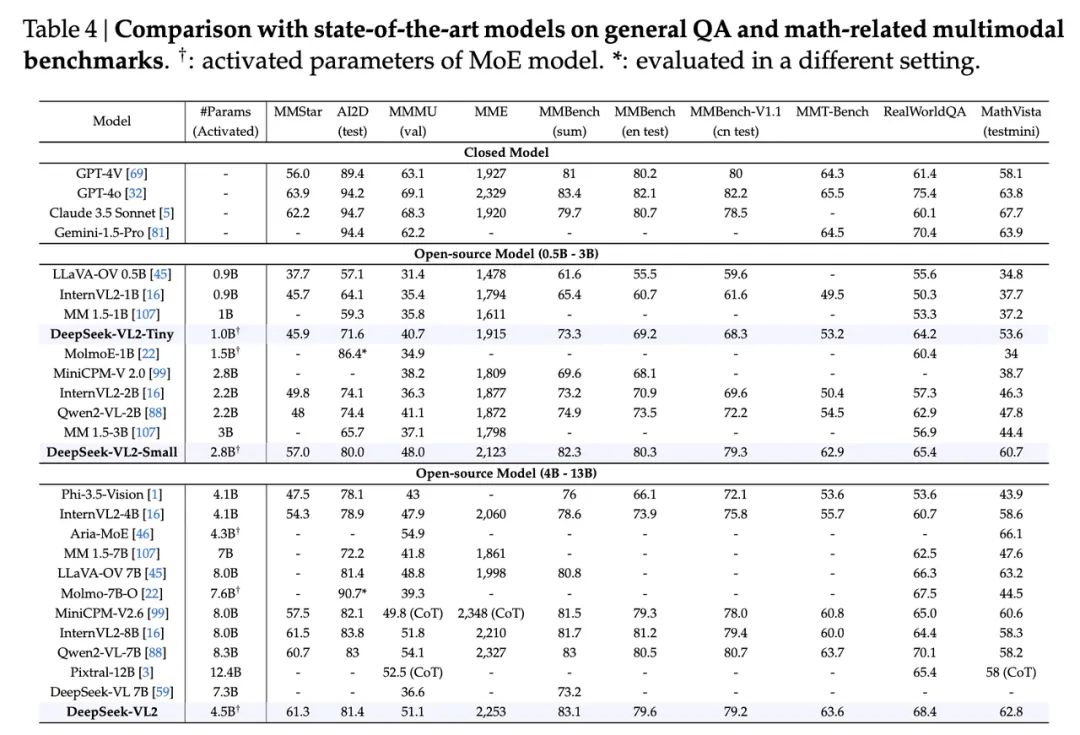

GoodNav 于12月14日消息,DeepSeek 官方公众号在昨日(12月13日)发布了一篇博文,宣布开源 DeepSeek-VL2 模型。在各项评估标准中,该模型展现出极为优异的性能,官方表示其视觉模型正式进入了混合专家模型(Mixture of Experts,简称 MoE)的新时代。

根据官方新闻稿,DeepSeek-VL2 的亮点总结如下:

-

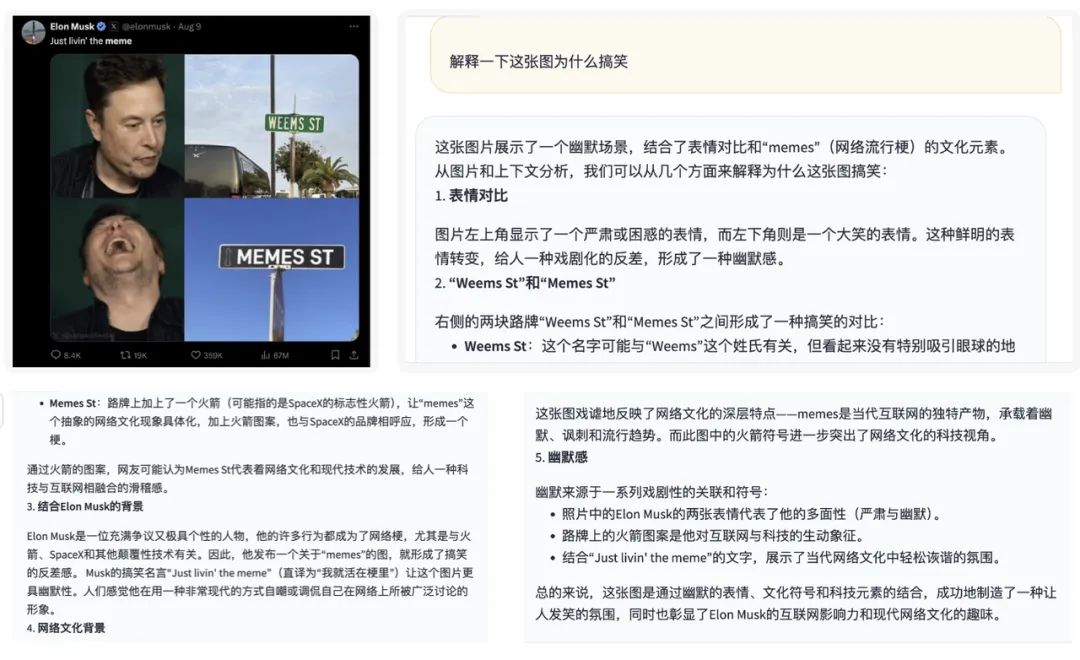

数据:相比 DeepSeek-VL,新增一倍的优质训练数据,增添了对梗图理解、视觉定位和视觉故事生成等新功能。

-

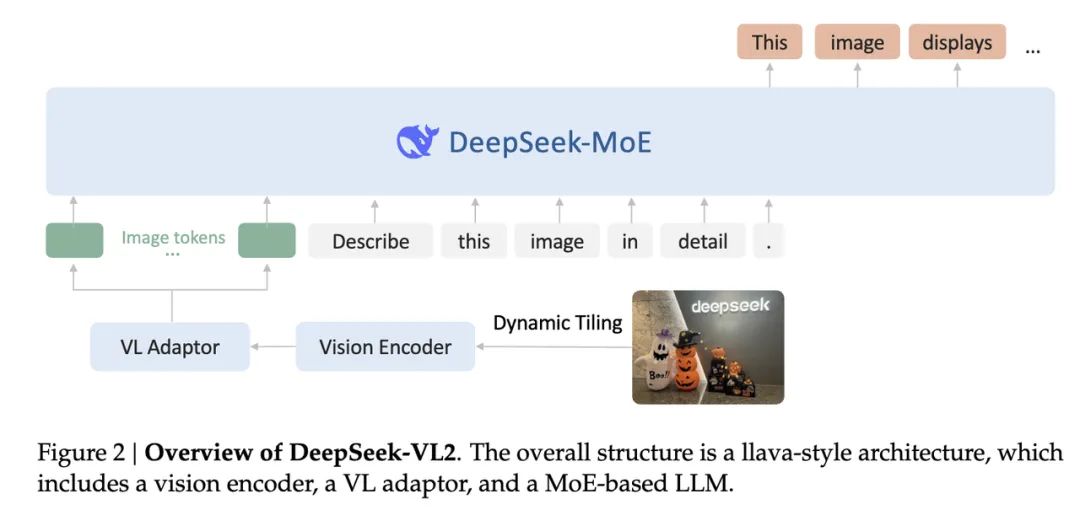

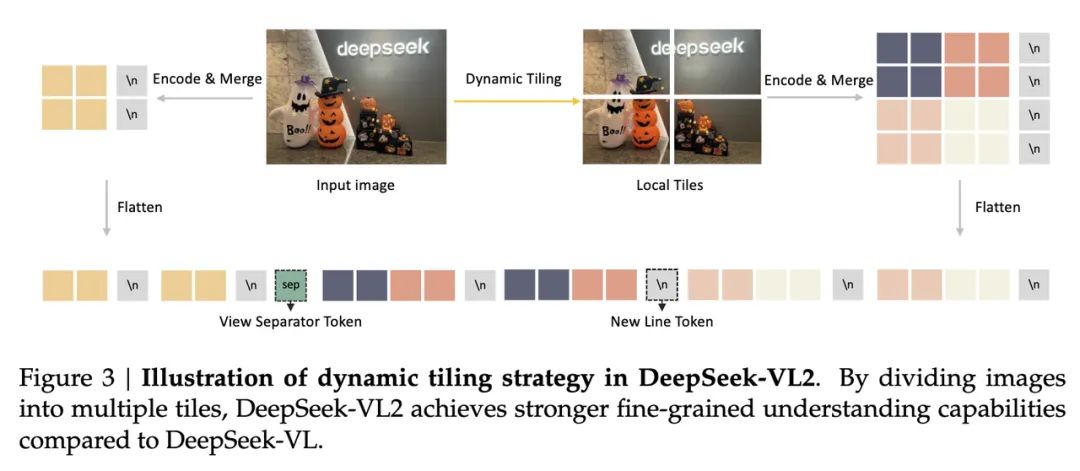

架构:视觉部分采用切图策略以支持动态分辨率图像,语言部分则使用 MoE 架构,具备低成本和高性能的特点。

-

训练:延续 DeepSeek-VL 的三阶段训练流程,同时通过负载均衡来适应图像切片数量的不确定性,并对图像和文本数据采用不同的流水并行策略,引入 MoE 语言模型的专家并行,实现高效训练。

DeepSeek-VL2 模型支持动态分辨率,仅需使用一个 SigLIP-SO400M 作为图像编码器,通过将图像切分为多个子图和一张全局缩略图来实现这个功能。这种方法使得 DeepSeek-VL2 可支持高达 1152×1152 的分辨率以及 1:9 或 9:1 的极端长宽比,适应更多的应用场景。

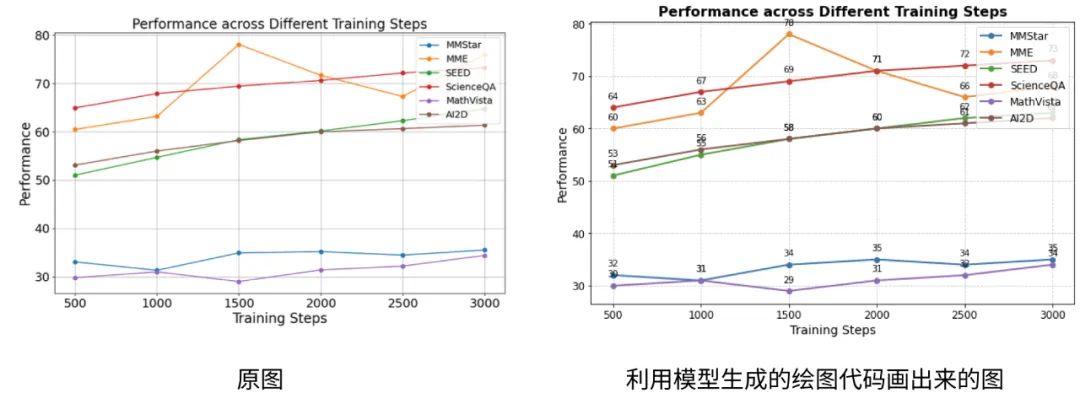

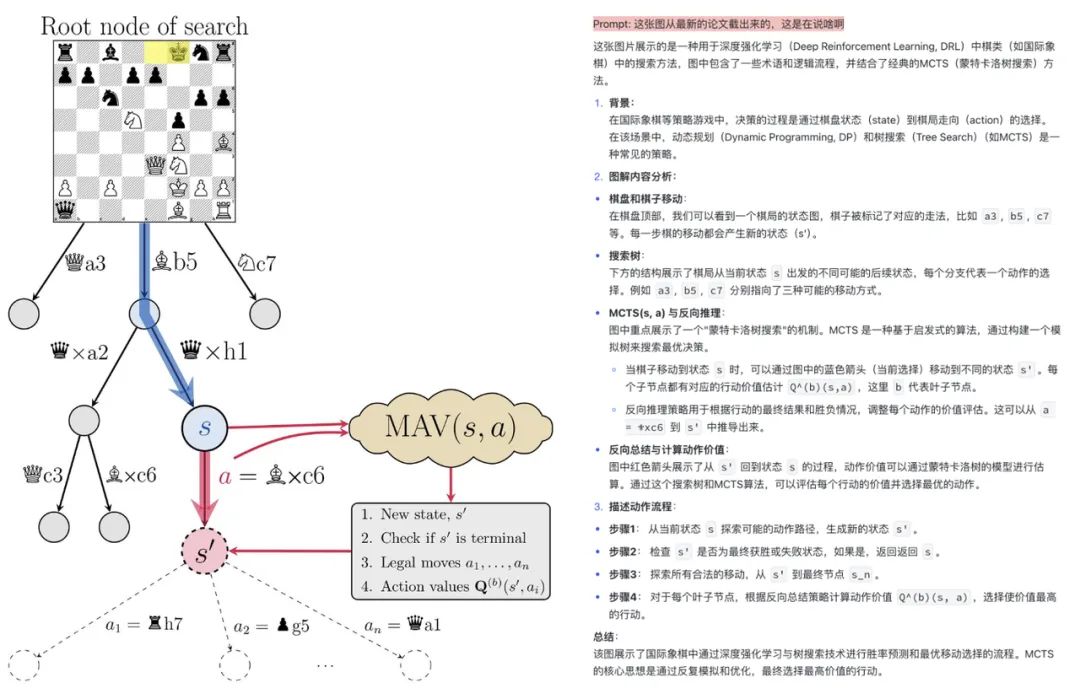

此外,DeepSeek-VL2 模型还因学习了更多的科研文档数据,能够轻松理解各种科研图表,并通过 Plot2Code 将图像转化为 Python 代码。

模型及其论文已经发布:

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...