字节跳动 X- Portrait2 技术尝鲜:我感觉动捕要升级到 next level 了

如果你平时喜欢玩游戏或者观看 3D 动画片,那么“动作捕捉”这个术语一定不陌生。

无论是游戏中的人物还是动画片中的角色,他们能够展现出各种生动的表情,这背后离不开动作捕捉技术的支持。

然而,经过多年的应用,动作捕捉技术并非没有缺点,例如其工作流程和所需设备都非常复杂,以大约 200 分钟的动画制作而言,从演员表演到最终成片往往需要超过一个月的时间。此外,动作捕捉设备的价格也相当高昂,动辄就要数十万美元。

除了动作捕捉,对于动画中的表情控制,传统动画师只能通过手动的方式来完成,这当然更加耗时和费力。

那么,除了上述这两种方式,还有没有更高效、更低成本的方法来实现表情和动作的捕捉与控制呢?

在当今智能化的时代,提到这个问题,AI 是绕不开的一个关键词。

最近,字节跳动智能创作团队提出了一种 X- Portrait2 单图视频驱动技术,这为我们带来了新的可能性。

X- Portrait2 单图视频驱动技术只需提供一张静态照片和一段驱动视频,便能生成高质量、电影级别的视频。

该模型不仅能够保留原始图像的身份信息,还能准确捕捉和生动迁移细微到夸张的表情和情感,呈现出高度真实的效果。这无疑为创作具有表现力和逼真的角色动画及视频片段提供了一种成本极低且高效的方法。

听起来不错,但它的实际表现如何呢?GoodNav最近获得了内部测试的机会,我们可以先通过 X- Portrait2 生成的视频表现来了解一下。

X- Portrait2 实测:看到这逼真的效果,我有些震惊……

在实际使用中,我们只需向模型提供一段人物表情清晰的视频,并配上一张静态人物照片,X- Portrait2 就可以让照片中的人物展现出与视频中的人物相同的表情和动作。

例如,我想到经典影视片段中乌蝇哥的名场景,然后让《黑神话:悟空》里的天命人来重现乌蝇哥的表情(视频测试素材仅供技术演示):

在 X- Portrait2 技术下,天命人模仿乌蝇哥的表情整体显得相当自然,与原视频也较为相似。此外,我们可以看到图中的天命人与视频中的乌蝇哥在头部视角上有所不同,但这并未影响 X- Portrait2 对表情的还原。

接着,我设想让《生化危机 4:重制版》中的里昂和艾什莉演绎电视剧《回家的诱惑》的经典场景,X- Portrait2 同样生成了对应的视频,小编将结果专门制作为 gif 供大家参考:

X-Portrait 2 在经过大规模高质量表情视频的训练后,显著在运动表现力和身份保持性方面优于前代技术。算法能够从驱动视频中提取不同粒度的表情特征(如挑眉、咬唇、吐舌、皱眉),并有效地迁移到扩散模型,实现精准的表情动作控制,进而实现驱动视频中人物情感的高保真迁移。

在训练表情编码器时,为了使编码器关注与表情相关的信息,X-Portrait 2 成功地实现了外观和运动的解耦。

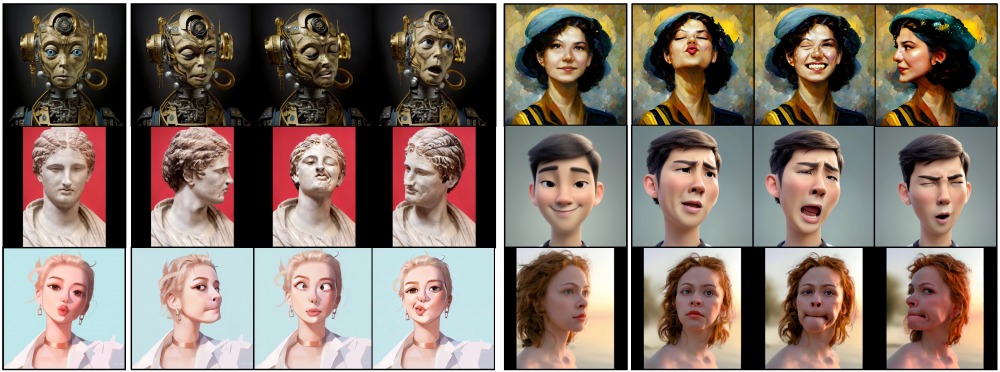

具体而言,通过设计过滤层,编码器可以有效过滤运动表征中的身份相关信号,使得即使身份图像与驱动视频中的形象和风格差异较大,模型仍可以实现跨身份、跨风格的动作迁移,涵盖写实与卡通图像。这使得 X-Portrait 2 能够高度适应各种应用场景,包括现实世界的叙事创作、角色动画、虚拟形象以及视觉特效等。

因此,即使在之前的测试中,驱动视频是真人影视剧片段,而身份图像是 3D 游戏角色,X-Portrait 2 仍然表现出色,能很好地控制面部表情和动作。

例如,以下几个示例中,驱动视频是现实人物,而身份图像则为现实照片、卡通漫画,甚至是油画作品,X-Portrait 2 依然输出了非常真实的结果。

看到 X-Portrait 2 的表现,可能有些朋友会想到近期谷歌等公司支持的人工智能初创公司 Runway 推出的“Act-One”功能,它集成在 Runway 的视频生成模型 Gen-3 Alpha 中,该功能同样可以让用户轻松录制自己或他人的视频,并利用 Act-One 将录制对象的面部表情转移到 AI 生成的角色上。

相较于 Runway Act-One 等先进方法,X-Portrait 2 在快速头部动作、细微表情变化以及强烈个人情感的表现上更为出色,这些方面对高质量内容创作(如动画和电影制作)至关重要。

例如在下面的效果对比中,X-Portrait 2 对人物面部表情的呈现明显更加丰富与生动,而 Runway Act-One 生成的人物面部细节明显缺失,看上去表情相对生硬,缺乏冲击力。

在下面的案例中,驱动视频中的人物动作幅度较大,表情也相对夸张,X-Portrait 2 很好地还原了原视频的特点,而 X-Portrait 在细节上略有缺失,头部运动的过程中表现得稍显跳脱,但整体表现还是不错。相比之下,Runway Act-One 则因驱动视频中的头部运动幅度过大而无法生成。

由此可见,字节跳动的 X-Portrait 2 单图视频驱动技术确实出色,包含了许多创新点,且在动态目标捕捉能力、生成结果的逼真度和协调性等方面,相较于当前行业内其他类似的 AIGC 模型和方案都具有明显的优势。

结语

在体验并深入了解字节跳动的 X- Portrait2 单图视频驱动技术后,不禁感叹 AIGC 技术的快速进步和字节跳动在 AI 模型创新方面的强大技术实力。

同时也要提醒大家,上述体验仅是 X-Portrait 2 内部测试的版本,随着未来技术的不断成熟和完善,其应用前景无疑将非常广阔。

例如,创作者们可以利用它大大加快创作过程,曾经需要耗费大量人力物力的动作捕捉设备,或许将不再必要,只需拍摄一段视频加上一张照片就能完成表情和动作的采集,这样的效率提升简直难以想象。

此外,这项技术未来也可能应用于数字人、XR 等领域,使我们的数字分身或各种 AI 智能体更真实,能够通过面部表情传递情感,与我们展开更加自然的交流,进一步打破虚拟与现实的界限……

可以说,生成式 AI 每一次进步都是生产效率的大幅提升,更是对我们当前工作、生活和娱乐方式的变革。

而字节跳动正在通过不断创新的技术和解决方案,让这样的理想一步一步变为现实。

生成式 AI 的未来,确实充满无限可能。