腾讯推出 Hunyuan-Large 大模型:389B 总参数,业界已开源基于 Transformer 的最大 MoE 模型

GoodNav 11 月 5 日报道,腾讯今日发布了 Hunyuan-Large 大模型,声明这是当前业界已开源的最大Transformer基础的MoE模型,其总参数达 3890 亿(389B),激活参数为 520 亿(52B)。

今天,腾讯在 Hugging Face 上开源了 Hunyuan-A52B-Pretrain、Hunyuan-A52B-Instruct 和 Hunyuan-A52B-Instruct-FP8,并发布了技术报告与训练推理手册,详细说明了模型的能力以及训练与推理的相关操作。

该模型的技术优势包括:

-

高质量合成数据:借助合成数据增强训练,Hunyuan-Large 能够获得更丰富的表征,处理长上下文输入,并更有效地泛化到未见数据。

-

KV缓存压缩:采用分组查询注意力(GQA)和跨层注意力(CLA)策略,显著降低了KV缓存的内存占用和计算成本,提升推理吞吐量。

-

专家特定学习率调整:为不同的专家设置不同的学习率,确保每个子模型能够有效学习数据,并对整体性能作出贡献。

-

长上下文处理能力:预训练模型支持最多 256K 的文本序列,Instruct 模型支持 128K 的文本序列,显著增强了长上下文任务的处理能力。

-

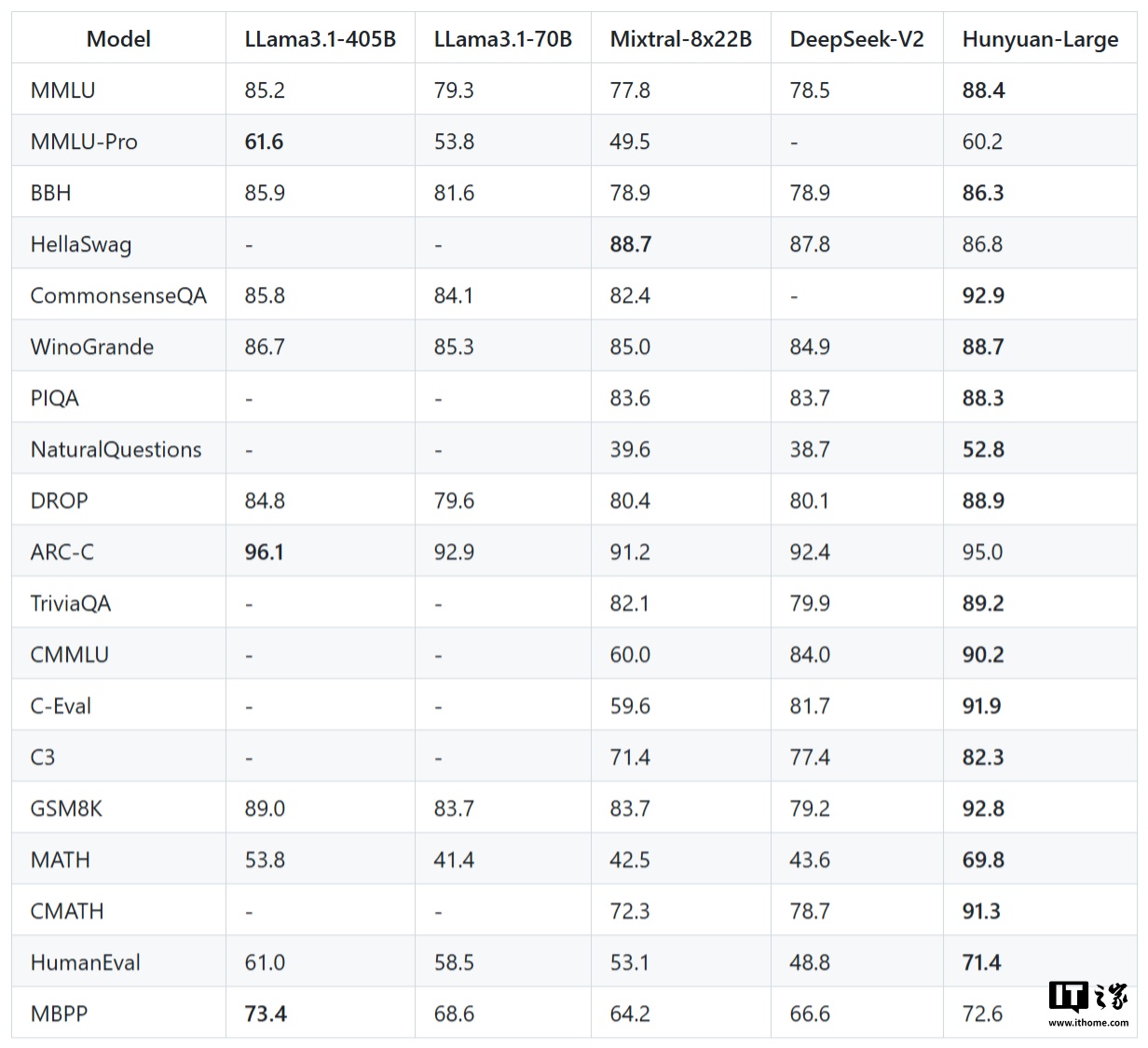

全面的基准测试:在多种语言和任务上进行了广泛的实验,验证了 Hunyuan-Large 的实际应用效果和安全性。

以下是相关链接:

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...