AI 让手机任务自动“跑”起来!我国高校最新研究,简化移动设备操作

AI 解放了碳基生物的双手,甚至可以让你的手机自主运行!

你没有听错 —— 这就是移动任务的自动化。

在 AI 迅猛发展的背景下,移动任务自动化逐渐演变为一个备受关注的新兴研究领域。

移动任务自动化通过 AI 精确理解并解析人类意图,进而在移动设备(如手机、平板电脑和车载设备)上高效地完成多样化的任务,为那些因为认知局限、身体障碍或特定环境限制的用户提供前所未有的便利与支持。

-

协助视障者进行导航、阅读和线上购物

-

帮助老年人更好地使用手机,弥补数字鸿沟

-

助力司机在行驶时发送短信或调整车内环境

-

为用户完成日常生活中的重复性任务

-

……

妈妈再也不用担心重复设置多个日历事项了。

近日,来自西安交通大学智能网络与网络安全教育部重点实验室 (MOE KLINNS Lab) 的蔡忠闽教授和宋云鹏副教授的团队(主要研究方向包括智能人机交互、混合增强智能和电力系统智能化等),基于其最新 AI 研究成果,创新性地提出了一种视觉基础的移动设备任务自动化方案 VisionTasker。

该研究不仅为普通用户提供了更为智能的移动设备使用体验,也彰显了对特殊需求群体的关怀和赋能。

视觉基础的移动设备任务自动化方案

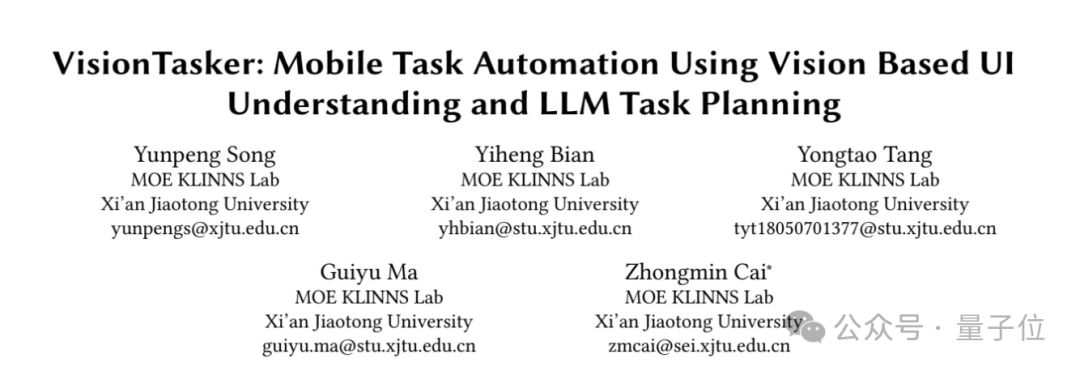

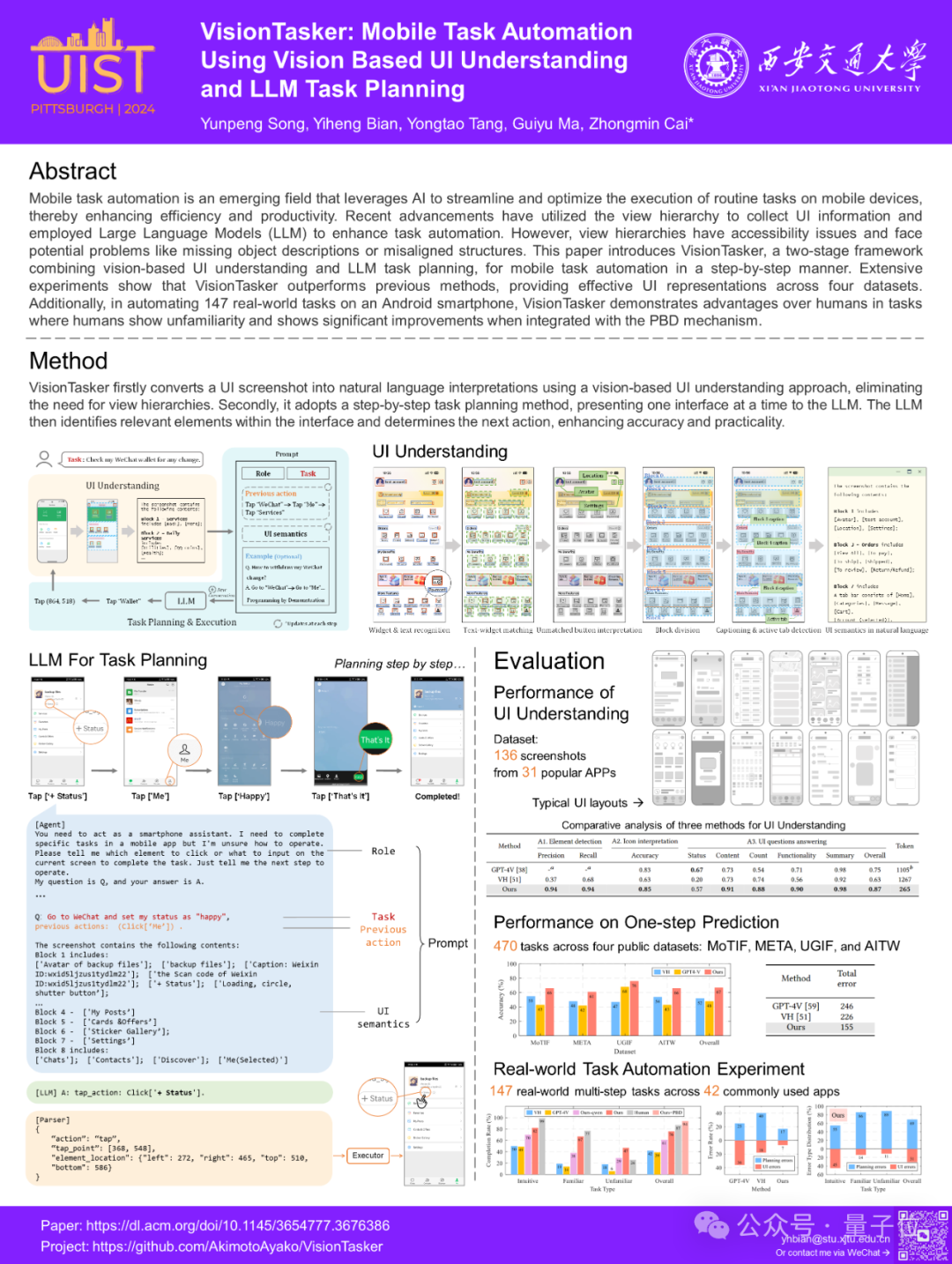

团队提出了VisionTasker,这是一个结合基于视觉的用户界面理解和大语言模型(LLM)任务规划的两阶段框架,旨在逐步实现移动任务自动化。

该方案有效减少了对用户界面视图层级结构的依赖,提升了对不同应用界面的适应性。

值得一提的是,使用 VisionTasker 无需为大模型进行大规模数据训练。

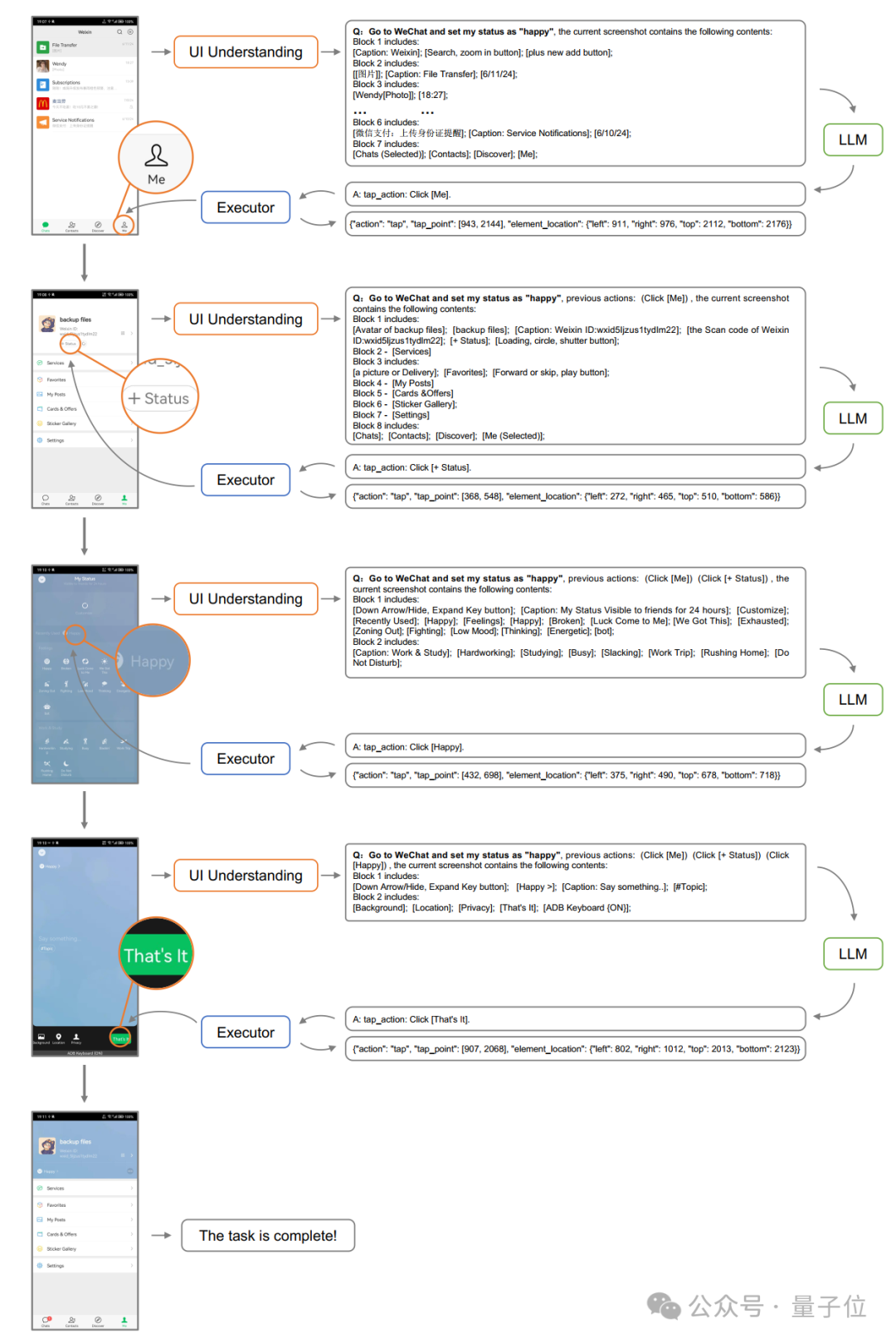

VisionTasker 以用户通过自然语言表达的任务需求为起点,Agent 开始理解并执行指令。

具体实现步骤如下:

1、用户界面理解

VisionTasker 通过视觉手段进行用户界面理解,从而解析和解释用户界面内容。

首先,Agent 识别并分析用户界面中的元素和布局,例如按钮、文本框和文字标签等。

然后,将这些识别到的视觉信息转化为自然语言描述,用以解释界面信息。

2、任务规划与执行

随后,Agent 利用大型语言模型进行导航,根据用户指令和界面描述进行任务规划。

将用户的任务分解为可执行步骤,如点击或滑动操作,以便自动完成任务。

3、过程持续迭代

每完成一步,Agent 根据最新的界面信息和历史操作更新其对话和任务规划,确保每一步的决策基于当前上下文。

这是一个不断迭代的过程,持续进行,直到判断任务完成或到达预设限制。

用户不仅能在交互中解放双手,还可以通过可见提示监控任务进度,随时中断任务,保持对整个流程的控制。

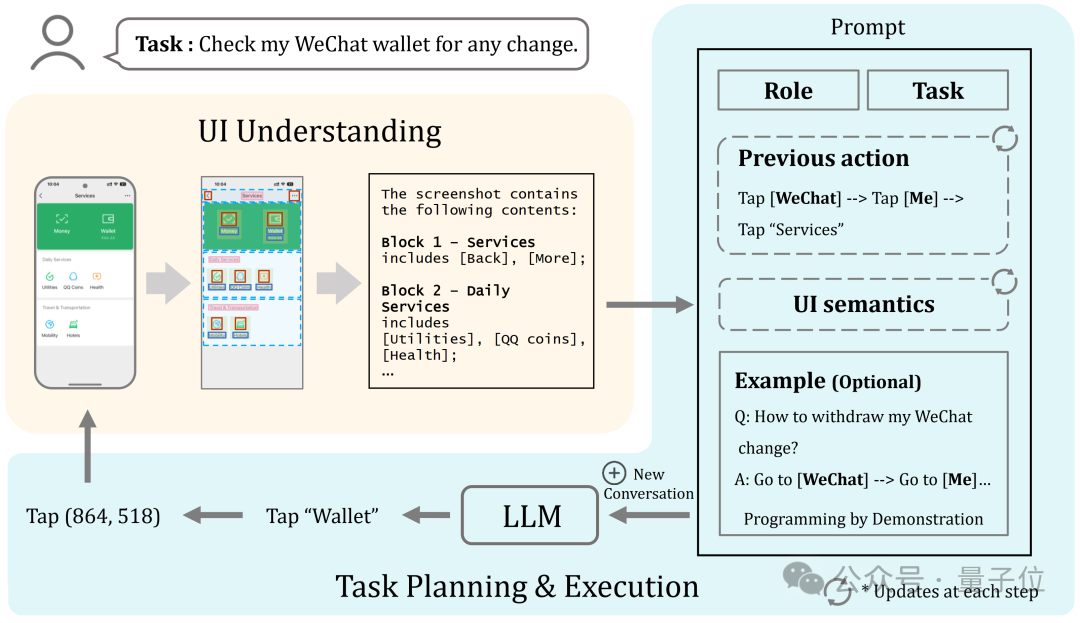

首先是识别界面中的小部件和文本,检测按钮、文本框等元素及其位置。

对于没有文本标签的按钮,使用 CLIP 模型通过视觉设计推测其可能的功能。

之后,系统根据用户界面布局的视觉信息进行划分,将界面分成多个不同功能的区块,并为每个区块生成自然语言描述。

这个过程还包括文本与小部件的匹配,确保能正确理解每个元素的功能。

最终,所有这些信息被转化为自然语言描述,为大型语言模型提供正晰、语义丰富的界面数据,使其能够有效进行任务规划和自动化操作。

实验评估

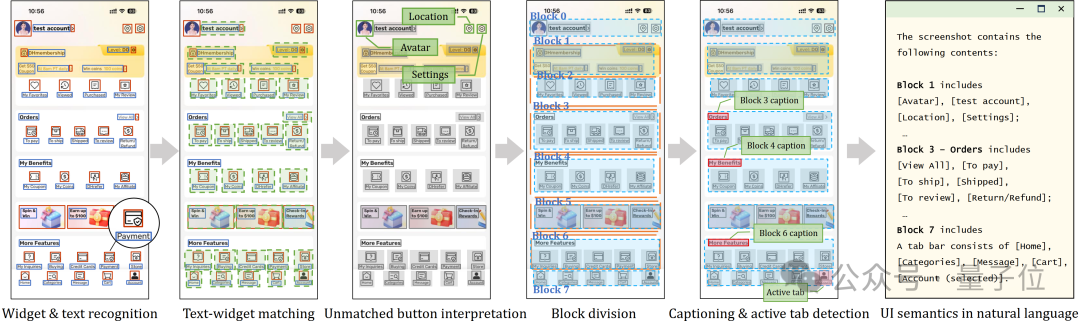

在实验评估部分,该项目提供了对三种用户界面理解方法的比较分析,具体为:

-

GPT-4V

-

VH(视图层级)

-

VisionTasker 方法

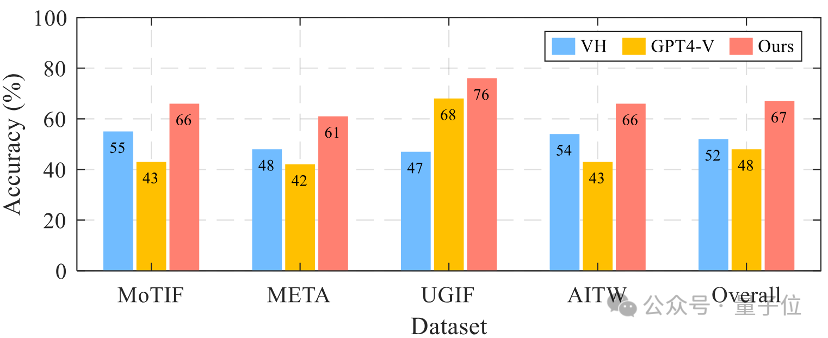

△ 三种用户界面理解方法的比较分析

比较结果显示,VisionTasker 在多个维度上明显优于其他方法。

此外,在跨语言应用的处理上,它也展现了良好的泛化能力。

△ 实验 1 中的常见用户界面布局

显示出 VisionTasker 在用户界面理解与解释方面的显著优势,尤其是在面对多样化和复杂用户界面时更为突出。

△ 跨四个数据集的单步预测准确率

研究还进行了单步预测实验,根据当前的任务状态和用户界面,预测接下来应该执行的动作或操作。

结果表明,VisionTasker 在所有数据集上的平均准确率达到了 67%,比基线方法提高了超过 15%。

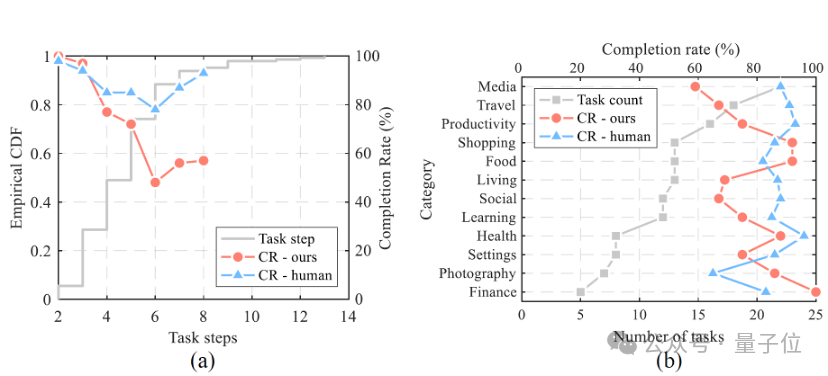

真实世界任务:VisionTasker 与人类比较

在实验中,研究团队设计了 147 个真实的多步骤任务来评估 VisionTasker 的表现,涵盖了国内常用的 42 个应用程序。

同时,团队设置了人类对比测试,由 12 名评估者手动执行这些任务,随后与 VisionTasker 的结果进行比较。

结果显示,VisionTasker 在大部分任务中达到了与人类相当的完成率,并且在某些不熟悉的任务中表现超出人类。

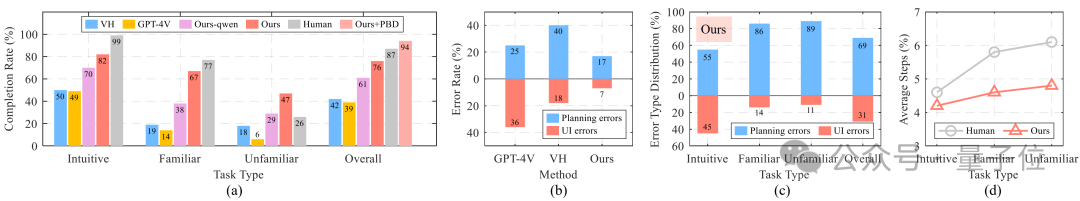

△ 实际任务自动化实验的结果,“Ours-qwen”表示使用开源 Qwen 实现 VisionTasker 框架,而“Ours”则表示使用文心一言作为 LLM

研究团队还评估了 VisionTasker 在不同条件下的表现,包括使用不同的大语言模型(LLM)和编程演示(PBD)机制。

VisionTasker 在大多数直观任务中达到了与人类相当的完成率,在熟悉任务中略低于人类,但在不熟悉任务中表现优于人类。

△ VisionTasker 逐步完成任务的展示

结论

作为一个基于视觉和大型模型的移动任务自动化框架,VisionTasker 解决了现阶段移动任务自动化对视图层级结构的过度依赖。

通过一系列对比实验,证明其在用户界面表现上优于传统的编程演示和视图层级结构方法。

它在四个不同的数据集上展现了卓越的 UI 表示能力,具有更强的应用广度;同时在 Android 手机上执行 147 个真实世界任务时,尤其是在复杂任务的处理上,显示了超越人类的能力。

此外,通过集成编程演示(PBD)机制,VisionTasker 在任务自动化方面的性能有了显著提升。

目前,该研究成果已正式发表在将于 2024 年 10 月 13-16 日于美国匹兹堡举行的人机交互顶级会议 UIST(The ACM Symposium on User Interface Software and Technology)上。

UIST 是人机交互领域专注于人机界面软件与技术创新的 CCF A 类顶级学术会议。

-

原文链接:https://dl.acm.org/ doi / 10.1145/3654777.3676386

-

项目链接:https://github.com/ AkimotoAyako / VisionTasker

本文来自微信公众号:量子位(ID:QbitAI),作者:关注前沿科技