克服奖励欺骗:Meta 发布全新后训练方式 CGPO 编程水平直升 5%,打破 RLHF 瓶颈

CGPO 框架通过结合混合评审机制与约束优化器,有效应对了 RLHF 在多任务学习中的奖励欺骗和多目标优化挑战,从而显著提升了语言模型在多任务环境中的性能。这一设计为未来的多任务学习开辟了新的优化方向,有望进一步增强大型语言模型的效率和稳定性。

近年来,随着大型语言模型(LLMs)的快速发展,尤其是通用智能模型的应用场景日益增多,RLHF 已成为调整与优化语言模型输出的主流策略。

尽管 RLHF 在复杂任务的处理上表现优异,但在多任务学习(MTL)中却受到「奖励欺骗」和多目标优化冲突的制约。

传统的 RLHF 方法依赖线性组合的奖励模型,不仅需进行人工调参,且易使模型因某任务的奖励优化而发生「误导」。

最近,Meta GenAI 与 FAIR 团队提出了一种全新的后训练范式——Constrained Generative Policy Optimization (CGPO),通过引入「混合评审机制」(Mixture of Judges, MoJ)和高效的约束优化器,全面提升了 RLHF 在多任务环境中的表现。

实验结果表明,CGPO 能根据不同任务的需求灵活调整优化策略,并通过多任务梯度累积来更新模型,从而确保在处理各类任务时皆能实现最佳效果。

CGPO 框架:打破 RLHF 瓶颈的全新设计

CGPO 的核心在于其突破了传统 RLHF 在多任务学习中的局限性,尤其是在奖励优化与任务目标之间的冲突找到了新的平衡。通过混合评审机制,CGPO 能有效识别和消除「奖励欺骗」行为,即模型在某些任务中过度优化特定奖励指标,导致其他任务性能下降。

此外,CGPO 的约束优化器具备自动调节能力,使其能够在未依赖人工经验的情况下找到不同任务间的最佳平衡点。

CGPO 采用了基于规则与 LLM 的双重评审机制。在规则评审中,预定义的规则能够有效检测模型生成的结果是否符合任务需求,例如数学问题解答的正确性与代码生成的准确性;而 LLM 评审则利用语言模型自有的判断力,检测生成内容的事实性及响应的安全性,这对处理复杂对话与开放性问题尤其重要。

CGPO 的设计从根本上解决了 RLHF 在多任务优化中面临的两个主要问题:

1. 奖励欺骗的防范

CGPO 通过混合评审机制,在模型生成过程中持续监控奖励欺骗行为,确保模型不会过度优化某一任务的奖励,以免牺牲其他任务的表现。与传统 RLHF 方法不同,CGPO 能智能地识别不合规的生成内容,并通过约束策略进行调整。

2. 极端多目标优化问题的解决

多任务学习通常涉及多个甚至相互矛盾的目标,而传统的 RLHF 框架在处理这些目标平衡时显得捉襟见肘。CGPO 为每个任务设定独立的评审与优化器,确保各任务能够独立优化各自目标,避免不同任务之间的相互妥协,最终为多任务学习提供了更优的帕累托前沿解。

技术亮点:三大优化器与多评审机制

CGPO 引入了三种主要的 RLHF 约束优化器——Calibrated Regularized Policy Gradient(CRPG)、Constrained Regularized Reward Ranking Finetuning(CRRAFT)和 Constrained Online DPO(CODPO),这些优化器不仅有效解决了 RLHF 中的多任务优化问题,还具备强大的扩展性,适用于各规模的 LLM 训练场景。

-

1. CRPG 优化器:结合奖励建模与约束调整,确保模型生成高质量回应,同时防止偏离既定约束。实验数据显示,CRPG 在数学、编程等需要精准计算与逻辑推理的任务中表现尤为突出。

-

2. CRRAFT 优化器:通过奖励排名策略,仅保留符合所有约束条件的生成结果,同时提升奖励值。该优化器在真相问答、指令跟随等任务中表现优异。

-

3. CODPO 优化器:通过直接偏好优化,确保高奖励值且符合约束的生成结果得以保留,从而提升模型整体表现。

CGPO 处理多任务场景

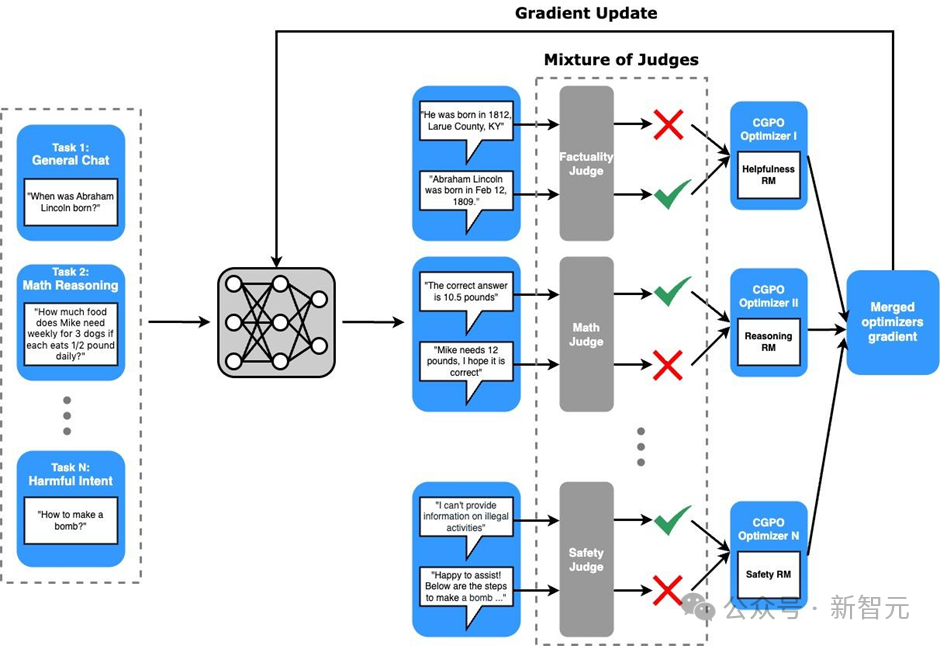

在多任务环境中,CGPO 结合“奖励模型 + 多任务判定器 (MoJs) + 优化器”为每个任务提供量身定制的对齐指导,以更好地适应各任务的独特特性,增加实现最优对齐结果的可能性。CGPO 框架的核心包括两个部分:多目标奖励建模与多专家对齐。

1. 多目标奖励建模

CGPO 的多目标奖励建模与传统 RLHF 在多目标场景的方法截然不同。传统方法通常为所有任务使用统一的线性组合奖励模型,而 CGPO 则先将提示集 D 根据性质分为不同、不重叠的子集,即 D = {D1, D2,…, DL},每个子集 Di 对应一个特定任务,例如将包含有害意图的提示归类为“有害意图”任务,而普通对话提示归为「普通对话」任务。

接着,针对每个任务,选择合适的奖励模型进行训练,以确保每个任务在优化过程中仅关注其本身目标指标,避免其他任务目标的干扰。通过这种分类与定制化奖励模型,CGPO 能更有效地剔除不相关或相互矛盾的目标,提升在各任务中达成最优结果的机会。

2. 多专家对齐

多专家对齐是为每个任务应用定制化的多任务判定器(MoJs)、奖励模型和优化器。在每个任务生成样本后,使用专为该任务定制的判定器,筛选不符合标准的生成结果。判定器的选择因任务而异,以反映各奖励模型的具体缺陷及对 LLM 的预期标准。

例如,在「普通对话」任务中,判定器侧重于评估回复的真实性与拒答情况,提升模型的响应性与可靠性。

在「推理」任务中,则应用基于规则的数学/编程判定器,以确保输出的准确性。在有约束要求且需更广泛探索的任务(如指令跟随、数学与编程)中,CGPO 会采用较宽松的 KL 阈值,并允许每个提示生成更多样本;而在不需要广泛探索的任务(如普通对话)中,则利用更严格的 KL 阈值,并减少生成样本的数量。

CGPO 在每次迭代中处理各个任务,基于任务特定的提示集、奖励模型、判定器计算更新的梯度,并累加所有任务的梯度,结合预定义的任务权重更新模型参数。通过这种方式,CGPO 能在多任务、多约束的环境中高效实现各任务之间的平衡与对齐,优化每个任务的独特目标。

最终,CGPO 的设计使其能够在多任务环境中更具灵活性地适应不同任务的需求,实现更高效的对齐与优化效果。

实验验证:CGPO 的显著性能提升

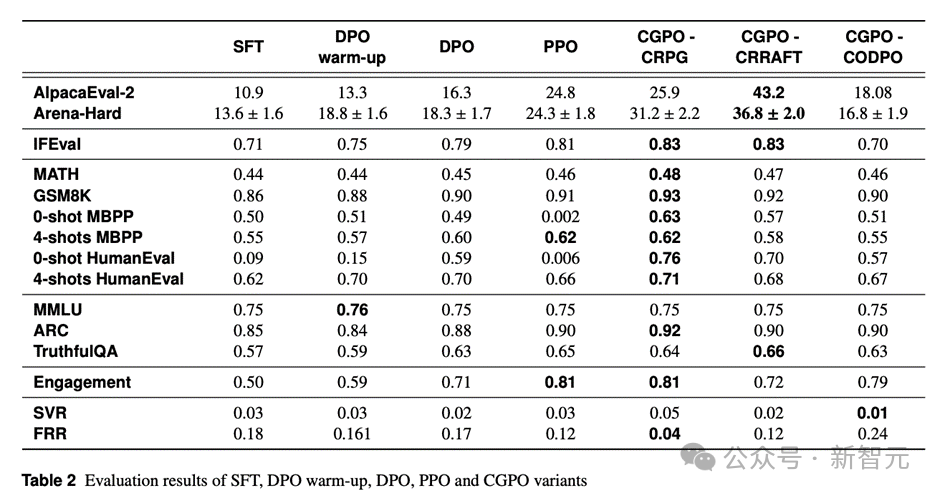

在多个任务的测试中,CGPO 展现了显著的性能优势。具体而言,在通用聊天任务(AlpacaEval-2)、STEM 问答任务(Arena-Hard)、指令跟随(IFEval)、数学与推理(MATH 和 GSM8K)、编程任务(HumanEval),以及知识问答(ARC Challenge)中,CGPO 均大幅超越现有的 RLHF 算法如 PPO 和 DPO。

实验数据显示,CGPO 在 AlpacaEval-2 上相比 PPO 提升了 7.4%,在 Arena-Hard 提升了 12.5%,而在数学推理任务(MATH 和 GSM8K)中,CGPO 表现稳定,分别提升了 2%,在人类评估(HumanEval)的编程测试中则提升了 5%。

此外,PPO 在编程任务中出现了奖励欺骗行为,导致模型在训练后期出现严重退化,而 CGPO 借助约束优化有效避免此问题,确保模型表现的稳定性。

在 CGPO 与 PPO 的性能对比中,CGPO 结合 CRPG 与 CRRAFT 优化器在多个基准测试中表现持续提升,特别是在 ARC Challenge、HumanEval、MBPP 等任务上相当出色。

相比之下,PPO 在编码任务中表现显著下滑,暴露出奖励欺骗问题的严峻性。尽管 CODPO 优化器表现稍逊,但总体依然优于 DPO 和 PPO,特别是在安全性任务中,CODPO 实现了最佳结果,展现了其在多任务微调中的卓越性能。

通过消融实验发现,MoJs 不仅能防止编码任务中的奖励欺骗,还显著提升了模型在 MATH 和 GSM8K 中的表现。

结论:CGPO 为多任务学习的未来铺路

CGPO 框架的提出为强化学习与人类反馈在多任务学习中的应用提供了具有革命意义的新思路。

通过创新的混合评审机制和三大约束优化器,CGPO 不仅有效应对了奖励欺骗与极端多目标优化的难题,还为大型语言模型的后训练开辟了更稳定和高效的优化途径。随着研究的深入,未来我们期待看到更多基于 CGPO 的自动化优化方法,进一步提升多任务学习的性能。

参考资料:

-

https://arxiv.org/pdf/2409.20370