微软开源 OmniParser 纯视觉 GUI 智能体:让 GPT-4V 秒懂屏幕截图,可操控手机 / 电脑

GoodNav 10 月 29 日消息,科技媒体 marktechpost 于 10 月 24 日发布了一篇博文,报道微软宣布开源 OmniParser,这是一款能够解析和识别屏幕上可交互图标的 AI 工具。

项目背景

以往的自动化方法通常依赖于解析 HTML 或视图层级,这限制了它们在非网络环境中的应用。

然而,现有的视觉语言模型(VLMs),比如 GPT-4V,对复杂图形用户界面(GUI)元素的解读不够精确,导致动作定位存在误差。

项目简介

为了解决这些问题,微软推出了 OmniParser,这是一款基于视觉的工具,旨在填补当前屏幕解析技术的空白。

该工具不依赖额外的上下文数据,能够理解更复杂的图形用户界面(GUI),这是智能 GUI 自动化领域的一项重要进展。

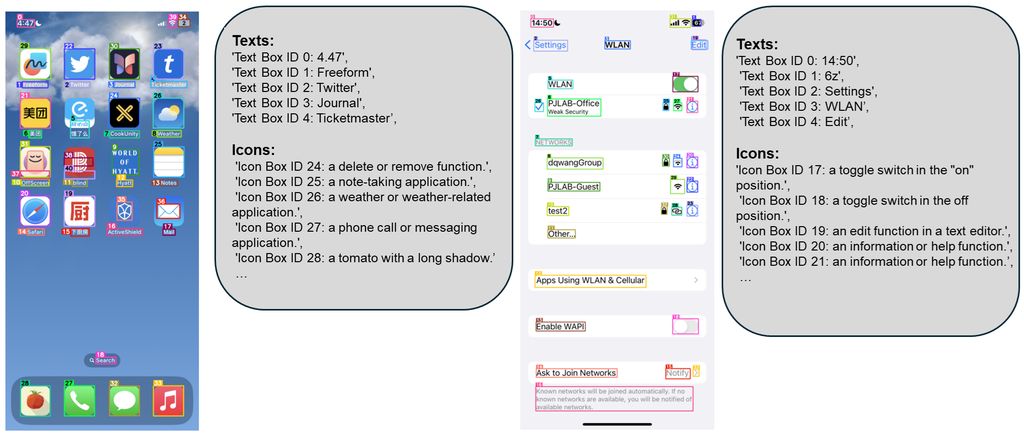

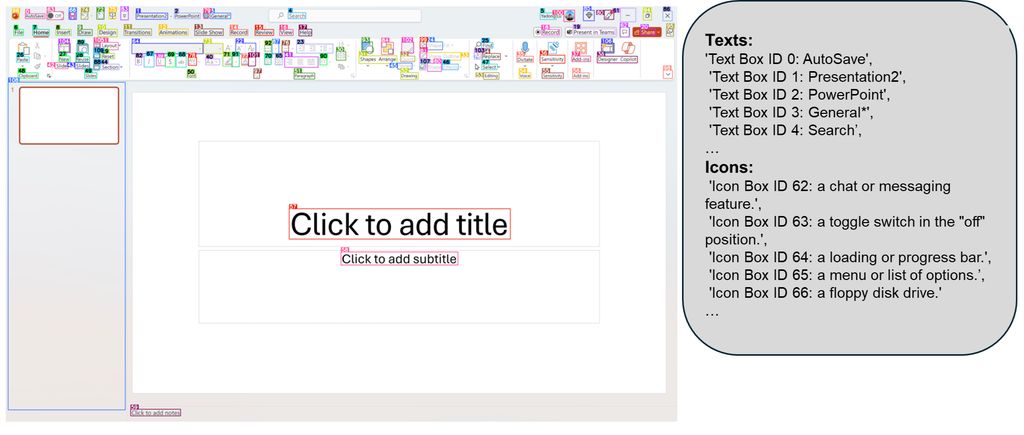

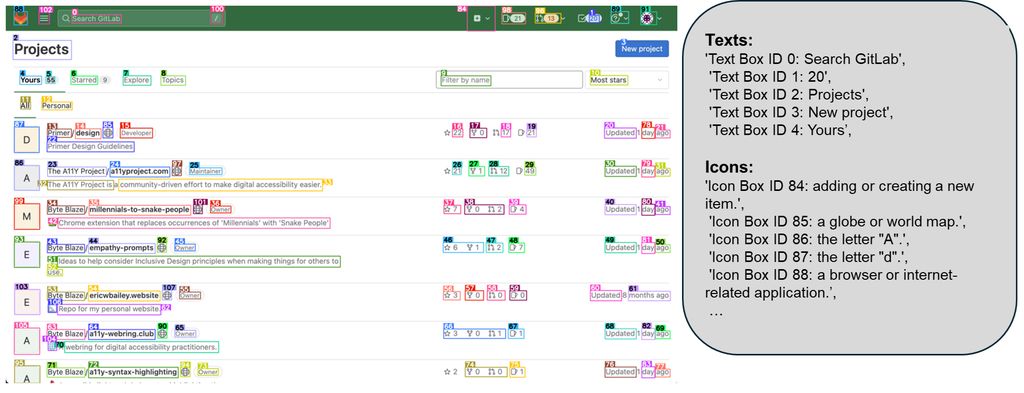

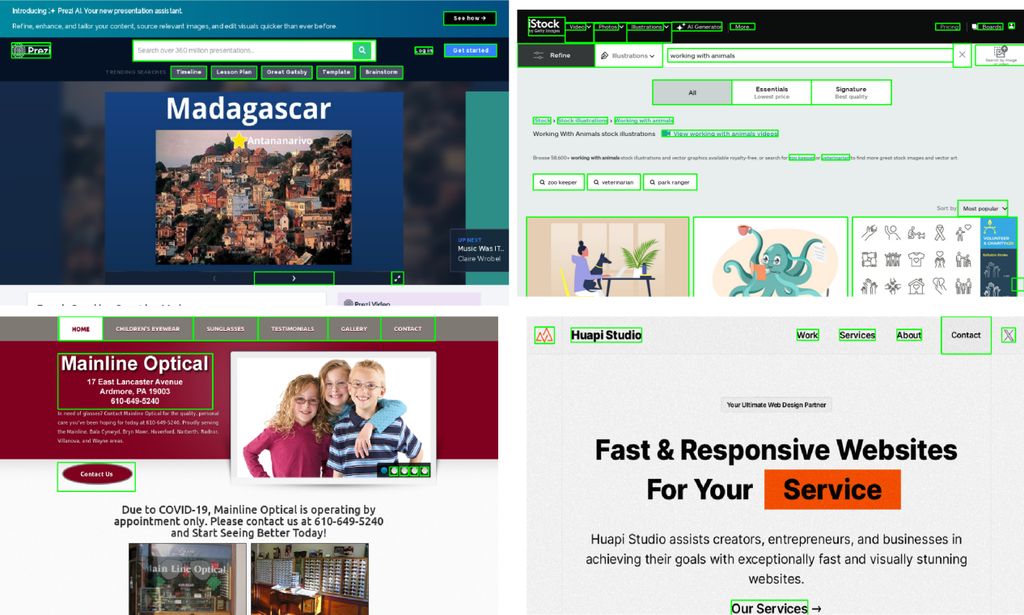

OmniParser 整合了可交互区域检测模型、图标描述模型和 OCR 模块等,避免了对 HTML 标签或视图层级等显式基础数据的需求,使其能够在多种平台(桌面、移动设备和网页)上有效工作,从而提高用户界面的解析准确性。

除了识别屏幕上的元素,OmniParser 还能够将这些元素转换为结构化数据。

测试表现

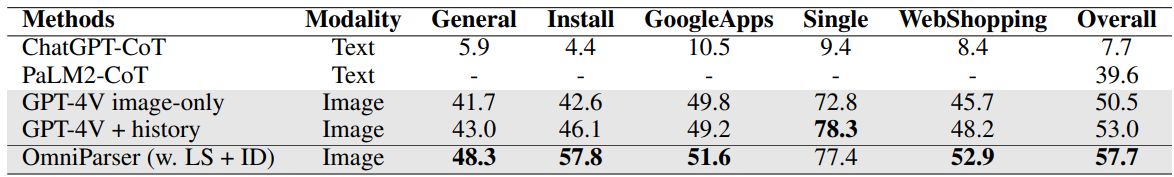

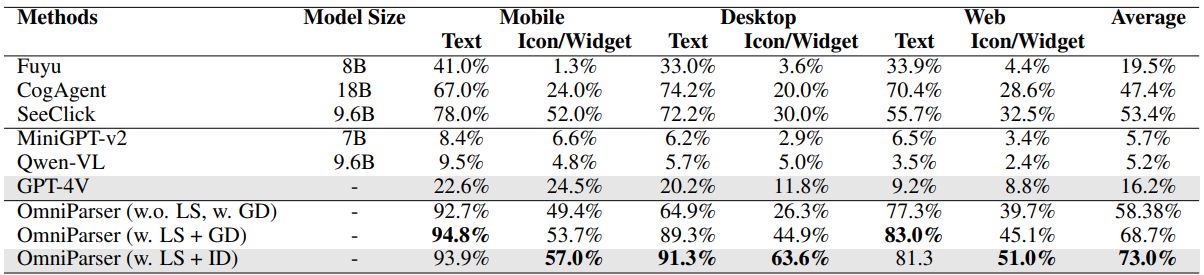

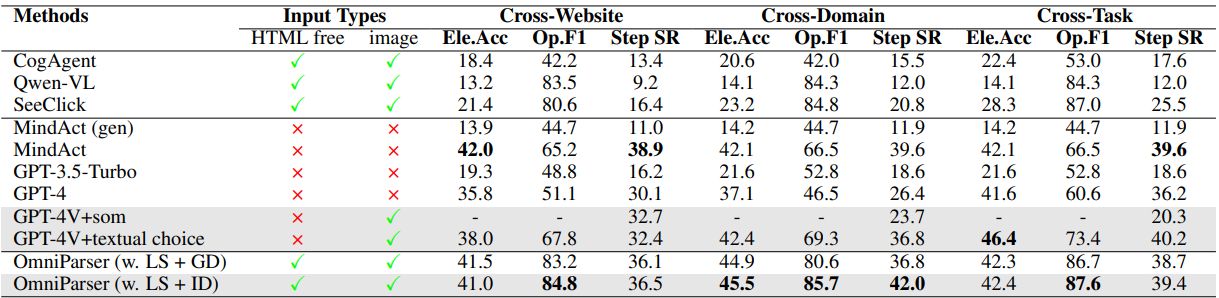

在多个基准测试中,OmniParser 展现出了卓越的性能。例如,在 ScreenSpot 数据集中,其准确率提高了 73%,显著优于依靠 HTML 解析的模型。

该工具设计不仅能够生成类似于文档对象模型(DOM)的结构化表示,还可以通过叠加边界框和功能标签来引导语言模型进行更准确的用户动作预测。

使用 OmniParser 输出后,GPT-4V 对图标的正确标记率从 70.5% 提升至 93.8%。这些显著改进表明,OmniParser 能有效解决当前 GUI 交互模型的基本问题。

OmniParser 的发布不仅扩展了智能体的应用范围,也为开发者提供了强大的工具,帮助创建更智能、更高效的用户界面驱动智能体。微软已在 Hugging Face 上发布 OmniParser,普及这一前沿技术,进一步推动了多模态 AI 的发展,特别是在无障碍、自动化和智能用户辅助等领域。

参考地址