一张显卡“看懂”一部电影:智源联合高校开源 Video-XL,打破长视频理解极限

长视频理解是多模态大模型核心能力之一,也是通向通用人工智能(AGI)的重要一步。然而,现有的多模态大模型在处理超过10分钟的超长视频时,依然面临性能与效率的双重挑战。

为了应对这一挑战,智源研究院与上海交通大学、中国人民大学、北京大学及北京邮电大学等多所高校联合推出了小时级的超长视频理解大模型 Video-XL。

Video-XL 利用语言模型(LLM)的原生能力对长视觉序列进行压缩,不仅保持了短视频理解的能力,而且在长视频理解方面展现了出色的泛化能力。

与同等参数规模的模型相比,Video-XL 在多个主流长视频理解基准评测中,多项任务都名列第一。

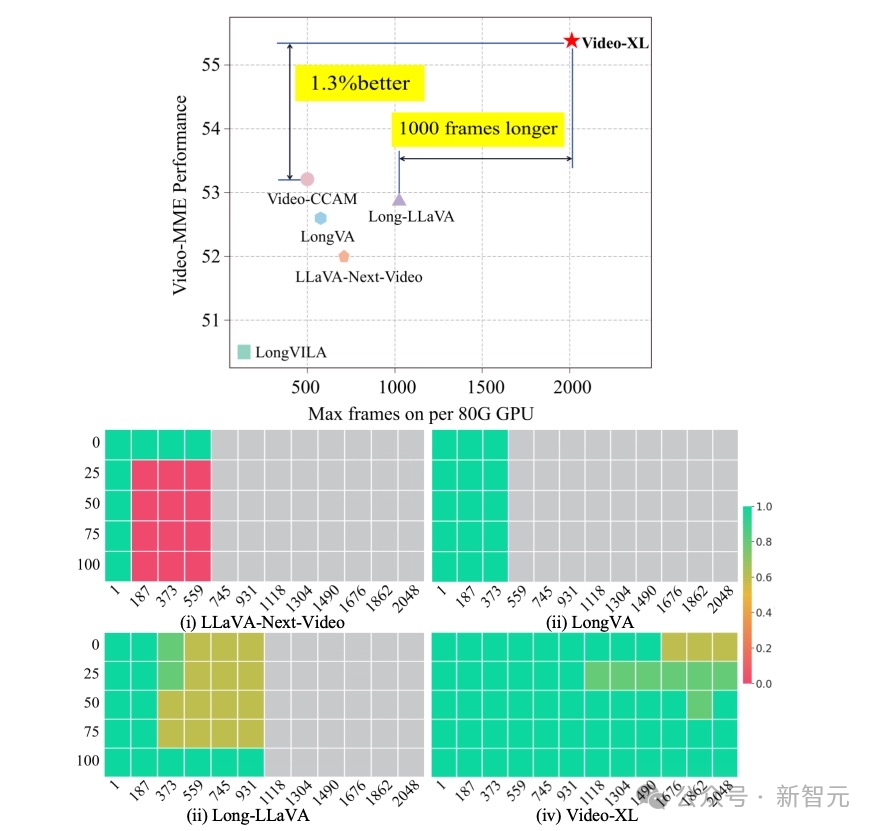

此外,Video-XL 在效率与性能之间实现了很好的平衡,仅需一块 80G 显存的显卡便能处理 2048 帧输入(对小时级长度视频进行采样),并在视频「大海捞针」任务中取得近 95% 的准确率。

展望未来,Video-XL 有望在电影摘要、视频异常检测、广告植入检测等应用场景中展现广泛的应用价值,成为长视频理解的得力助手。

-

论文标题:Video-XL: Extra-Long Vision Language Model for Hour-Scale Video Understanding

背景介绍

利用 MLLM 进行长视频理解蕴藏着巨大的研究与应用潜力。然而,当前的视频理解模型通常只能处理较短的视频,难以应对十分钟以上的视频内容。

尽管最近研究界出现了一些长视频理解模型,这些工作仍主要面临以下问题:

-

压缩视觉 token 导致的信息损失

为了使语言模型适应长视频所带来的大量视觉 token,各种方法尝试设计机制来压缩视觉 token,例如 LLaMA-VID 主要降低 token 数量,而 MovieChat、MALMM 则设计了 memory 模块以压缩帧信息。然而,这种信息压缩不可避免地带来了信息损失和性能下降。

-

性能与效率之间的不平衡

相关工作 LongVA 通过微调语言模型来扩大其上下文窗口,并成功将短视频理解能力扩展到长视频上。LongVila 优化了长视频训练的开销,提出了一种高效训练长视频的方法。然而,这些研究并未考虑推理时视频帧数增加带来的计算负担。

方法介绍

1. 模型结构

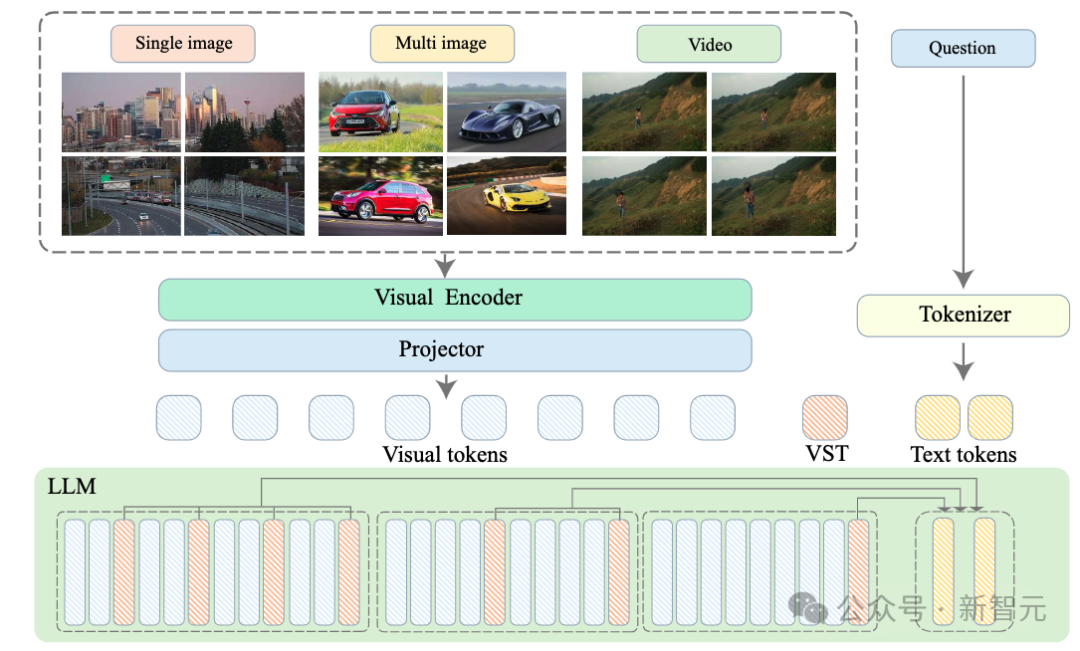

如图 2 所示,Video-XL 的整体模型结构与主流的 MLLMs 相似,包括视觉编码器(CLIP)、视觉-语言映射器(2-layer MLP)和语言模型(Qwen-7B)。

特别的是,Video-XL 为了处理各种多模态数据(单图、多图和视频),建立了统一的视觉编码机制。

-

对于多图和视频数据,将每帧分别输入 CLIP;

-

对于单图,将其划分为多个图像块,并将这些图像块输入 CLIP 进行编码。

因此,一个 N 帧的视频或一个 N 图像块的图片都将统一标记为 N×M 视觉 token。

2. 视觉上下文隐空间压缩

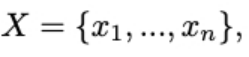

相比于以往长视频模型直接压缩视觉 token,Video-XL 尝试利用语言模型的上下文建模能力来对长视觉序列进行无损压缩。对于视觉语言连接器输出的视觉信号序列:

其中 n 为视觉 token 的数量。Video-XL 的目标是将 X 压缩为更紧凑的视觉表示 C(|C|<|X|)。以下将详细介绍视觉上下文隐空间压缩的原理。

受到 Activation Beacon 的启发,Video-XL 引入了一种新的特殊标记,称为视觉摘要标记(VST),记作<vs>。基于此,视觉信号的隐层特征可以压缩到 VST 在 LLM 中的激活表示中(每层的 Key 和 Value 值)。

具体而言,首先将视觉信号序列 X 划分为大小为 w 的窗口(默认每个窗口长度为 1440):

接着,针对每个窗口确定压缩比,并交替插入一组 VST 标记到视觉标记序列中。

在该过程中,视觉 token 表示的变化可以用以下公式表示:

LLM 将逐个处理每个窗口进行编码,并在每层自注意力模块中利用额外的投影矩阵处理 VST 的隐藏值。

编码完成后,普通视觉标记的激活值将被丢弃,而 VST 的激活值将被保留并累积,作为后续窗口处理时的视觉信号代理。

3. 模型训练方式

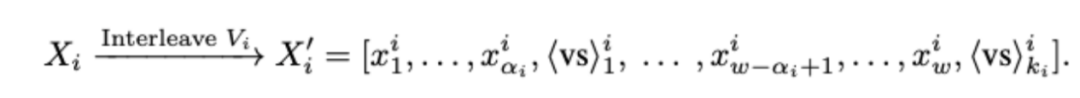

Video-XL 通过优化压缩视觉信号下的生成质量进行训练。

下一个 token 的预测通过以下公式进行计算:

其中 Θ 表示模型的所有优化参数,包括语言模型、视觉编码器、视觉语言连接器、VST 的投影矩阵及 VST 的 token embedding。

模型通过最小化标准的自回归损失进行训练,训练过程中不计算 VST 标记的损失(其标签设为 -100),因为它们仅用于压缩。

同时,为了灵活支持不同的压缩粒度,训练时每个窗口的压缩比会从 {2,4,8,12,16} 中随机抽取。在推理阶段,可以根据具体的效率需求选择一个压缩比并应用于所有窗口。

4. 模型训练数据

在预训练阶段,Video-XL 采用 Laion-2M 数据集优化视觉语言连接器。

在微调阶段,Video-XL 充分利用 MLLM 在各种多模态数据集上的能力。

-

在单图像数据方面,使用了 Bunny 695k 和 Sharegpt-4o 的 57k 张图片。

-

在多图像数据方面,使用了从 MMDU 提取的 5k 个数据。

-

在视频数据方面,收集了不同时长的视频样本,包括来自 NExT-QA 的 32k 样本,Sharegpt-4o 的 2k 视频样本,CinePile 的 10k 样本以及 11k 个带有 GPT-4V 视频字幕注释的私有数据。

为了增强长视频理解能力并释放视觉压缩机制的潜力,本工作开发了一个自动化的长视频数据生成流程,并创建了一个高质量数据集——视觉线索顺序数据(VICO)。

该流程首先从 CinePile 数据或 YouTube 等视频平台获取长视频,覆盖电影、纪录片、游戏、体育等多个开放领域的内容。每个长视频被分割成 14 秒的片段。

对于每个片段,本研究利用 VILA-1.5 40B 模型生成详细描述,包括动作序列和关键事件。基于这些描述,本研究通过 ChatGPT 将线索按时间顺序排列。

VICO 数据集通过要求模型检索关键帧并检测时间变化,提升了其长视频理解能力。

实验

1 . 评测基准

Video-XL 采用了多个主流视频理解评测基准,对长视频理解任务进行评测,如 VNBench、LongVideoBench、MLVU 和 Video-MME;对于短视频理解任务,评测了 MVBench 和 Next-QA。

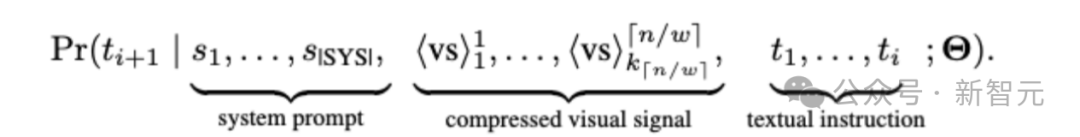

2. 评测结果

长视频理解:

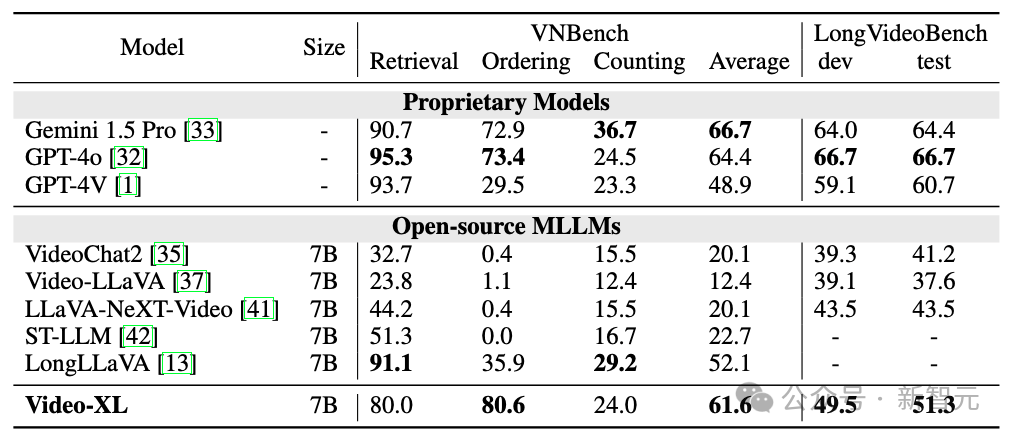

根据表 1 和表 2,Video-XL 在多个主流长视频评测基准上展现出卓越性能。

-

在 VNBench 上,准确率超越当前最佳长视频模型约 10%;

-

在 MLVU 的验证集上,具有仅 7B 参数的 Video-XL 甚至在单项选择任务中超过了 GPT-4o 模型;

-

在 Video-MME 和 LongVideoBench 等数据集中,Video-XL 也在同等量级的长视频理解模型中名列第一。

超长视频理解:

Video-XL 通过视频「大海捞针」测试评估其处理超长上下文的能力。

LLaVA-NexT-Video 和 LongLLaVA 尽管采用了简单的位置信息外推算法,在输入更多上下文时,仍难以理解关键信息。尽管 LongVA 通过微调 LLM 以处理更长输入,但高昂的计算成本限制了其在单块 80G GPU 上处理约 400 帧的能力。

相比之下,在相同硬件条件下,Video-XL 以 16 倍压缩比和 2048 帧的输入达到了近 95% 的准确率。这表明 Video-XL 在准确性与计算效率之间达到了最佳平衡。

短视频理解:

尽管 Video-XL 的设计主要面向长视频,但其依然保持了短视频理解的能力。在 MVBench 和 Next-QA 任务评测中,Video-XL 的表现与当前超级最佳模型相当。

3. 消融实验

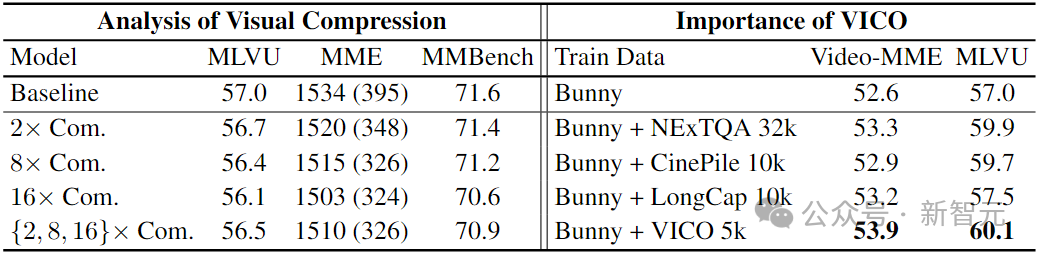

Video-XL 针对提出的视觉压缩机制和 VICO 数据集进行了消融实验,如表 3 所示。

-

视觉压缩的有效性

Video-XL 通过 Bunny 695k 数据集训练了两个模型:一个不使用压缩,另一个则使用随机压缩比(从 {2, 8, 16} 中选取)。

在 MLVU 和图像基准 MME、MMBench 上进行测试时,压缩模型在应用不同的压缩比时仍然展现出良好的效果,接近甚至超越基线模型。

-

VICO 数据集的有效性

Video-XL 使用不同数据集训练了四个模型:(a)仅使用 Bunny 695k;(b)Bunny 695k 结合 NeXTQA 32k;(c)Bunny 695k 结合 CinePile 10k;(d)Bunny 695k 结合长视频字幕 5k;(e)Bunny 695k 结合 VICO 5k。

值得注意的是,即使仅使用 5k 的 VICO 数据,Video-XL 也超越了使用 NeXTQA 32k 训练的模型。

此外,主要事件 / 动作排序任务比字幕生成任务带来了更显著的提升,因为其促使模型从长序列中提取关键片段并进行理解。

可视化结果

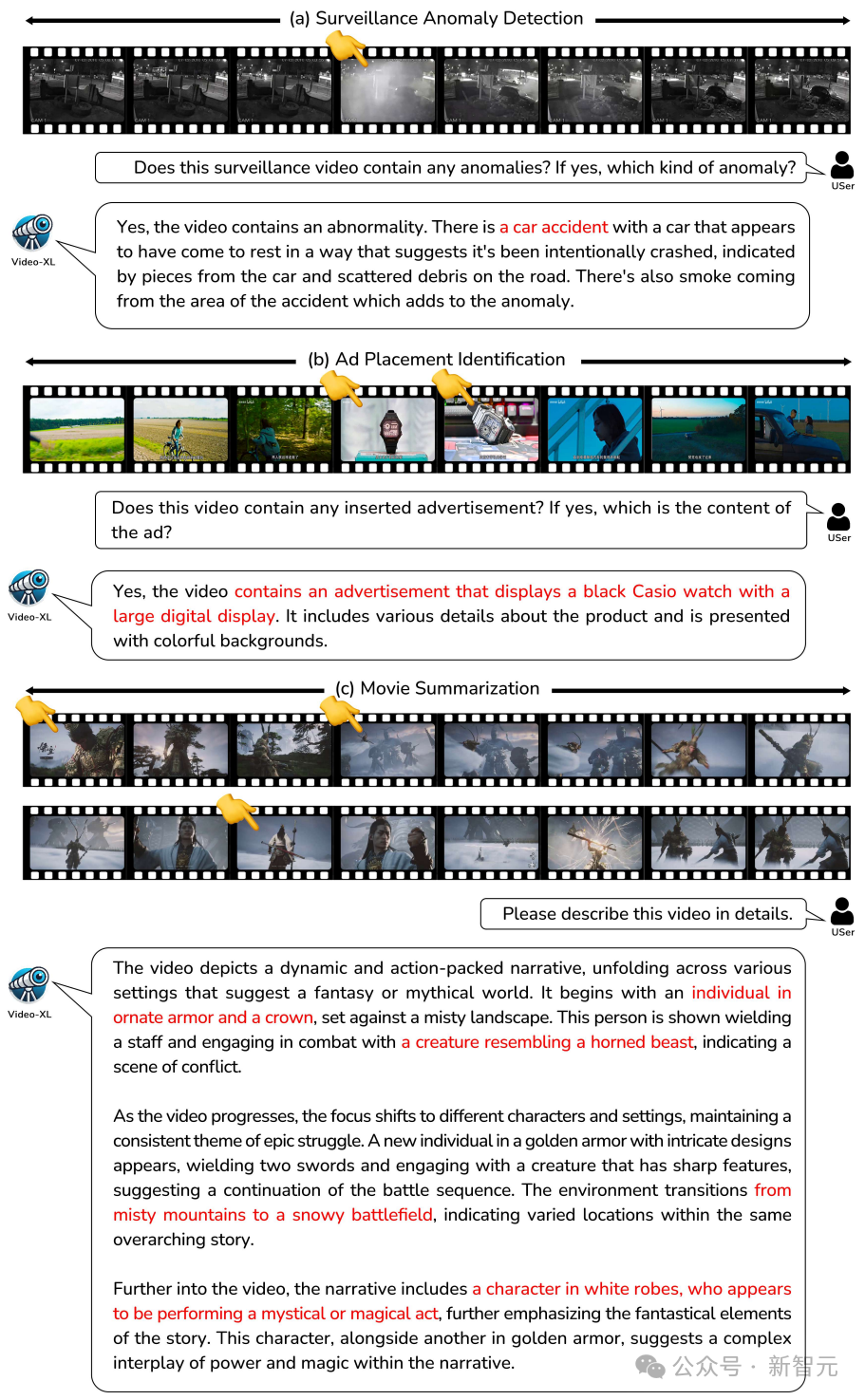

如图 3 所示,Video-XL 在电影摘要、视频异常检测、广告植入检测等长视频任务中表现良好。

总结

本研究提出了 Video-XL 模型,充分利用了语言模型的压缩能力,能够在仅一块 80G 显卡的支持下理解小时级别的视频。此外,Video-XL 在多个主流长视频理解基准评测中表现突出。

Video-XL 未来有望在多个长视频理解的应用场景中实现广泛的应用价值,成为长视频理解的得力助手。

目前,Video-XL 的模型代码已全部开源,旨在促进全球多模态视频理解研究的合作与技术共享。

参考资料:

本文来自微信公众号:微信公众号(ID:null),作者:编辑部 HYZ,原标题《一张显卡看遍天下电影!智源联合高校开源 Video-XL 打破长视频理解极限,95% 准确率刷爆纪录》