填补 AI 安全空白:谷歌上线安全人工智能框架风险评估工具

GoodNav 10 月 26 日报道,谷歌在 10 月 24 日发布的博文中宣布推出 SAIF 风险评估工具,该工具旨在协助人工智能开发者和组织评估其安全状态,识别潜在风险,并采取更有效的安全措施。

SAIF 概述

注:谷歌去年推出了安全人工智能框架(SAIF),目的是帮助用户安全、负责任地运用 AI 模型,SAIF 不仅分享了最佳实践,还为行业提供了安全设计的框架。

为推广这一框架,谷歌与行业合作伙伴共同成立了安全人工智能联盟(CoSAI),以推动重要的 AI 安全措施。

SAIF 风险评估工具

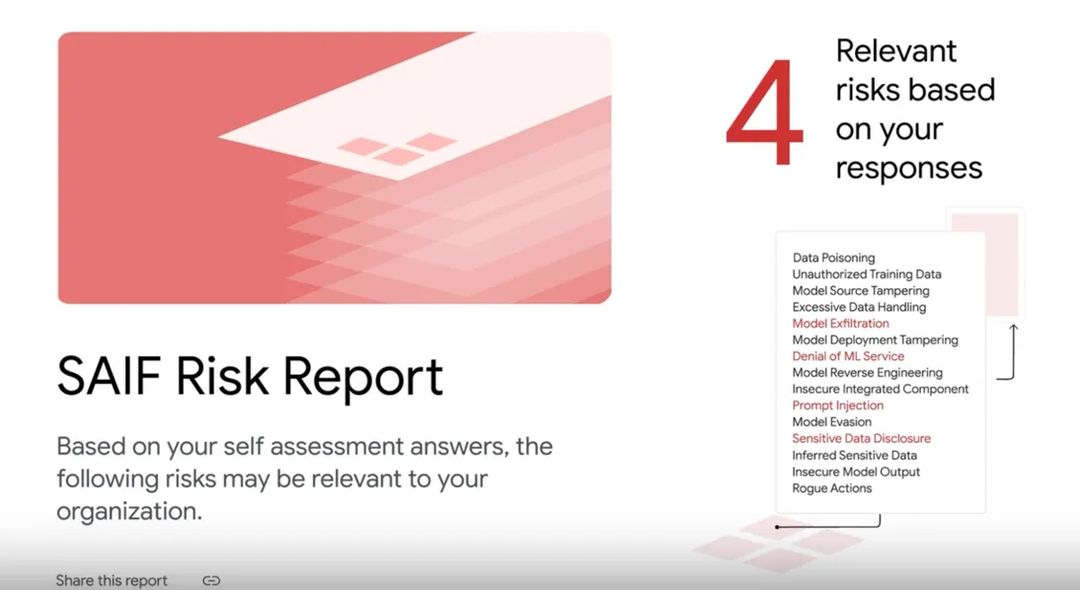

谷歌目前在新网站 SAIF.Google 提供 SAIF 风险评估工具,用户通过问答的方式进行评估,回答后系统会生成一个定制的检查清单,以指导他们确保 AI 系统的安全。

该工具涵盖多个主题,具体包括:

-

AI 系统的训练、调优和评估

-

对模型和数据集的访问控制

-

防止攻击和对抗性输入

-

生成性 AI 的安全设计和编码框架

用户完成问答后,工具会立即生成报告,突出 AI 系统可能面临的具体风险,例如数据中毒、提示注入和模型源篡改等。

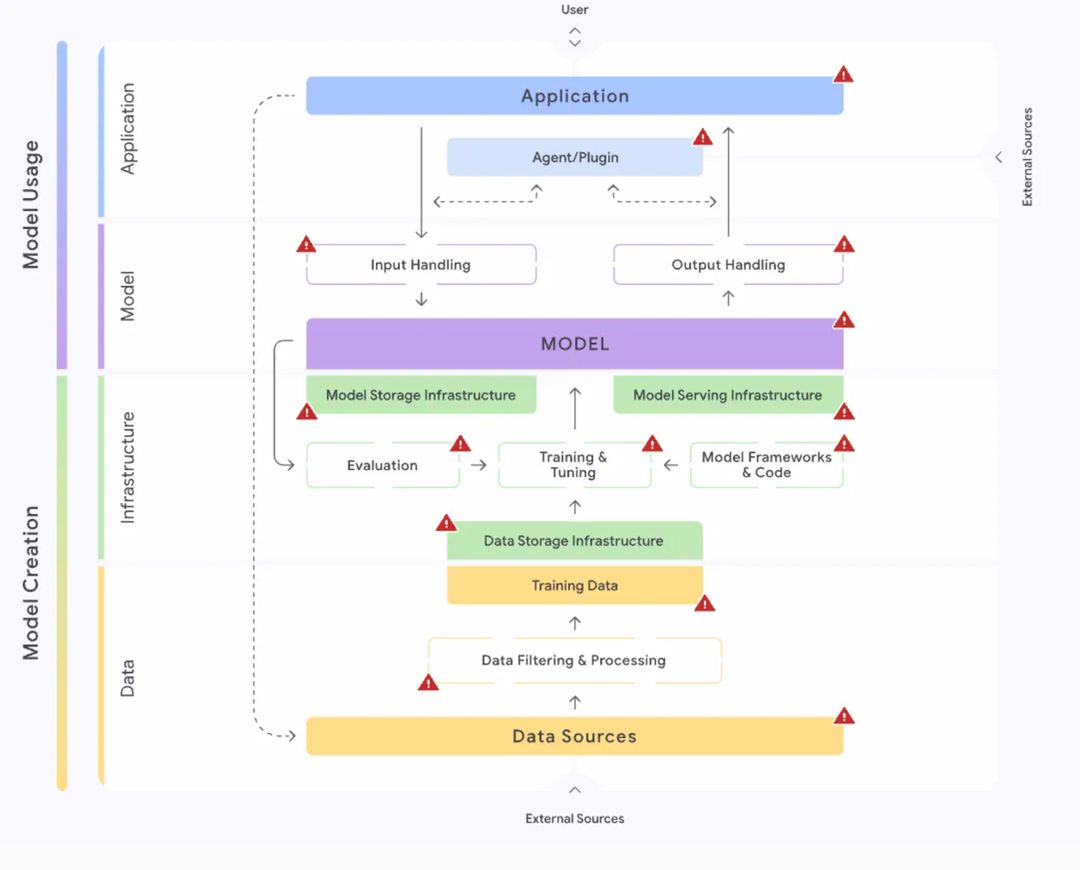

每个风险都会附有详细的解释和建议的缓解措施。此外,用户还可以通过互动的 SAIF 风险地图了解在 AI 开发过程中如何识别和缓解不同的安全风险。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...