Meta 推出 Llama 3.2 1B / 3B 模型量化版:功耗更低、可适用更多轻量移动设备

GoodNav 10 月 27 日报道,Meta 于 10 月 24 日发布了其在今年 9 月开源的 Llama 3.2 1B 和 3B 模型的量化版本。这些量化后的模型体积平均减少了 56%,RAM 使用率下降了 41%,性能提升了 2 到 4 倍,同时功耗降低,从而使这些模型能够在更多移动设备上进行部署。

备注:模型量化(Model Quantization)是指通过多种训练方法将浮点模型转换为定点模型,这样可以压缩模型参数并降低其复杂度,以便在更轻便的平台上运行。

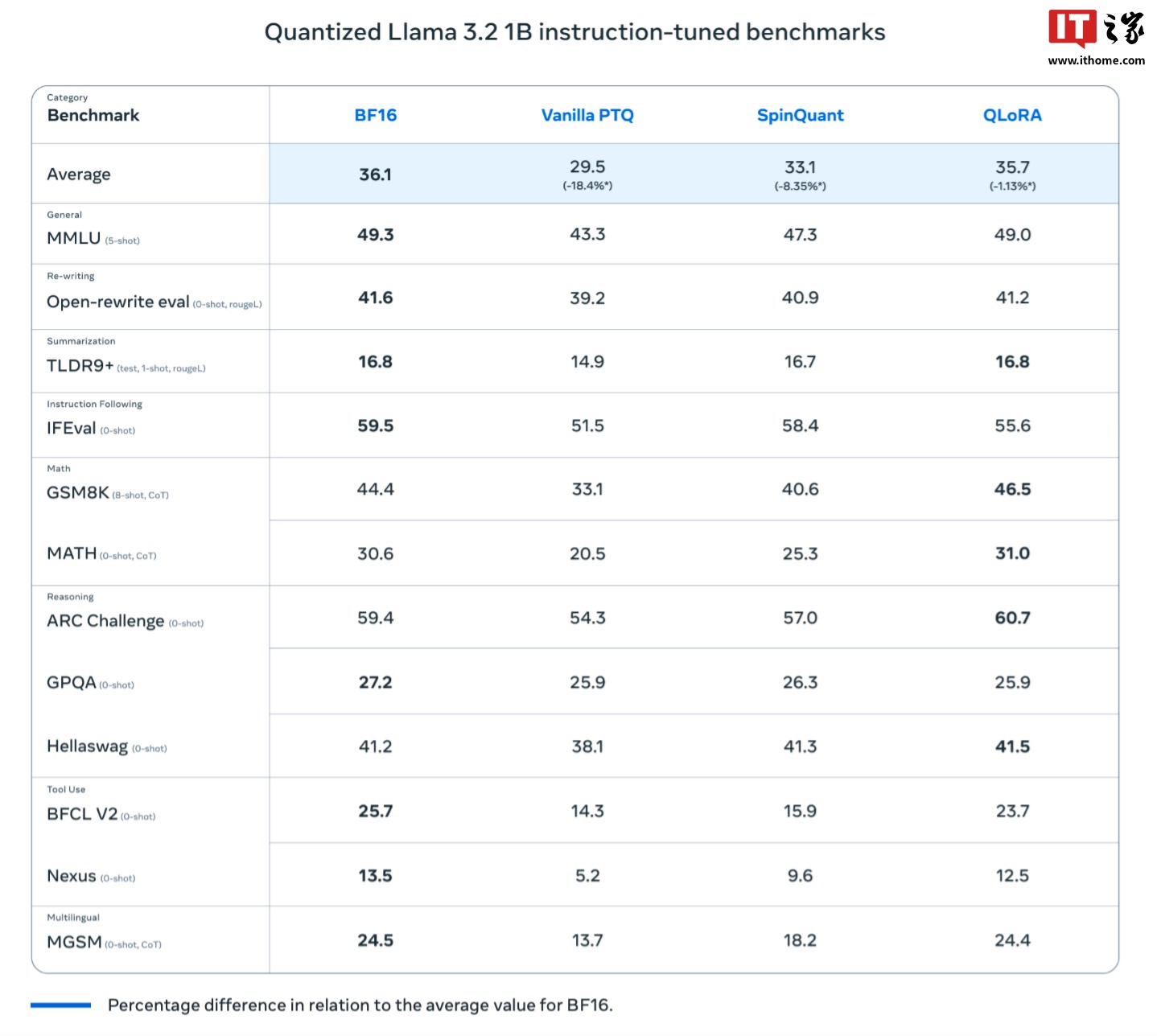

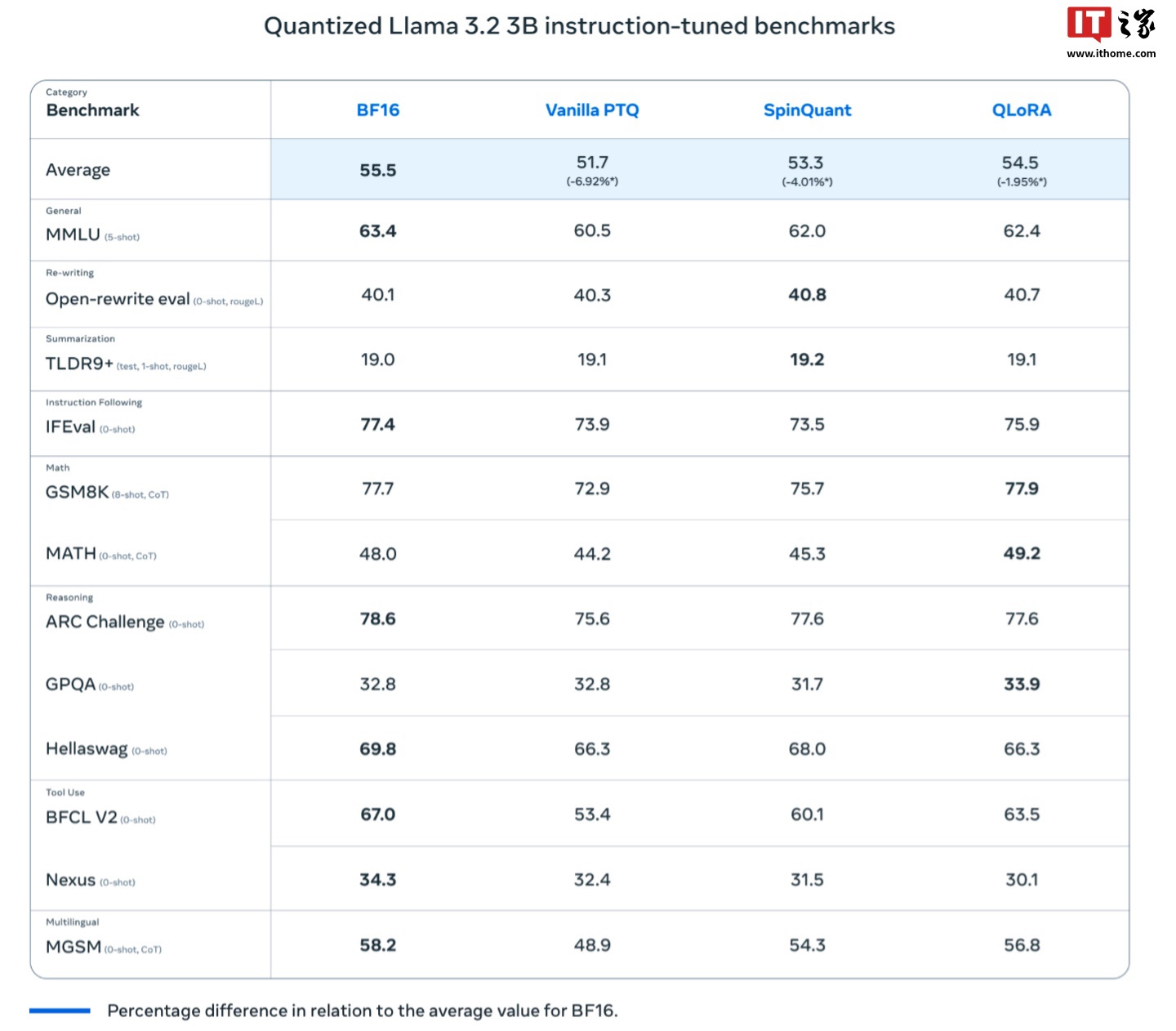

Meta 表示,他们使用了量化感知训练(Quantization-Aware Training,QAT)和后训练量化(SpinQuant)这两种技术对模型进行了量化,其中“量化感知训练”主要关注模型的精准度,而“后训练量化”则更注重模型的可携带性。

据悉,研究团队为 Llama 3.2 的 1B 和 3B 模型分别推出了两个量化版本,名称为 Llama 3.2 1B QLoRA、Llama 3.2 1B SpinQuant、Llama 3.2 3B QLoRA 和 Llama 3.2 3B SpinQuant。

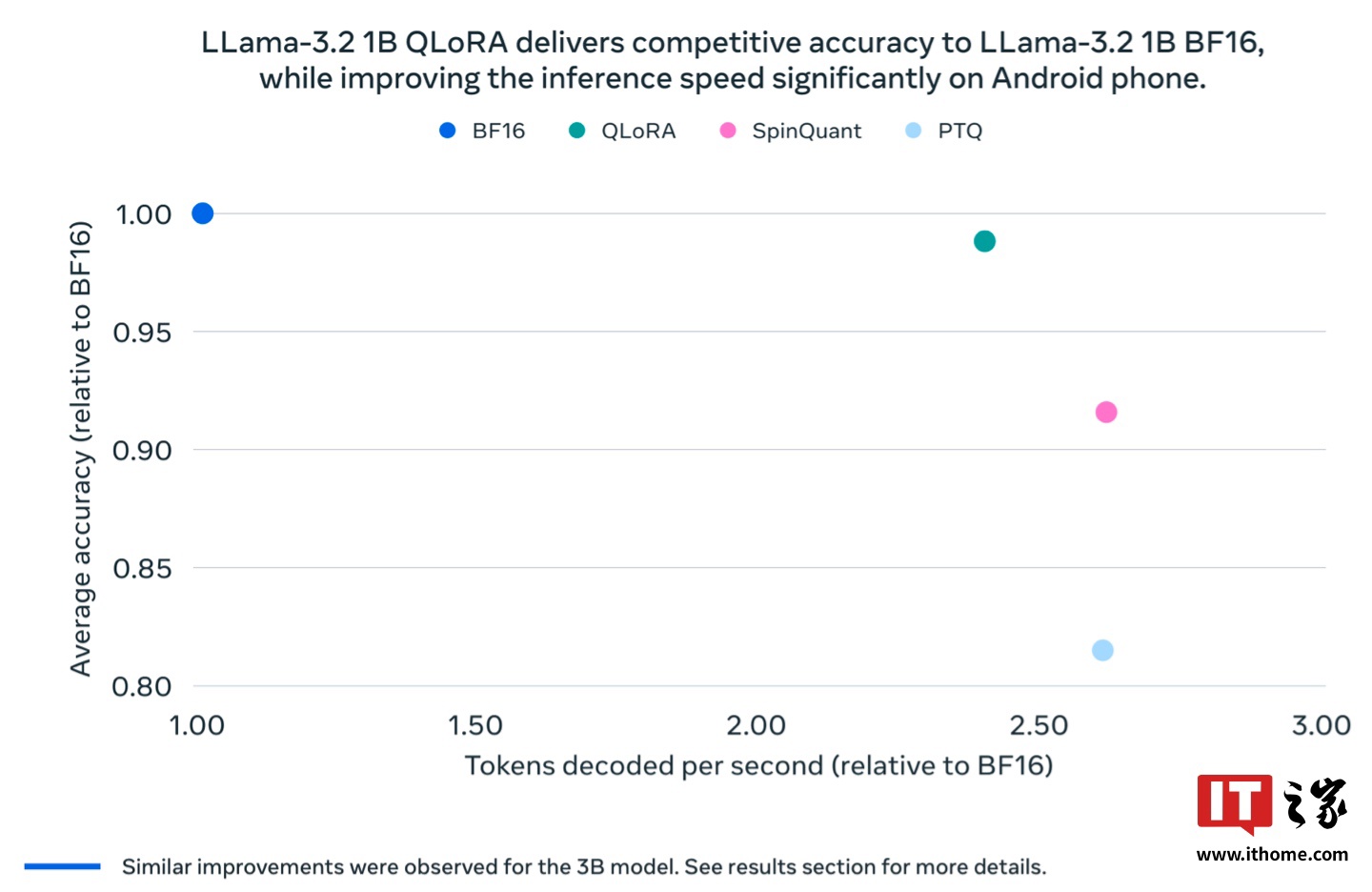

Meta 声称,这些量化后的模型不仅速度更快,占用更少的 RAM 资源,而且功耗也相对更低,同时与 Llama BF16 版本在精准度上几乎保持一致。

尽管量化版本的 Llama 3.2 1B 和 3B 模型仅能处理 8000 个 Token 的上下文(而原始模型支持 12.8 万个 Token),但 Meta 的测试发现,无论是 Llama QLoRA 还是 Llama SpinQuant,量化版本在基准测试中的表现与原版 Llama BF16 类似。

目前,Meta 在一加 12、三星 S24+/S22 及一些苹果 iOS 设备(具体型号未披露)上测试了这些量化模型,结果显示“运行表现良好”,未来研究人员计划通过神经处理单元(NPU)进一步提升这些量化模型的性能。