美国女子起诉聊天机器人平台 Character.AI:称其导致儿子自杀

GoodNav 10 月 24 日报道,美国一位 14 岁的男孩自杀身亡,母亲梅根·加西亚 (Megan Garcia) 对聊天机器人平台 Character.AI 及其创始人诺姆·沙泽尔 (Noam Shazeer) 和丹尼尔·德弗雷塔斯 (Daniel De Freitas) 以及谷歌提起诉讼。诉讼指控内容包括过失致死(wrongful death)、疏忽(negligence)、欺骗性商业行为(deceptive trade practices)和产品责任(product liability)。起诉书指出,Character.AI 平台“存在不合理的危险”,并且在向儿童推广时缺乏必要的安全措施。

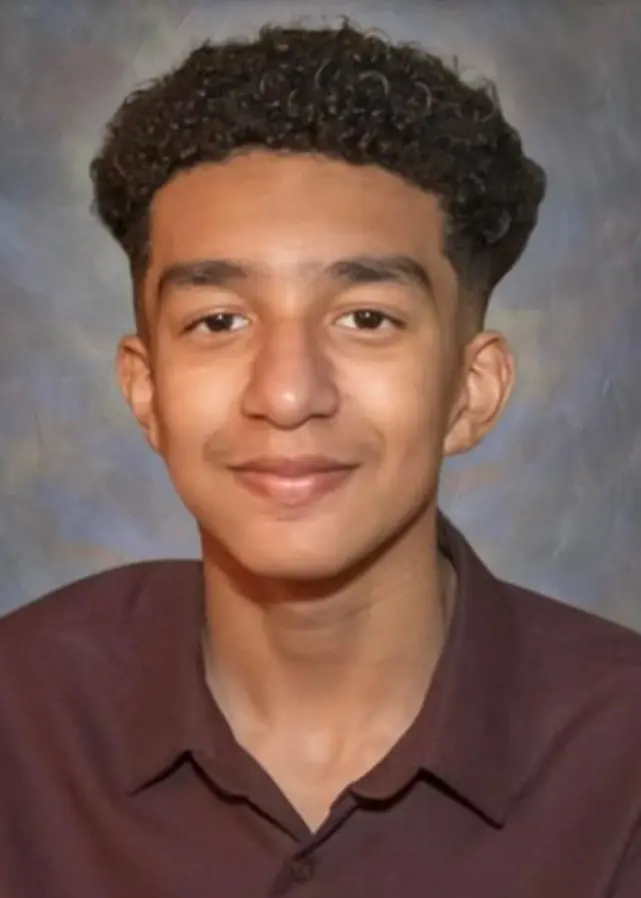

根据诉讼,14 岁的少年塞维尔·塞泽尔三世 (Sewell Setzer III) 自去年开始使用 Character.AI,并与以《权力的游戏》角色为蓝本的聊天机器人对话,包括丹妮莉丝·坦格利安 (Daenerys Targaryen)。在去世前几个月,他一直与这些机器人互动,并在 2024 年 2 月 28 日最后一次对话后自杀,时间“仅几秒”后。

诉讼指控 Character.AI 平台存在“拟人化”人工智能角色及聊天机器人提供“无执照心理治疗”等问题。该平台以“治疗师”和“感到孤独吗?”等名义提供专注于心理健康的聊天机器人,而塞泽尔曾与如此类机器人进行对话。

加西亚的律师援引沙泽尔先前在采访中提到的内容,沙泽尔表示他和德弗雷塔斯离开谷歌创立自己的公司是因为“在大公司推出有趣的项目存在品牌风险”,并希望“加速”该技术的进展。诉状还提到,他们是在谷歌决定不推出他们开发的 Meena 大型语言模型后选择离开的。谷歌则在今年 8 月收购了 Character.AI 的核心团队。

据了解,Character.AI 的网站和移动应用程序中有数百个定制的聊天机器人,其中不少是来源于流行电视剧、电影及电子游戏的角色。

Character.AI 现已宣布对平台进行一些改进。公司通讯负责人切尔西·哈里森 (Chelsea Harrison) 在发给《The Verge》的电子邮件中表示:“我们对失去一位用户感到无比悲痛,并向其家属致以最深切的慰问。”

部分改进措施包括:

-

针对未成年人(18 岁以下)的模型进行调整,以降低接触敏感或暗示性内容的可能性。

-

增强对用户输入中违反平台条款或社区准则的检测、响应与干预能力。

-

每次对话中都会显示修订后的免责声明,提醒用户人工智能并非真实人类。

-

当用户在平台上进行一小时的对话时会收到提示,用户可自行选择后续操作。

哈里森表示:“作为一家公司,我们非常关注用户的安全,我们的信任与安全团队在过去六个月内实施了多项新安全措施,包括在用户使用自残或自杀相关术语时弹出窗口,指引用户前往国家自杀预防生命线。”