英伟达新 nGPT 架构撬动 AI 未来:超球面学习提效,训练模型时间可缩短至 1/20

GoodNav 10 月 22 日讯,科技新闻网站 dataconomy 于昨日(10 月 21 日)发表博文,指出英伟达在人工智能模型训练上取得了显著进展,推出了新架构 Normalized Transformer(nGPT),在维持模型稳定性和准确性的前提下,能将 AI 的训练时间缩短至原来的 1/4 或者 1/20。

nGPT 架构效率提升的关键在于“超球面学习”(Hyperspherical learning)这一概念。

传统变换器模型往往缺乏统一的几何框架,而 nGPT 通过将嵌入、注意力矩阵和隐藏状态等关键要素映射到超球面上,确保训练过程中模型各层能够保持平衡。

这种几何结构促进了更稳定和高效的学习过程:

-

减少训练步骤:nGPT 不再对模型权重施加权重衰减,而是利用学习得来的缩放参数,对模型的训练过程调整效率进行优化。

-

简化过程:这种方法消除了对 LayerNorm 或 RMSNorm 等归一化手段的依赖,使得训练过程变得更加简单和快速。

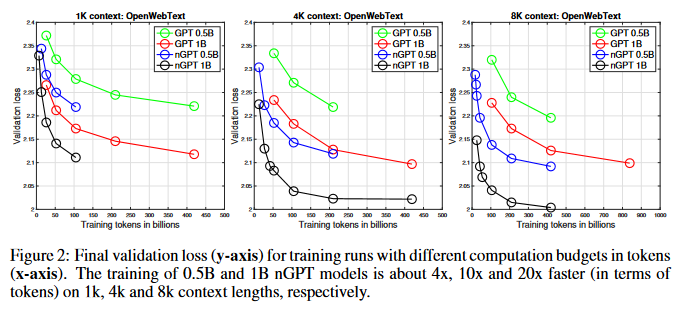

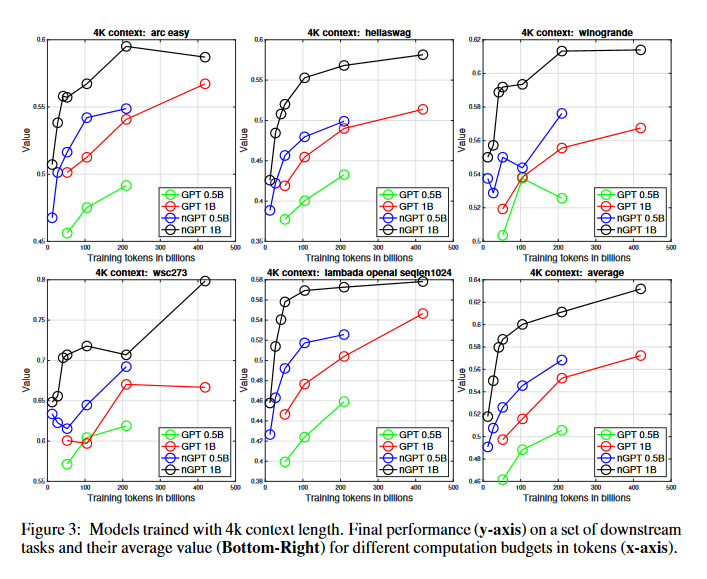

英伟达团队使用 OpenWebText 数据集进行实测,发现 nGPT 在速度和效率上均超越了传统的 GPT 模型。对于长度达到 4000 个 tokens 的文本输入,nGPT 所需的训练轮次明显低于传统模型,从而大幅度缩短了训练时间。

nGPT 的一大特点是将归一化(normalization)与表示学习(representation learning)融合为一个统一框架,此设计简化了模型结构,便于扩展和适应更为复杂的混合系统。未来,nGPT 的理念可能会被纳入其他模型和架构中,以开发出更为强大的 AI 系统。

参考地址

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...