整合海量公共数据,谷歌开源 AI 统计学专家 DataGemma

准确的统计数据和及时的信息一直是大语言模型产生幻觉的主要问题。

知识是现成的,但学习却是困难的。这并非因为个人懒惰,而是现实中存在太多障碍。

针对这一问题,谷歌最近推出了经过长时间筹备的大型数据库 Data Commons,以及基于此数据库开发的大模型 DataGemma。

论文地址:https://docs.datacommons.org/papers/DataGemma-FullPaper.pdf

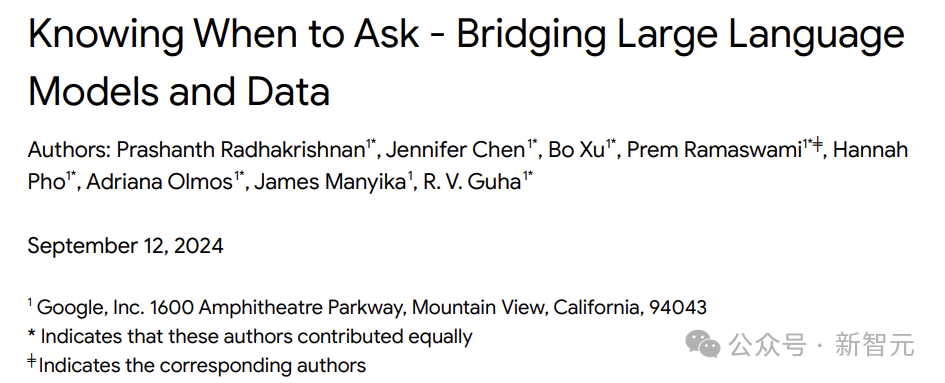

Data Commons 是一个庞大的开源公共统计数据存储库,包含来自联合国(UN)、疾病控制与预防中心(CDC)、人口普查局、卫生部、环境机构、经济部门、非政府组织和学术机构等可信来源的大量统计数据。

目前,整个语料库包含超过 2500 亿个数据点和超过 2.5 万亿个三元组。

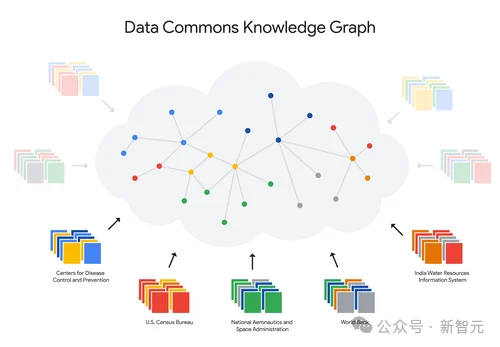

数据已经存在,模型该如何处理?本文提出了一种将 LLM 连接到数据的通用架构,并探讨了需要解决的三个问题。

首先,LLM 必须学会在适当的时机选择,是使用存储在模型参数中的知识,还是从外部获取信息。

当然,关于何时查询外部源的问题,需要 LLM 学会将其纳入自己的参数,这可以通过多种机制实现。

其次,需要决定应该从哪个外部源查询所需的信息,因为可用的信息源可能很多且是动态的。在本文中,作者直接使用单一外部信息源来整合大量数据源。

最后,一旦明确了需要哪些外部数据,LLM 就需要生成一个或多个查询来获取这些数据。

一般来说,不同的来源会产生不同类型的数据,如果 LLM 还要专门学习各种 API,那就会变得相当复杂。因此,作者开发了一个用于外部数据和服务的单一通用 API。

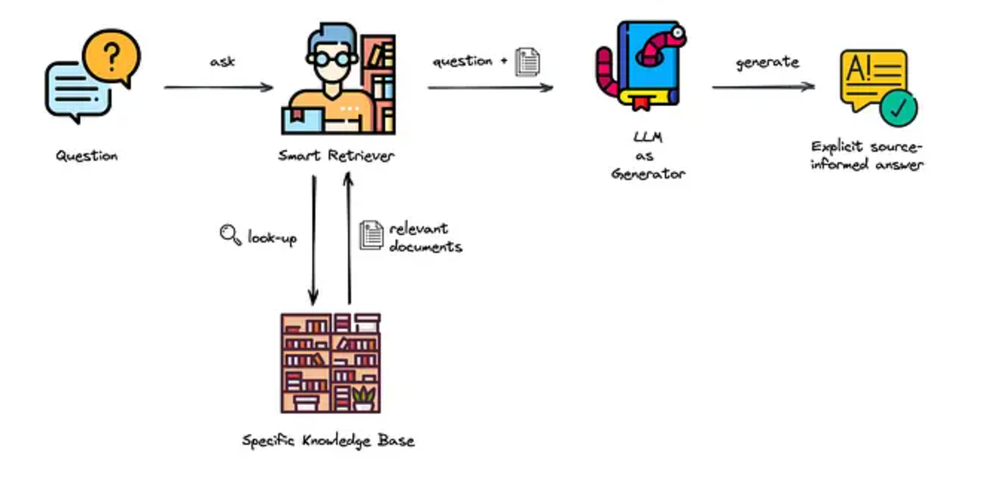

该 API 的灵感来源于 Robert McCool 在 1993 年设计的 URL 参数编码接口,虽然简单,却经受住了时间的考验,是目前网络上最接近通用 API 的接口。

作者使用自然语言来表达查询,返回的答案可以用 mime-type 来增强,以支持非文本答案。

通过这些步骤,一个能够充分利用最新和最全面外部数据的「AI 统计学家」(或称统计学魔术师)就此诞生。

<img title=\"整合海量公共数据,谷歌开源 AI 统计学专家 DataGemma\" src=\"