英伟达发布 Llama-3.1-Nemotron-51B AI 模型:创新神经架构搜索等技术让单 H100 GPU 运行 4 倍以上负载

GoodNav 9 月 25 日报道,英伟达于 9 月 23 日发布了一篇博文,宣布推出 Llama-3.1-Nemotron-51B AI 模型,该模型源自 Meta 公司的 Llama-3.1-70B,并创新性地采用了神经架构搜索(NAS)技术,构建了一个高效且准确的模型。

Llama-3.1-Nemotron-51B 概述

Llama-3.1-Nemotron-51B AI 模型基于 Meta 公司 2024 年 7 月发布的 Llama-3.1-70B 模型,参数总数达到 510 亿。

该 AI 模型主要通过神经架构搜索(NAS)技术进行微调,旨在平衡性能与效率。在高负载情况下,仅需一块 H100 GPU 即可运行,显著降低了内存消耗、计算复杂性及与运行此类大型模型相关的成本。

英伟达认为,这种方法在保持卓越精度的同时,显著减少了内存占用、内存带宽和 FLOPs,并证明可以创建更小、更快的变体以进行推广。

Llama-3.1-Nemotron-51B 性能

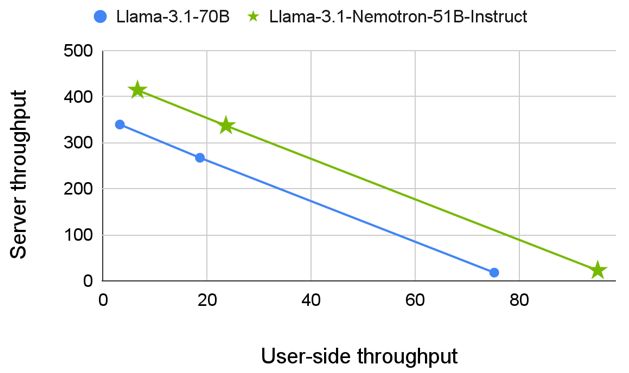

与 Meta 的 Llama-3.1-70B 模型相比,Llama-3.1-Nemotron-51B 在几乎相同精度的基础上,推理速度提升了 2.2 倍。

| 准确率 | 能效 | |||

| MT Bench | MMLU | 文本生成 (128/1024) | 摘要/ RAG (2048/128) | |

| Llama-3.1- Nemotron-51B- Instruct | 8.99 | 80.2% | 6472 | 653 |

| Llama 3.1-70B- Instruct | 8.93 | 81.66% | 2975 | 339 |

| Llama 3.1-70B- Instruct (单 GPU) | — | — | 1274 | 301 |

| Llama 3-70B | 8.94 | 80.17% | 2975 | 339 |

效率与性能的突破

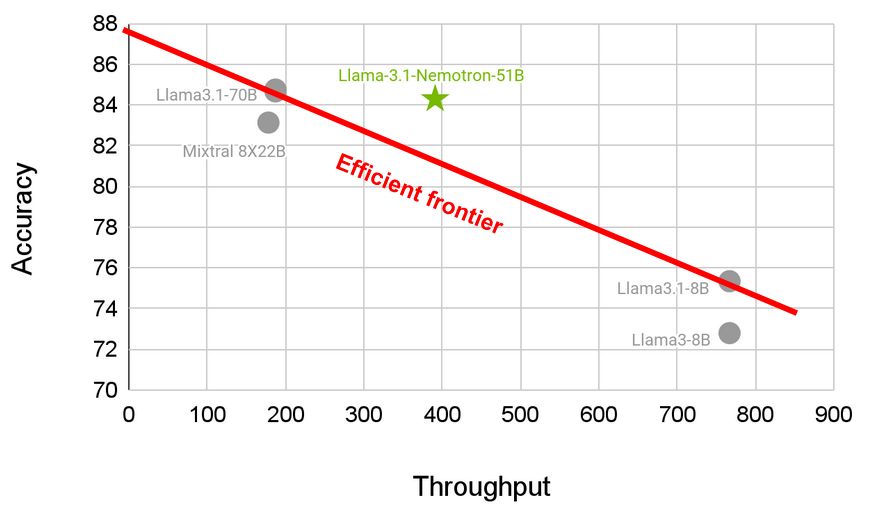

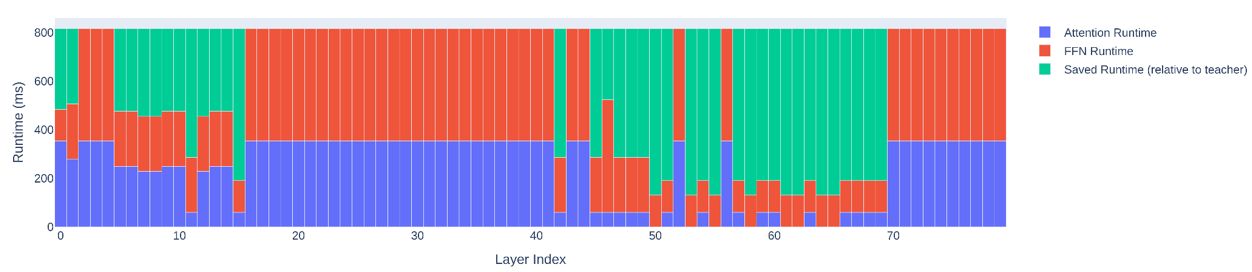

在开发 LLM 的过程中,主要挑战之一是如何平衡精度与计算效率。许多大型模型虽然能提供最先进的结果,但却需要消耗大量的硬件和能源资源,这限制了它们的适用性。

英伟达的新模型在这两个相互竞争的因素之间取得了微妙的平衡。

Llama-3.1-Nemotron-51B 实现了令人印象深刻的精度与效率的平衡,减少了内存带宽,降低了每秒浮点运算次数 (FLOP),并减少了总体内存占用,同时不影响模型在推理、总结和语言生成等复杂任务中的表现。

改进工作负载管理,提高成本效益

Llama-3.1-Nemotron-51B 的一个显著特点是能够在单个 GPU 上处理更大的工作负载。该型号使开发人员能够在更具成本效益的环境中部署高性能 LLMs,能够在一块 H100 设备上完成以前需要多个 GPU 的任务。

Llama-3.1-Nemotron-51B 模型还减少了内存占用,在推理过程中可以在单个 GPU 上运行 4 倍以上的工作负载,从而带来了许多新的机遇。

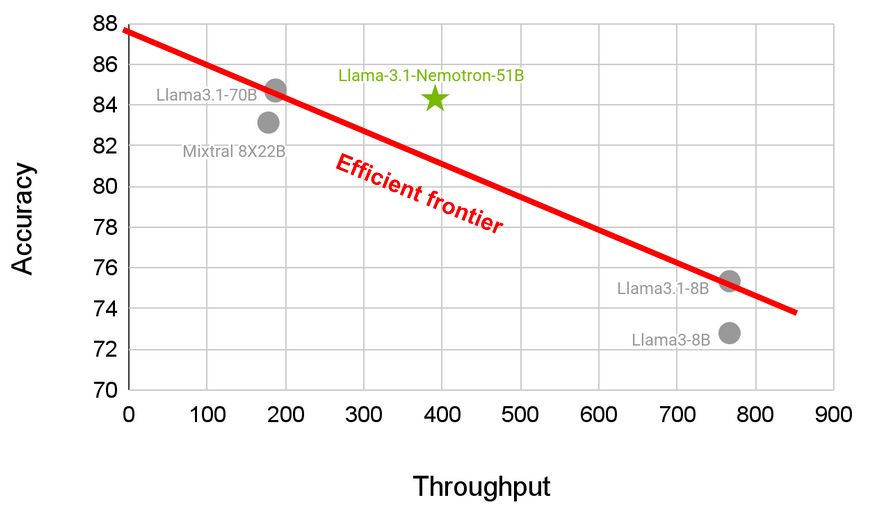

架构优化:成功的关键

Llama-3.1-Nemotron-51B 的成功主要归功于一种新颖的结构优化方法。传统上,LLMs 是使用相同的模块构建的,这些模块在整个模型中重复出现。

虽然这种方法简化了构建过程,但也导致了效率低下的问题,尤其是在内存和计算成本方面。

英伟达通过采用 NAS 技术来优化推理模型,从而解决了这些问题。该团队采用了分块蒸馏过程,即训练更小、更高效的学生模型(student model),以模仿更大的教师模型(teacher model)的功能。

通过完善这些学生模型并评估其性能,英伟达开发出了 Llama-3.1 版本,在大幅降低资源需求的同时,仍能提供类似的准确度。

Puzzle 算法与知识蒸馏

Llama-3.1-Nemotron-51B 的另一个关键组成部分是 Puzzle 算法。

该算法对模型中的每个潜在模块进行评分,并确定哪些配置能够在速度与精度之间取得最佳平衡。

| 跑分 | Llama-3.1 70B-instruct | Llama-3.1-Nemotron-51B- Instruct | 准确率 |

| winogrande | 85.08% | 84.53% | 99.35% |

| arc_challenge | 70.39% | 69.20% | 98.30% |

| MMLU | 81.66% | 80.20% | 98.21% |

| hellaswag | 86.44% | 85.58% | 99.01% |

| gsm8k | 92.04% | 91.43% | 99.34% |

| truthfulqa | 59.86% | 58.63% | 97.94% |

| xlsum_english | 33.86% | 31.61% | 93.36% |

| MMLU Chat | 81.76% | 80.58% | 98.55% |

| gsm8k Chat | 81.58% | 81.88% | 100.37% |

| Instruct HumanEval (n=20) | 75.85% | 73.84% | 97.35% |

| MT Bench | 8.93 | 8.99 | 100.67% |

通过应用知识蒸馏技术,Nvidia 缩小了参考模型(Llama-3.1-70B)与 Nemotron-51B 之间的精度差距,同时显著降低了训练成本。

| 场景 | 输入/输出序列长度 | Llama-3.1- Nemotron- Instruct | Llama-3.1-70B-Instruct | 比例 | Llama (TP1) |

| 聊天机器人 | 128/128 | 5478 (TP1) | 2645 (TP1) | 2.07 | 2645 |

| 文本生成 | 128/1024 | 6472 (TP1) | 2975 (TP4) | 2.17 | 1274 |

| 长文本生成 | 128/2048 | 4910 (TP2) | 2786 (TP4) | 1.76 | 646 |

| 系统 2 推理 | 128/4096 | 3855 (TP2) | 1828 (TP4) | 2.11 | 313 |

| 摘要/ RAG | 2048/128 | 653 (TP1) | 339 (TP4) | 1.92 | 300 |

| 压力测试 1 | 2048/2048 | 2622 (TP2) | 1336 (TP4) | 1.96 | 319 |

参考链接