端侧最强开源 AI 模型 Llama 3.2 登场:可在手机运行,从 1B 纯文本到 90B 多模态,挑战 OpenAI 4o mini

GoodNav 9 月 26 日报道,Meta 公司于昨日(9 月 25 日)发布了一篇博文,正式推出了 Llama 3.2 AI 模型。该模型以开放和可定制为特点,开发者可以根据需求进行定制,以实现边缘人工智能和视觉革命。

Llama 3.2 提供了多模态视觉和轻量级模型,代表了 Meta 在大型语言模型(LLMs)领域的最新进展,能够在多种使用场景中提供更强大的功能和更广泛的适用性。

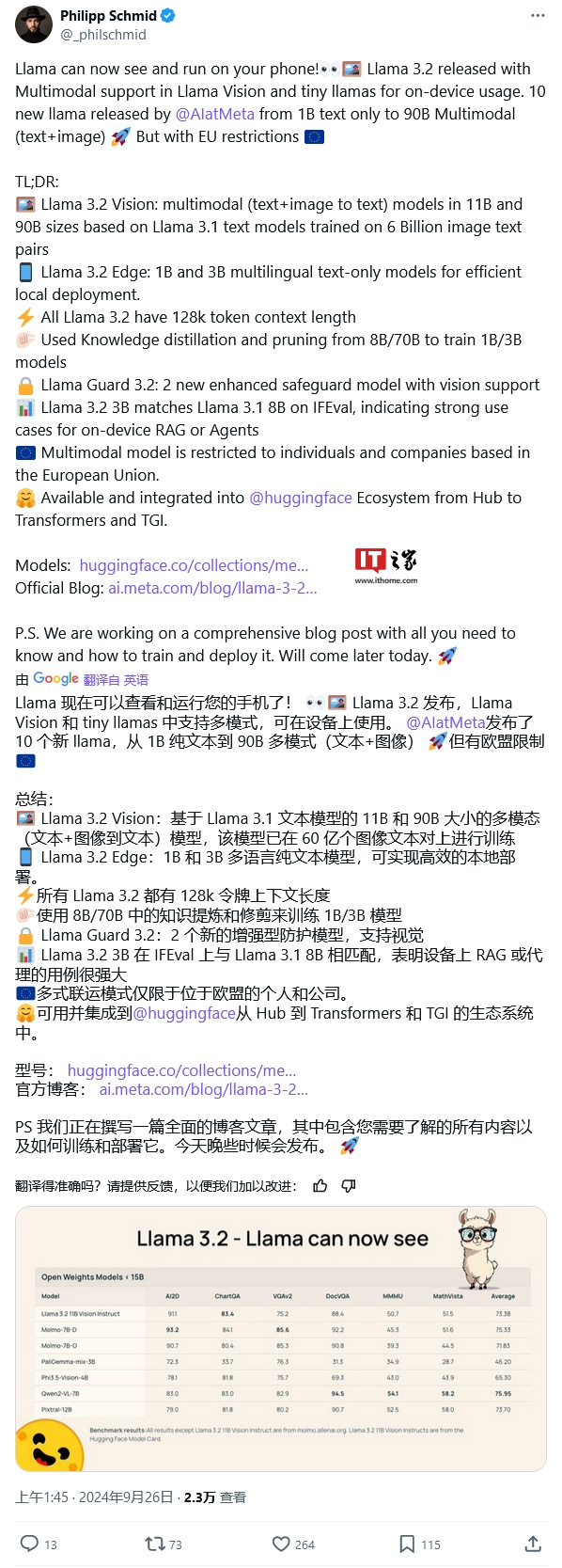

该模型包括适合边缘和移动设备的中小型视觉 LLMs(11B 和 90B),以及轻量级的纯文本模型(1B 和 3B),同时还提供预训练和指令微调(instruction-tuned)版本。

4 个版本 AI 模型的简介如下:

- Llama 3.2 90B Vision(文本 + 图像输入):Meta 的最先进模型,适合企业级应用。该模型擅长常识推理、长文本生成、多语言翻译、编码、数学和高级推理。它还引入了图像推理功能,能够完成图像理解和视觉推理任务。该模型非常适合以下用例:图像标题生成、图像文本检索、视觉基础、视觉问题解答和文档视觉问题解答。

- Llama 3.2 11B Vision(文本 + 图像输入):非常适合内容创作、对话式人工智能、语言理解以及需要视觉推理的企业应用。该模型在文本摘要、情感分析、代码生成和执行指令方面表现出色,并增加了图像推理能力。其用例与 90B 版本类似:图像标题生成、图像文本检索、视觉基础、视觉问题解答和文档视觉问题解答。

- Llama 3.2 3B(文本输入):专为需要低延迟推理和有限计算资源的应用而设计。它擅长文本摘要、分类和语言翻译任务。该模型非常适合以下用例:移动人工智能写作助手和客户服务应用。

- Llama 3.2 1B(文本输入):Llama 3.2 系列中最轻量级的模型,特别适合边缘设备和移动应用程序的检索和摘要。该模型非常适合以下用例:个人信息管理和多语言知识检索。

其中,Llama 3.2 1B 和 3B 模型支持 128K 标记的上下文长度,在边缘本地运行的设备用例(如摘要、指令跟踪和重写任务)中表现优异。这些模型在发布当天就支持高通和联发科硬件,并针对 Arm 处理器进行了优化。

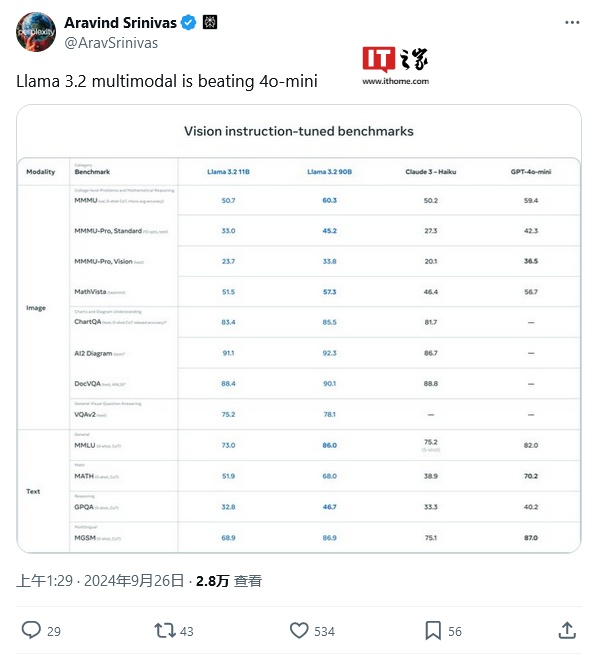

Llama 3.2 11B 和 90B 视觉模型可以直接替代相应的文本模型,并在图像理解任务上优于 Claude 3 Haiku 等闭源模型。

与其他开源多模态模型不同,预训练模型和对齐模型均可通过 torchtune 针对自定义应用进行微调,并可使用 torchchat 进行本地部署。开发者还可以通过智能助手 Meta AI 试用这些模型。

Meta 将分享首批 Llama Stack 官方发行版,这将大大简化开发者在不同环境(包括单节点、内部部署、云和设备)中使用 Llama 模型的方式,实现检索增强生成(RAG)和工具支持型应用的交钥匙部署,并集成安全性。

Meta 一直与 AWS、Databricks、Dell Technologies、Fireworks、Infosys 和 Together AI 等合作伙伴紧密合作,为他们的下游企业客户构建 Llama Stack 发行版。设备分发通过 PyTorch ExecuTorch,单节点分发通过 Ollama。