英伟达 NVLM 1.0 引领多模态 AI 变革:媲美 GPT-4o,不牺牲性能平衡文本和图像处理难题

GoodNav 9 月 21 日报道,科技媒体 marktechpost 于昨日(9 月 20 日)发布了一篇博文,介绍了英伟达(Nvidia)最新发布的论文,阐述了多模态大语言模型系列 NVLM 1.0。

多模态大型语言模型(MLLM)

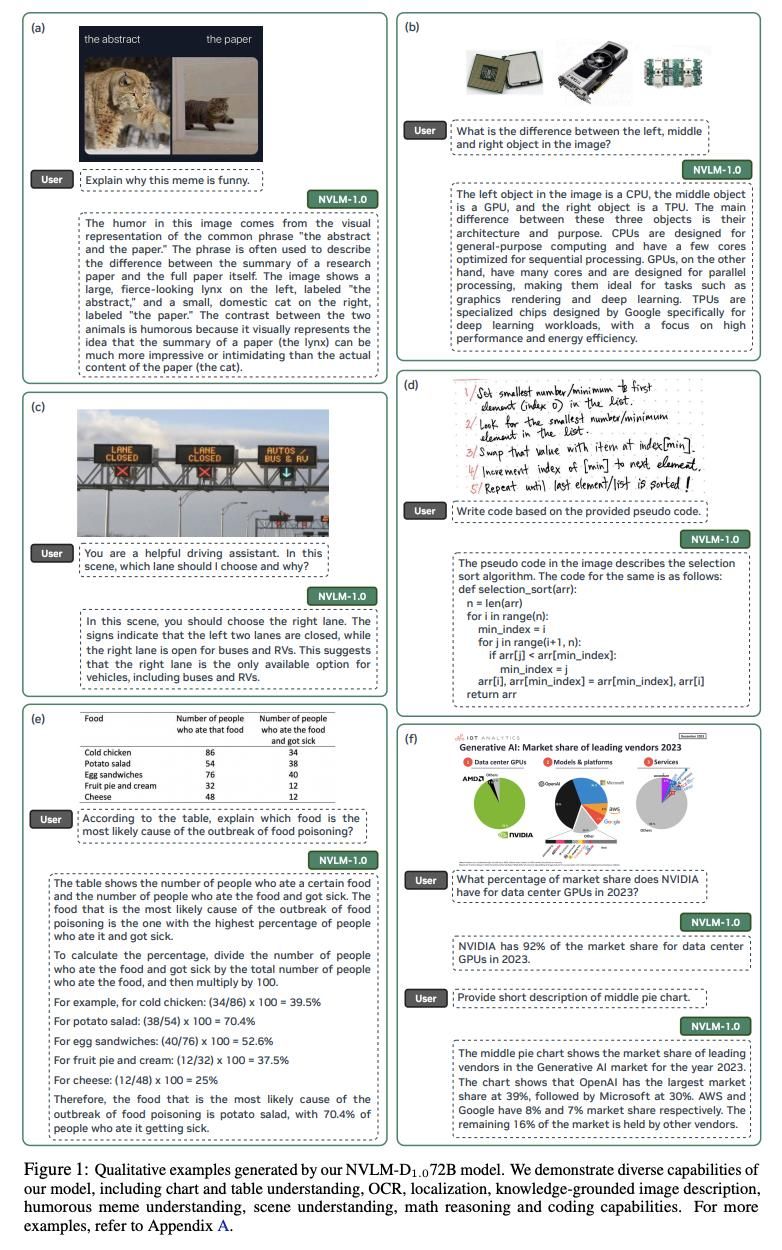

多模态大型语言模型(MLLM)所构建的 AI 系统,能够无缝解析文本和视觉数据,缩小自然语言理解与视觉理解之间的差距,使机器能够连贯地处理从文本文档到图像等多种输入形式。

多模态大型语言模型在图像识别、自然语言处理和计算机视觉等领域展现出广阔的应用前景,改善了人工智能整合和处理不同数据源的方式,推动 AI 向更复杂的应用方向发展。

英伟达 NVLM 1.0

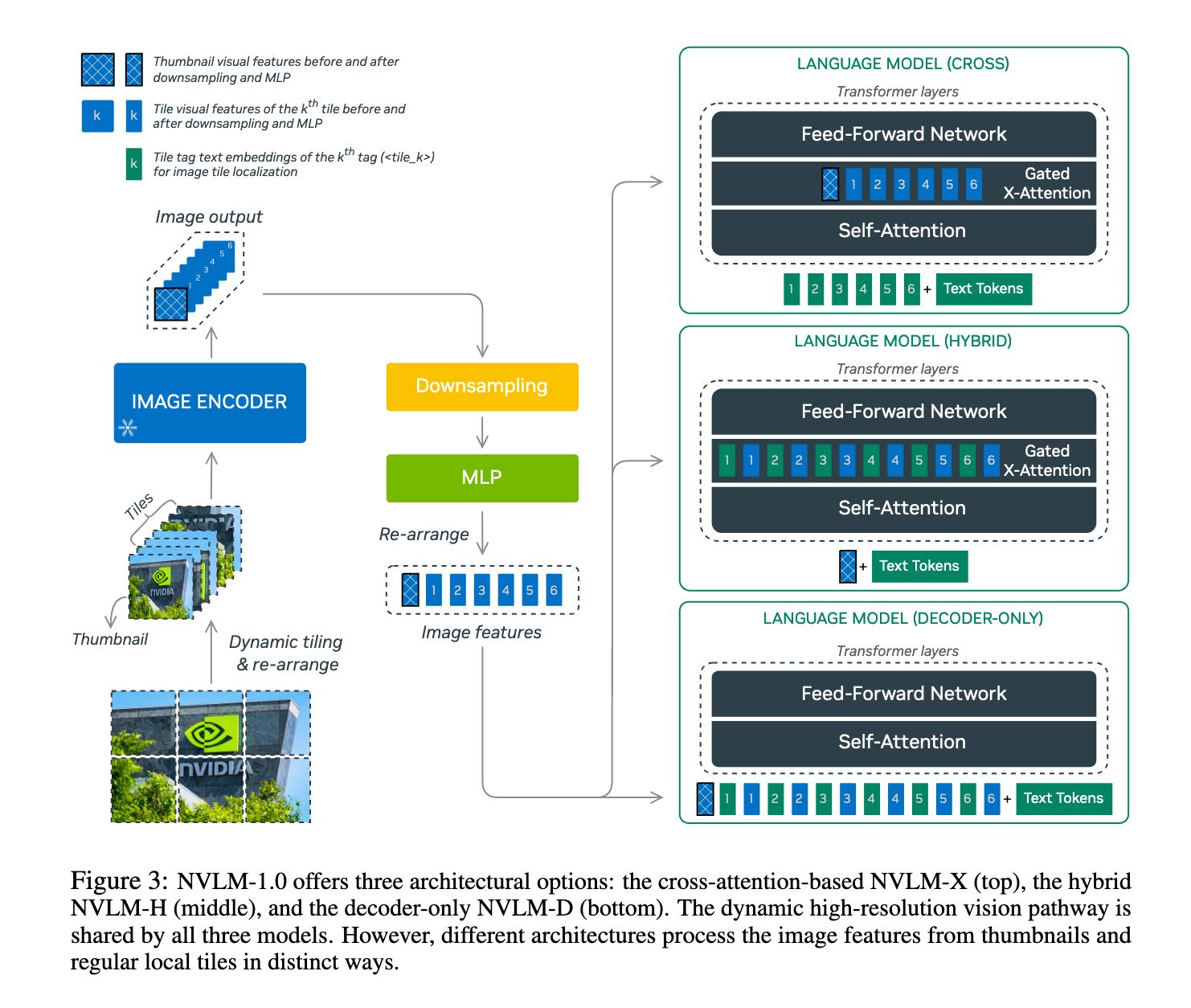

NVLM 1.0 系列包含 NVLM-D、NVLM-X 和 NVLM-H 三种主要架构。每种架构都结合了先进的多模态推理能力与高效的文本处理功能,从而克服了以往方法的不足。

NVLM 1.0 的一个显著特点是在训练过程中引入了高质量的纯文本监督微调(SFT)数据,这使得这些模型在视觉语言任务中表现优异,同时保持甚至提升了纯文本性能。

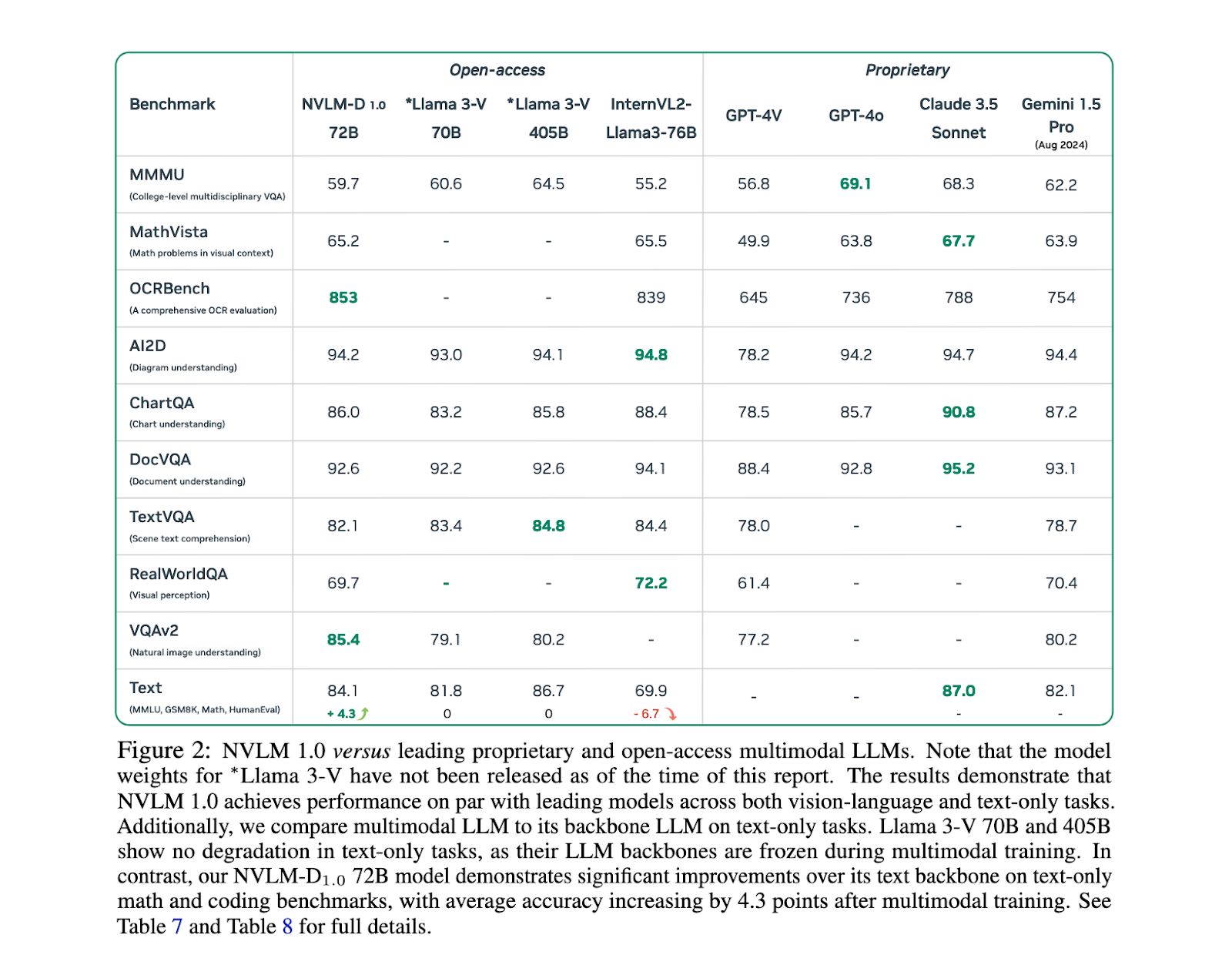

研究团队强调,他们的方法旨在超越现有的专有模型如 GPT-4V 和开放替代模型如 InternVL。

NVLM 1.0 模型采用混合架构来平衡文本与图像处理:

-

NVLM-D:纯解码器模型,以统一的方式处理两种模式,因此在多模式推理任务中表现尤为出色。

-

NVLM-X:采用交叉注意机制,提升了处理高分辨率图像时的计算效率。

-

NVLM-H:结合了上述两种架构的优势,在保持文本推理所需效率的同时,实现了更为细致的图像理解。

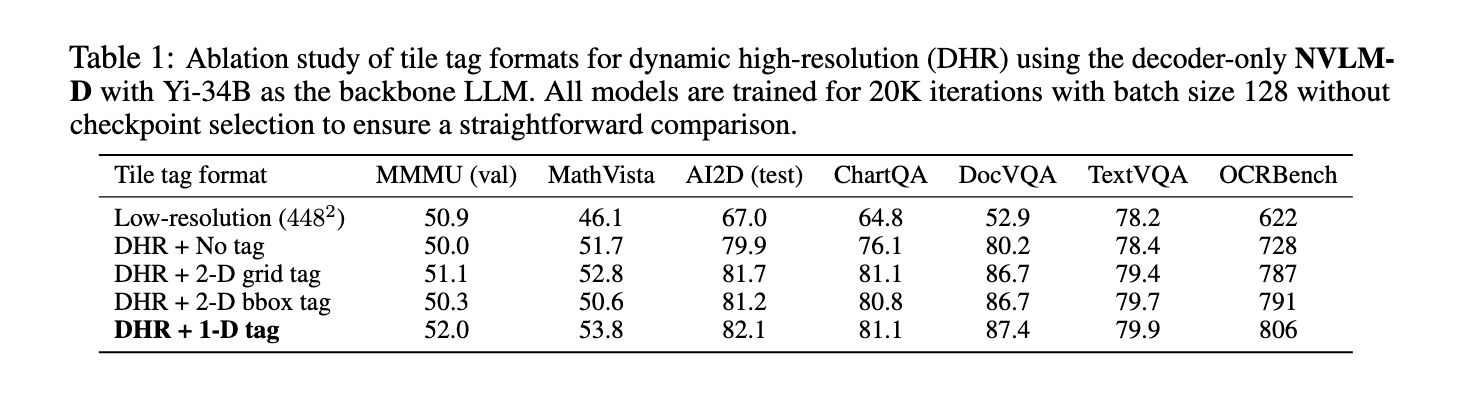

这些模型结合了高分辨率照片的动态平铺技术,在不牺牲推理能力的前提下显著提升了 OCR 相关任务的性能。

性能

在性能方面,NVLM 1.0 模型在多个基准测试中取得了令人瞩目的成绩。

-

得益于在训练过程中整合了高质量的文本数据集,NVLM-D1.0 72B 模型在 MATH 和 GSM8K 等纯文本任务中比其纯文本骨干提高了 4.3 分。

-

在视觉问题解答和推理任务中,这些模型展现出强大的视觉语言性能,在 VQAv2 数据集上的准确率为 93.6%,在 AI2D 上的准确率为 87.4%。

-

在 OCR 相关任务中,NVLM 模型的表现明显优于现有系统,在 DocVQA 和 ChartQA 数据集上的准确率分别为 87.4% 和 81.7%,突显了其处理复杂视觉信息的能力。

-

NVLM-X 和 NVLM-H 模型同样取得了这些成绩,在处理高分辨率图像和多模态数据方面表现出色。

研究的主要发现之一是,NVLM 模型不仅在视觉语言任务中表现优异,还保持或提升了纯文本性能,这是其他多模态模型难以实现的。

例如,在基于文本的推理任务(如 MMLU)中,NVLM 模型保持了较高的准确率,在某些情况下甚至超过了纯文本模型。

想象一下在自动驾驶汽车中的应用场景。NVLM 1.0 可以通过摄像头实时获取道路信息,并与车辆导航系统进行语言沟通。

它不仅能识别交通标志,还能理解复杂路况下的人类指令,例如“如果前方有施工,请寻找替代路线”。这得益于其强大的视觉-语言处理能力以及出色的文本推理能力,使得自动驾驶更加智能、安全、可靠。

小结

英伟达开发的 NVLM 1.0 模型标志着多模态大型语言模型的重大进展,该模型通过在多模态训练中整合高质量文本数据集,并采用动态平铺和高分辨率图像平铺标记等创新架构设计,解决了在不牺牲性能的前提下平衡文本和图像处理的关键难题。

NVLM 系列模型不仅在视觉语言任务方面超越了领先的专有系统,而且还保持了卓越的纯文本推理能力,推动多模态人工智能系统的发展向前迈进了一大步。

参考地址