o1 核心作者 MIT 演讲:激励 AI 自我学习,比试图教会 AI 每一项任务更重要

“o1 发布后,新的范式应运而生”。

在这方面,OpenAI 的研究科学家、o1 的核心贡献者 Hyung Won Chung 最近在 MIT 的一次演讲中分享了他的见解。

演讲的主题是“Don’t teach. Incentivize(不要教,要激励)”,其核心观点是:

激励 AI 自我学习比试图教会 AI 每一项具体任务更为重要

思维链的作者 Jason Wei 迅速表示支持:

Hyung Won 识别新范式并完全放弃任何沉没成本的能力给我留下了深刻的印象。

他在 2022 年底意识到了强化学习的潜力,并从那时起一直在推广这一理念。

在演讲中,Hyung Won 还提到:

技术人员往往过于关注解决问题本身,但更重要的是发现重大问题;

硬件的进步是指数级的,而软件和算法需要跟上;

当前存在一个误区,即人们试图让 AI 学会像人类一样思考;

“仅仅扩展规模”往往在长期内更有效;

……

以下是演讲的主要内容。

对待 AI:授人以鱼不如授人以渔

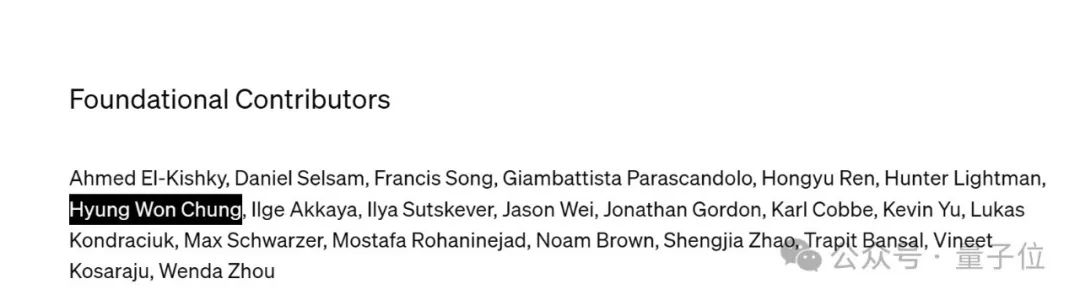

首先简单介绍一下 Hyung Won Chung,根据公布的 o1 背后人员名单,他是推理研究的基础贡献者。

资料显示,他是 MIT 博士(研究方向为可再生能源和能源系统),去年 2 月加入 OpenAI 担任研究科学家。

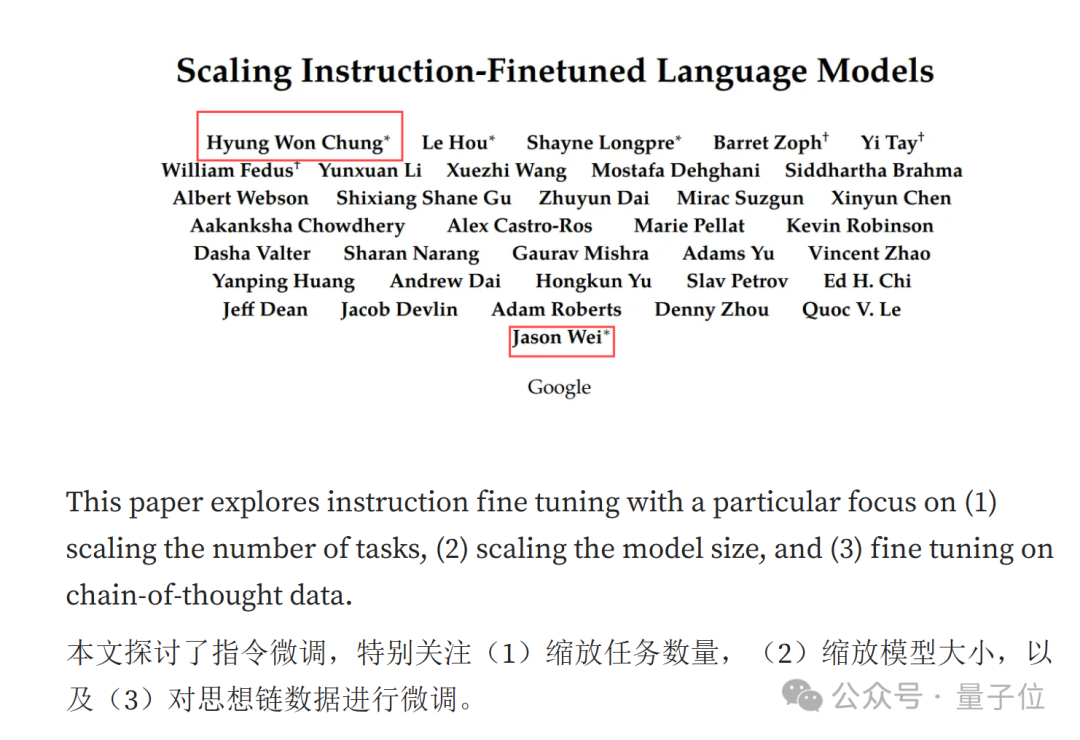

在加入 OpenAI 之前,他在 Google Brain 负责大语言模型的预训练、指令微调、推理、多语言和训练基础设施等工作。

在谷歌工作期间,他以第一作者身份发表了关于模型微调的论文。(思维链的作者 Jason Wei 也是第一作者)

回到正题。在 MIT 的演讲中,他首先提到:

通往 AGI 唯一可行的方法是激励模型,使通用技能得以出现。

在他看来,AI 领域正经历一次范式转变,即从传统的直接教授技能转向激励模型自我学习和发展通用技能。

理由也很简单,AGI 所需的技能太多,无法一一教授。(主打以不变应万变)

那么,具体如何激励呢?

他以下一个 token 预测为例,说明了这种弱激励结构如何通过大规模多任务学习,鼓励模型学习解决数万亿个任务的通用技能,而不是单独解决每个任务。

他观察到:

如果尝试以尽可能少的努力解决数十个任务,那么单独模式识别每个任务可能是最简单的;

如果尝试解决数万亿个任务,通过学习通用技能(例如语言、推理等)可能会更容易解决它们。

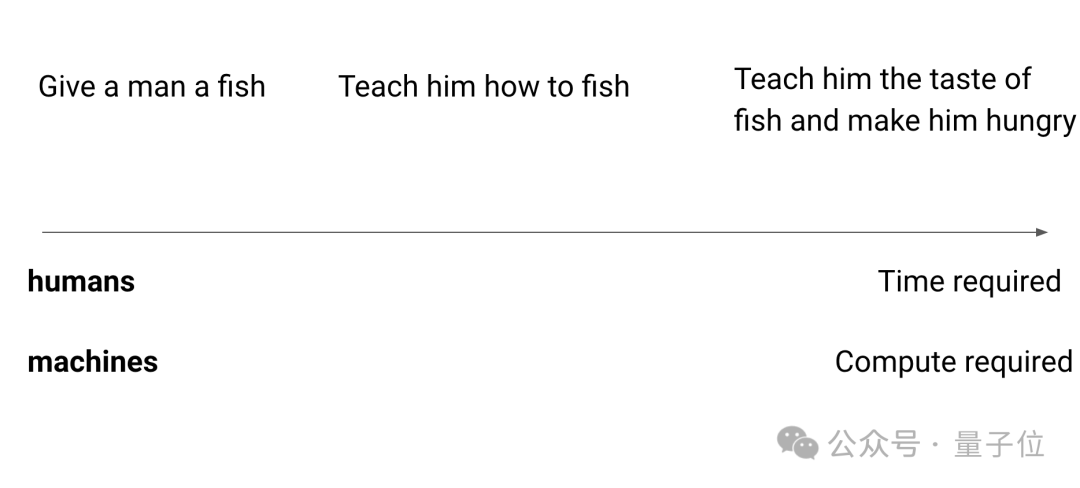

对此他打了个比方,“授人以鱼不如授人以渔”,用一种基于激励的方法来解决任务。

Teach him the taste of fish and make him hungry.(教 AI 尝尝鱼的味道,让他饿一下)

这样 AI 就会自己去钓鱼,在这个过程中,AI 将学习其他技能,例如耐心、学习阅读天气、了解鱼类等。

其中一些技能是通用的,可以应用于其他任务。

面对这一“循循善诱”的过程,或许有人认为直接教来得更快。

但在 Hyung Won 看来:

对于人类来说确实如此,但对于机器来说,我们可以提供更多的计算来缩短时间。

换句话说,面对有限的时间,人类可能需要在专家和通才之间做选择,但对于机器来说,算力能够创造奇迹。

他还举了一个例子,《龙珠》中有一个设定:在特殊训练场所,角色能在外界感觉仅一天的时间内获得一年的修炼效果。

对于机器来说,这个感知差值要高得多。

因此,具有更多计算能力的强大通才通常比专家更擅长特殊领域。

原因也很简单,大型通用模型能够通过大规模的训练和学习,快速适应和掌握新的任务和领域,而不需要从头开始训练。

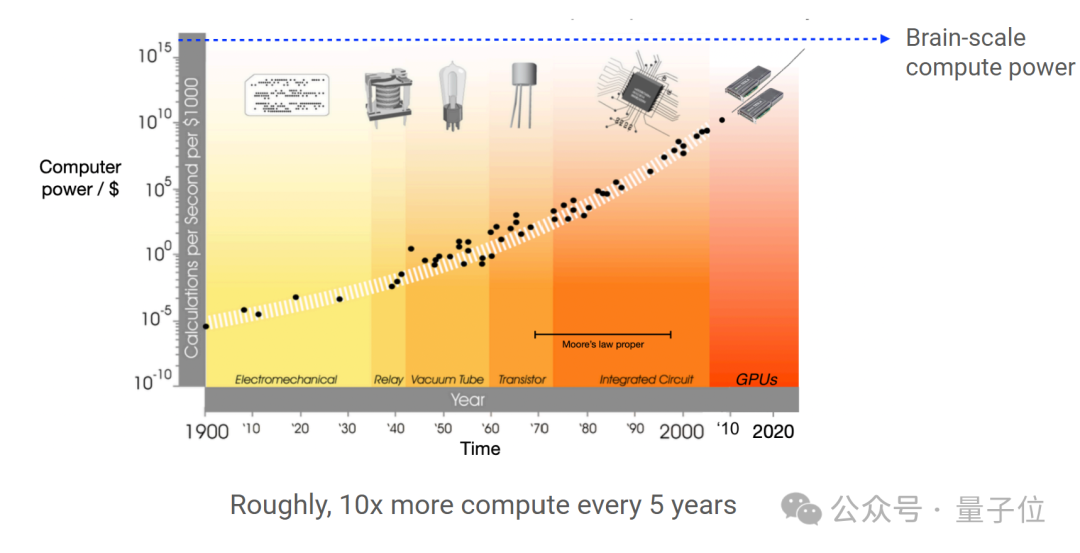

他还补充道,数据显示计算能力大约每 5 年提高 10 倍。

总结来说,Hyung Won 认为核心在于:

模型的可扩展性

算力对加速模型进化至关重要

此外,他还认为当前存在一个误区,即人们试图让 AI 学会像人类一样思考。

但问题在于,我们并不知道自己在神经元层面是如何思考的。

机器应该有更多的自主性来选择如何学习,而不是被限制在人类理解的数学语言和结构中。

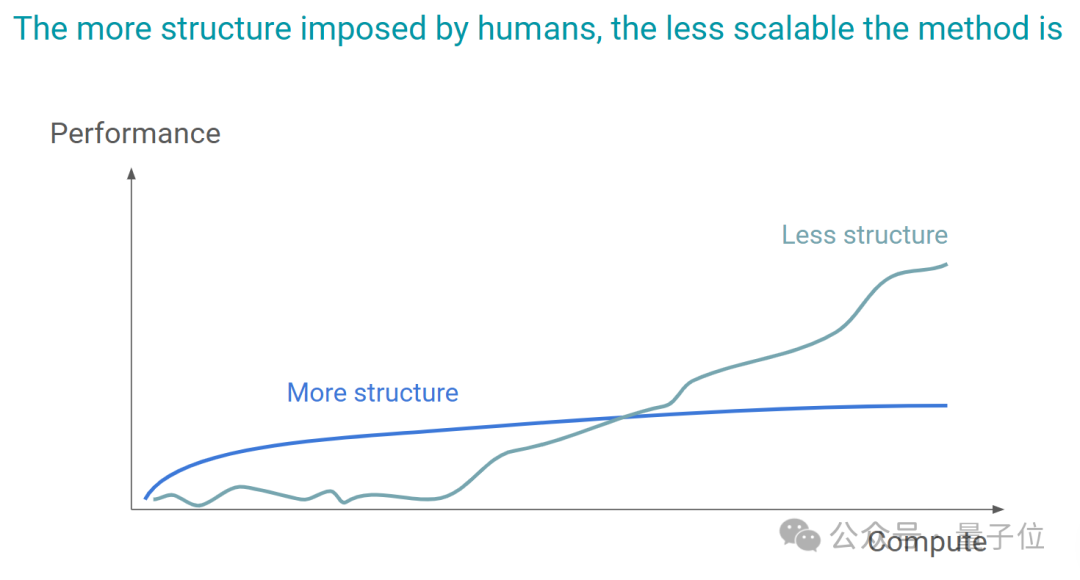

在他看来,一个系统或算法如果过于依赖人为设定的规则和结构,那么它可能难以适应新的、未预见的情况或数据。

结果是,面对更大规模或更复杂的问题时,其扩展能力将受到限制。

回顾 AI 过去 70 年的发展,他总结道:

AI 的进步与减少人为结构、增加数据和计算能力息息相关。

与此同时,面对当前人们对 scaling Law 的质疑,即认为仅仅扩大计算规模可能不够科学或有趣。

Hyung Won 的看法是:

在扩展一个系统或模型的过程中,我们需要找出那些阻碍扩展的假设或限制条件。

举个例子,在机器学习中,一个模型可能在小数据集上表现良好,但当数据量增加时,模型的性能可能会下降,或者训练时间会变得不可接受。

这时,可能需要改进算法,优化数据处理流程,或者改变模型结构,以适应更大的数据量和更复杂的任务。

也就是说,一旦识别出瓶颈,就需要通过创新和改进来替换这些假设,以便模型或系统能够在更大的规模上有效运行。

训练 VS 推理:效果相似,推理成本却便宜 1000 亿倍

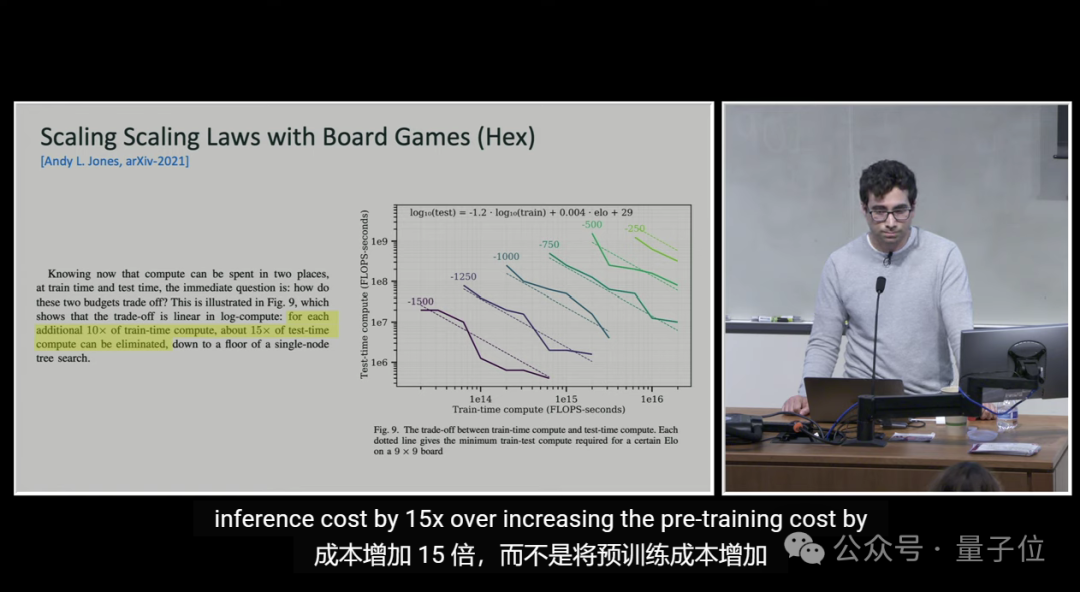

除了上述,o1 的另一位核心作者 Noam Brown 也分享了一个观点:

训练和推理对模型性能提升的作用相似,但后者的成本更低,便宜 1000 亿倍。

这意味着,在模型开发过程中,训练阶段的资源消耗非常巨大,而实际使用模型进行推理时的成本则相对较低。

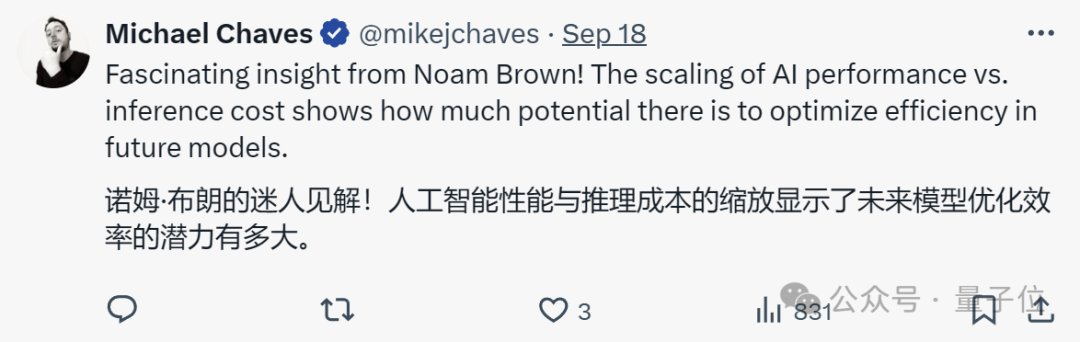

有人认为这凸显了未来模型优化的潜力。

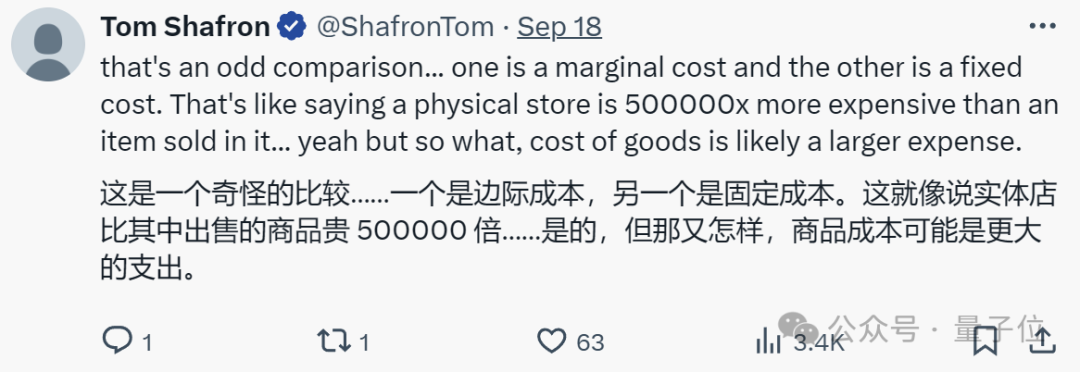

不过也有人对此持怀疑态度,认为二者根本无法进行比较。

这是一个奇怪的比较。一个是边际成本,另一个是固定成本。这就像说实体店比其中出售的商品贵 500000 倍。

对此,你怎么看?

Hyung Won Chung 演讲 PPT:

-

https://docs.google.com/presentation/d/1nnjXIuN2XDJENAOaKXI5srQscO3276svvP6JgivTv6w/edit#slide=id.g2d1161c9c52_0_20

参考链接:

-

[1]https://x.com/hwchung27/status/1836842717302943774

-

[2]https://x.com/tsarnick/status/1836215965912289306

本文来自微信公众号:量子位(ID:QbitAI),作者:一水