英伟达发布 Eagle 2.5 视觉语言 AI 模型:8B 参数媲美 GPT-4o

GoodNav 4月23日报道,科技媒体marktechpost在昨日(4月22日)发布了一篇博文,介绍了英伟达新推出的Eagle 2.5,这是一个专为长上下文多模态学习设计的视觉-语言模型(VLM)。

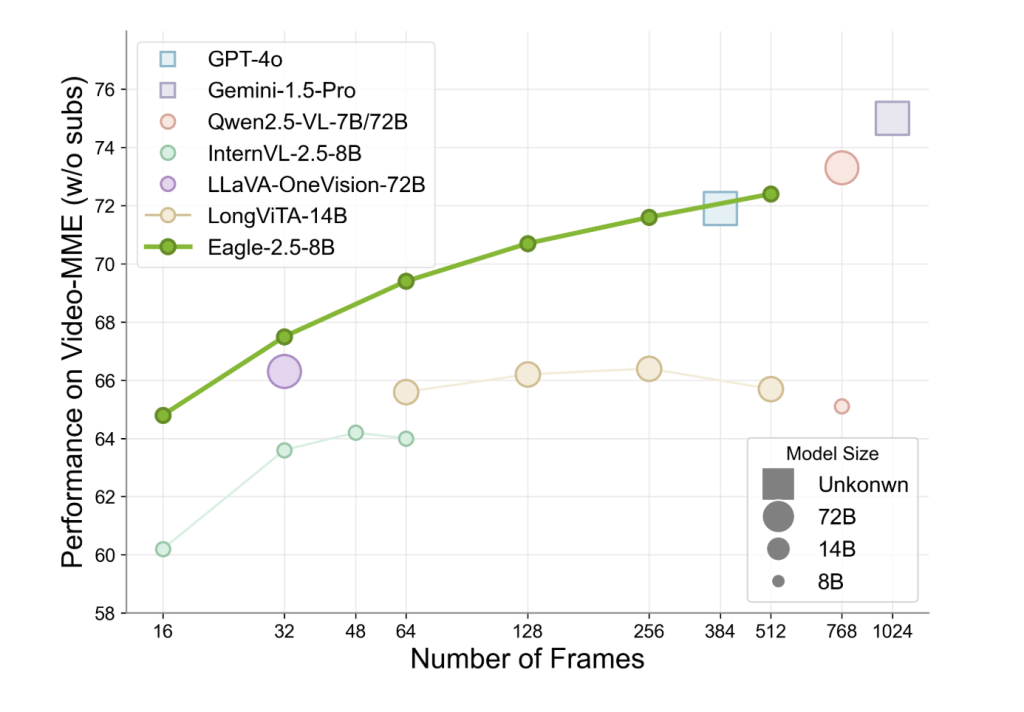

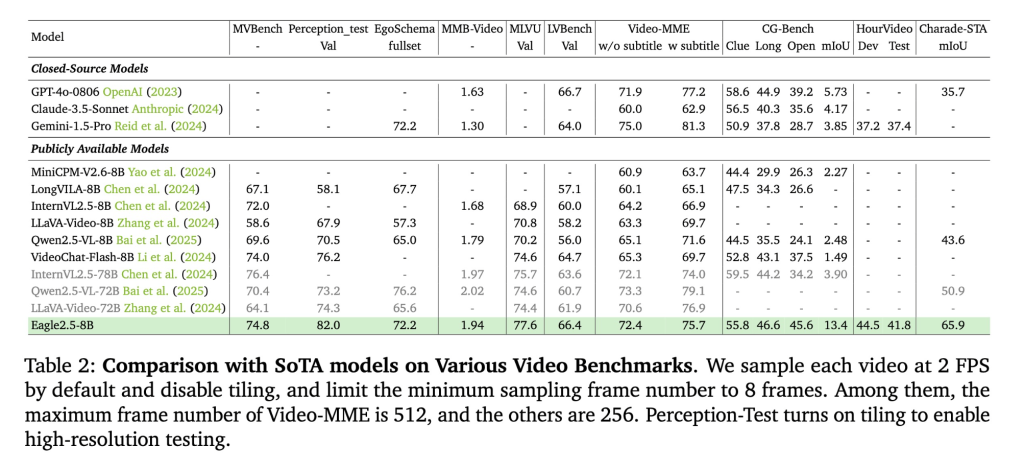

该模型专注于处理大规模视频和图像,在高分辨率图像及长视频序列的处理方面表现尤为出色。尽管其参数规模仅为8B,但在Video-MME基准测试(512帧输入)中的得分高达72.4%,与更大参数规模的模型如Qwen2.5-VL-72B和InternVL2.5-78B相当。

创新训练策略

Eagle 2.5的成功得益于两项关键训练策略:信息优先采样(Information-First Sampling)和渐进式后训练(Progressive Post-Training)。

信息优先采样利用图像区域保留(IAP)技术,保存超过60%的原始图像区域,减少宽高比失真;自动降级采样(ADS)则根据上下文长度动态平衡视觉与文本输入,确保文本的完整性和视觉细节的优化。

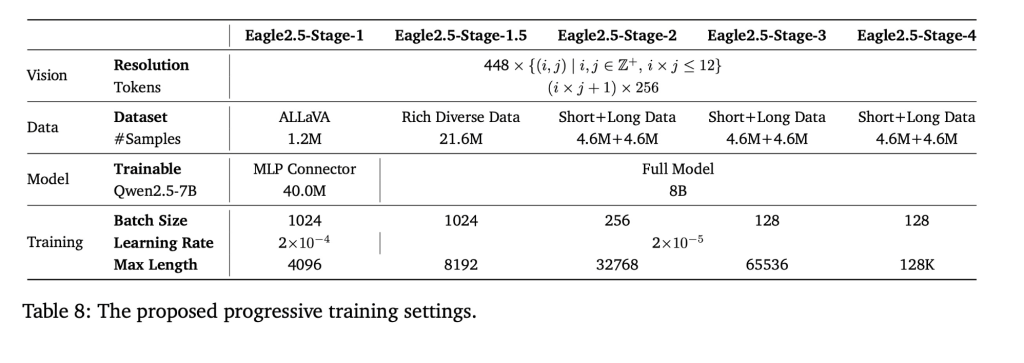

渐进式后训练逐步扩展模型的上下文窗口,从32K到128K token,使模型在不同长度输入下保持稳定性能,避免只专注于单一上下文范围。这些策略结合SigLIP视觉编码和MLP投影层,保证了模型在多样化任务中的灵活性。

定制数据集

Eagle 2.5的训练数据管道融合了开源资源和专为长视频设计的定制数据集Eagle-Video-110K,该数据集采用双重标注方式。

自上而下的方法通过故事级分割,并结合人类标注的章节元数据和GPT-4生成的详细描述;自下而上的方法则通过GPT-4o为短片段生成问答对,捕捉时空细节。

通过余弦相似度(cosine similarity)过滤,数据集强调多样性而非冗余,确保叙述连贯性和细粒度标注,从而显著提升模型在高帧数(≥128帧)任务中的表现。

性能表现

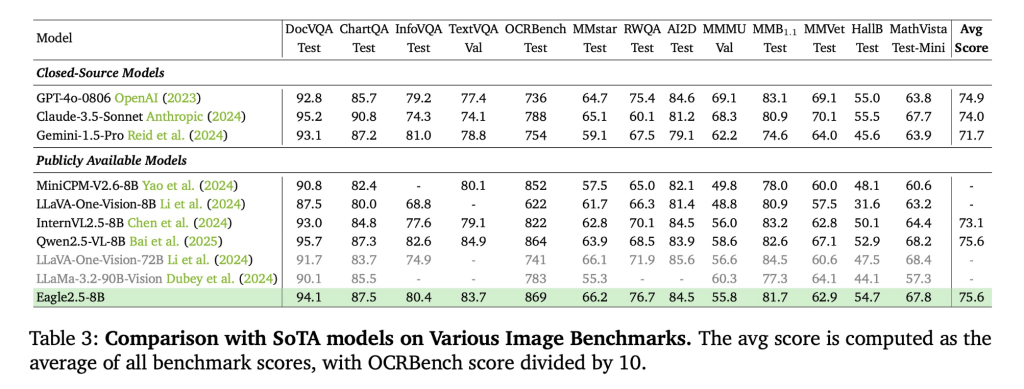

Eagle 2.5-8B在多项视频和图像理解任务中展现出色的性能。在视频基准测试中,MVBench得分为74.8,MLVU为77.6,LongVideoBench为66.4;在图像基准测试中,DocVQA得分为94.1,ChartQA为87.5,InfoVQA为80.4。

消融研究(Ablation studies)表明,移除IAP与ADS会导致性能下降,而实施渐进式训练和整合Eagle-Video-110K数据集则能带来更稳定的性能提升。

参考地址