力压群雄:谷歌 Gemini 2.5 Pro 成首款完全理解 PDF 布局的 AI 模型,可精确引用

GoodNav 4 月 22 日报道,最新研究表明,谷歌的 Gemini 2.5 Pro 模型能够准确解析 PDF 文件的视觉结构,实现精确的视觉引用功能,成为第一款完全理解 PDF 布局的人工智能模型。

值得注意的是,谷歌在 3 月 25 日首次向付费用户和开发者发布了 Gemini 2.5 Pro 的实验版本,仅四天后,便通过免费 Web 应用向全球用户开放了该功能。

Gemini 2.5 Pro 能够提取 PDF 文档中的文本内容,并理解其视觉布局,如图表、表格及整体排版。

谷歌在开发者文档中说明,该模型具备“原生视觉”(Native Vision)能力,可以处理最多 3000 个 PDF 文件(每个文件限制为 1000 页或 50MB),并拥有 100 万 token 的超大上下文窗口,未来有计划扩展至 200 万 token。

AI 初创企业 Matrisk 的联合创始人 Sergey Filimonov 对 Gemini 2.5 Pro 在 PDF 视觉引用方面的卓越表现给予了高度评价。

Filimonov 指出,传统文本分割方法会破坏用户与原始文本的视觉连接,使其难以直观验证信息来源。甚至在 ChatGPT 中,点击引用后只会下载 PDF,迫使用户自行判断模型是否存在“幻觉”,这严重削弱了用户的信任。

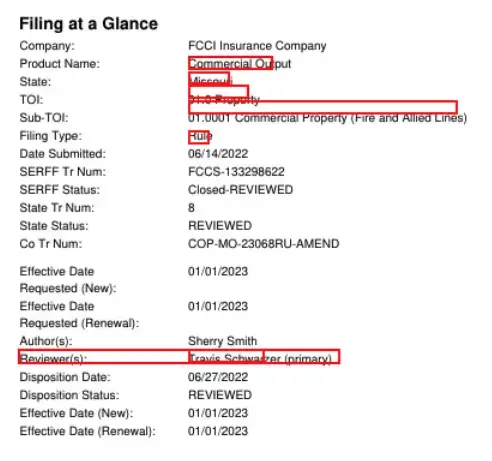

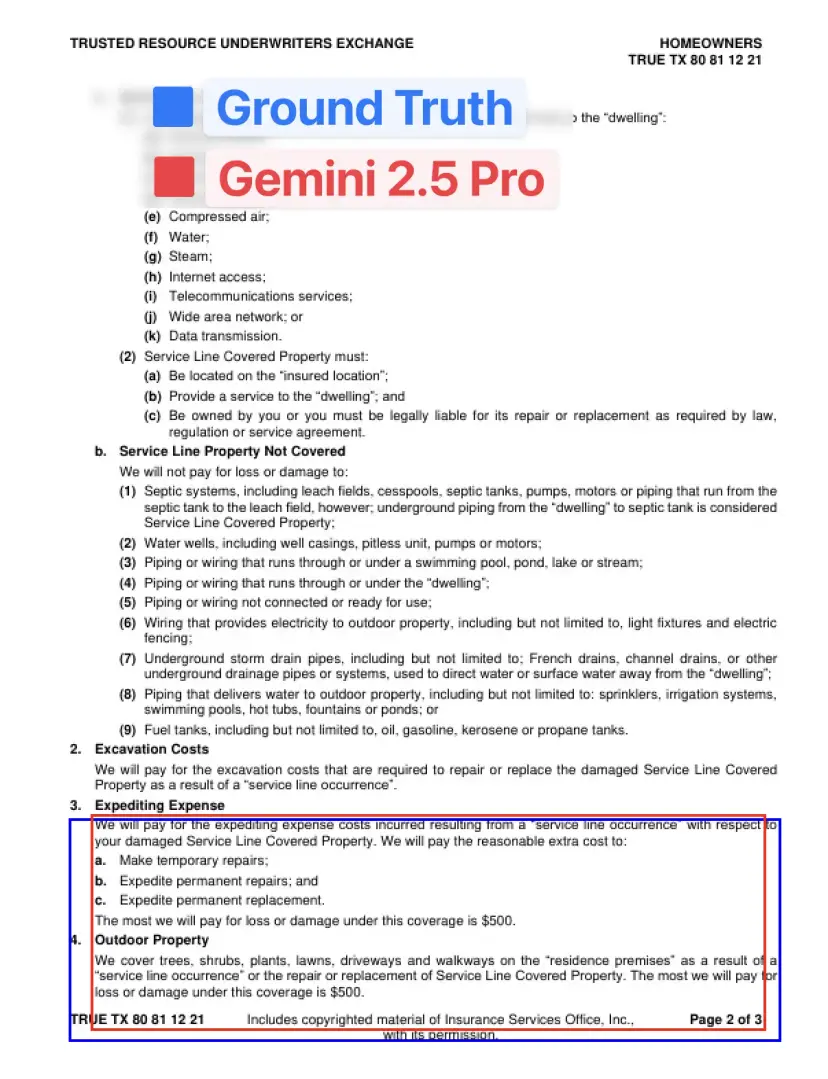

过去,引用文档内容往往只能通过高亮显示大段无关文本,精准度极低。而 Gemini 2.5 彻底改变了这一局面,它不仅能够将提取的文本片段映射回原始 PDF 的准确位置,还能以前所未有的精度定位具体句子、表格单元甚至图像。

这种技术突破为用户提供了清晰的视觉反馈。例如,当询问房屋费率变化时,系统能直接高亮显示文档中相关数据(如 15.4% 的费率变化),同时标注其来源依据。

这种清晰度和互动性是现有工具无法比拟的。Gemini 2.5 不仅优化了现有流程,还开启了全新的文档交互模式。

相比之下,Gemini 2.5 以 0.804 的 IoU(交并比)精准度远超其他模型,如 OpenAI 的 GPT-4o(0.223)和 Claude 3.7 Sonnet(0.210),展现出惊人的空间理解能力。

| 提供商 | 模型 | IOU | 简评 |

|---|---|---|---|

| Gemini | 2.5 Pro | 0.804 | 非常优秀 |

| Gemini | 2.5 Flash | 0.614 | 有时表现不错 |

| Gemini | 2.0 Flash | 0.395 | |

| OpenAI | gpt-4o | 0.223 | |

| OpenAI | gpt-4.1 | 0.268 | |

| OpenAI | gpt-4.1-mini | 0.253 | |

| Claude | 3.7 Sonnet | 0.210 |

Gemini 2.5 的潜力不仅限于文本定位。它还可以从 PDF 中提取结构化数据,并明确标记每个数据的来源位置,从而解决因数据来源不明确导致的下游决策信任问题。