智谱发布新一代开源 AI 模型 GLM-4-32B-0414 系列,效果比肩 GPT 系列和 DeepSeek-V3 / R1

GoodNav 4 月 15 日消息,智谱于昨日(4 月 14 日)发布了一篇博文,宣布推出新一代 GLM-4-32B-0414 系列模型,拥有 320 亿参数,效果与 OpenAI 的 GPT 系列及 DeepSeek 的 V3 / R1 系列不相上下,并且具备非常友好的本地部署能力。

该系列模型包括 四种型号:GLM-4-32B-Base-0414、GLM-Z1-32B-0414、GLM-Z1-Rumination-32B-0414 和 GLM-Z1-9B-0414。

GLM-4-32B-Base-0414

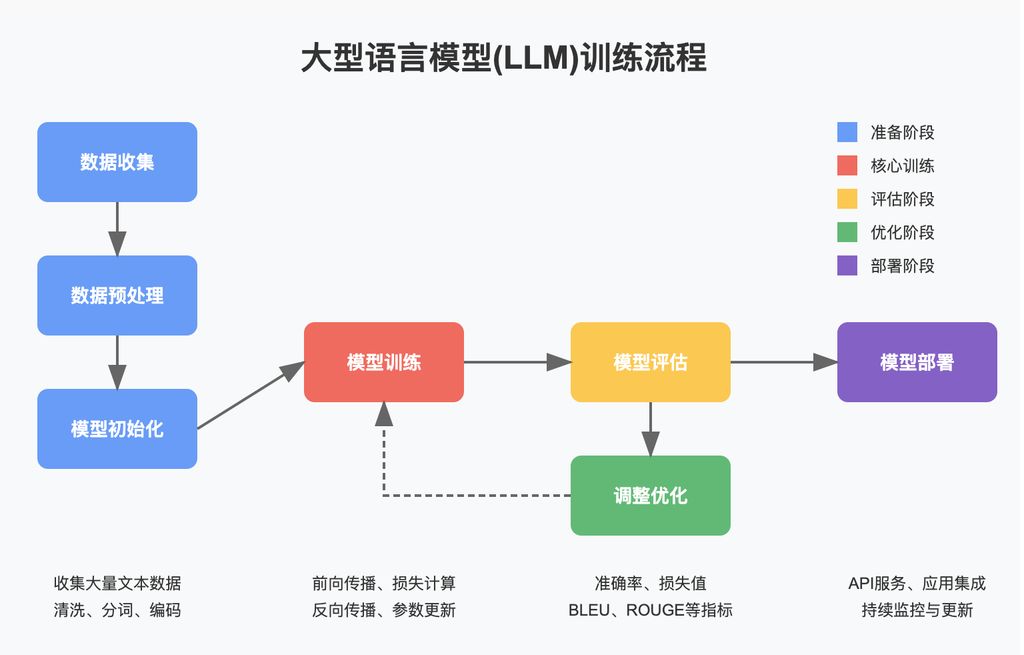

在预训练阶段,该模型利用了 15T 的高质量数据,其中包括大量用于推理的合成数据,为后续的强化学习训练奠定了基础。

在后续训练阶段,除针对对话场景进行了人类偏好对齐外,团队还采用拒绝采样与强化学习等技术,提升了模型在指令遵循、工程代码和函数调用等方面的性能,增强了智能体完成任务所需的基本能力。

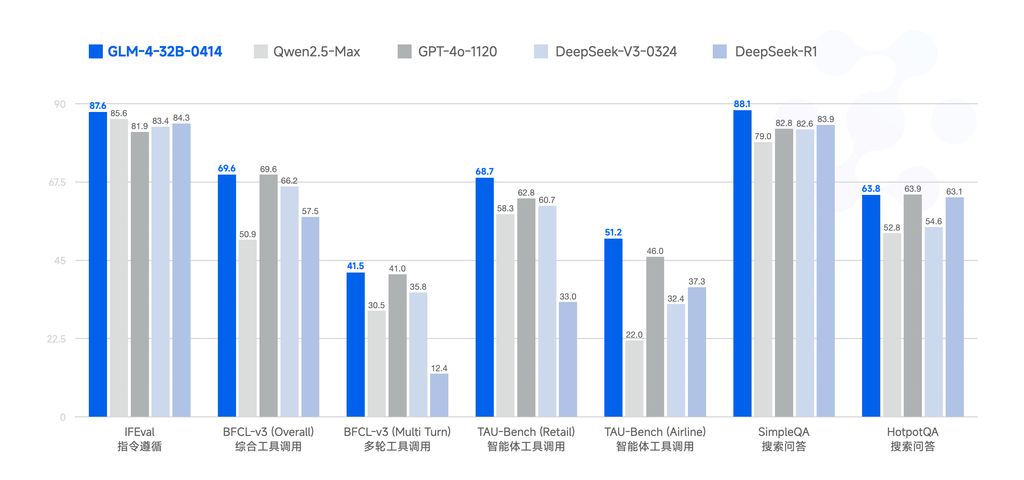

GLM-4-32B-0414 在工程代码、Artifacts 生成、函数调用、搜索问答及报告等领域展现了良好的效果,某些基准测试的表现甚至可以媲美更大规模的 GPT-4o、DeepSeek-V3-0324(671B)等模型。

GLM-Z1-32B-0414

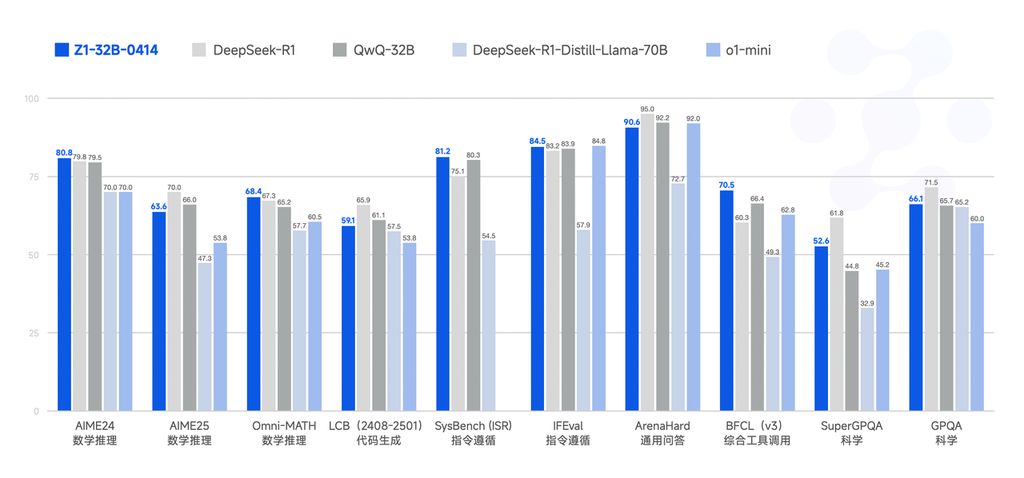

该模型具备深度思考能力,是在 GLM-4-32B-0414 的基础上,通过冷启动与扩展强化学习,对数学、代码与逻辑等任务进行进一步训练得到的。

与基础模型相比,GLM-Z1-32B-0414 显著提升了数理能力和处理复杂任务的能力。在训练过程中,该团队引入了基于对战排序反馈的通用强化学习,进一步提升了模型的通用性。

GLM-Z1-Rumination-32B-0414

该模型是具备沉思能力的深度推理模型(参考 Open AI 的 Deep Research)。

沉思模型通过更长时间的深入思考来应对更开放和复杂的问题(例如:编写两个城市 AI 发展对比及未来发展规划),结合搜索工具处理复杂任务,并通过多种规则型奖励来指导和扩展其端到端的强化学习训练。

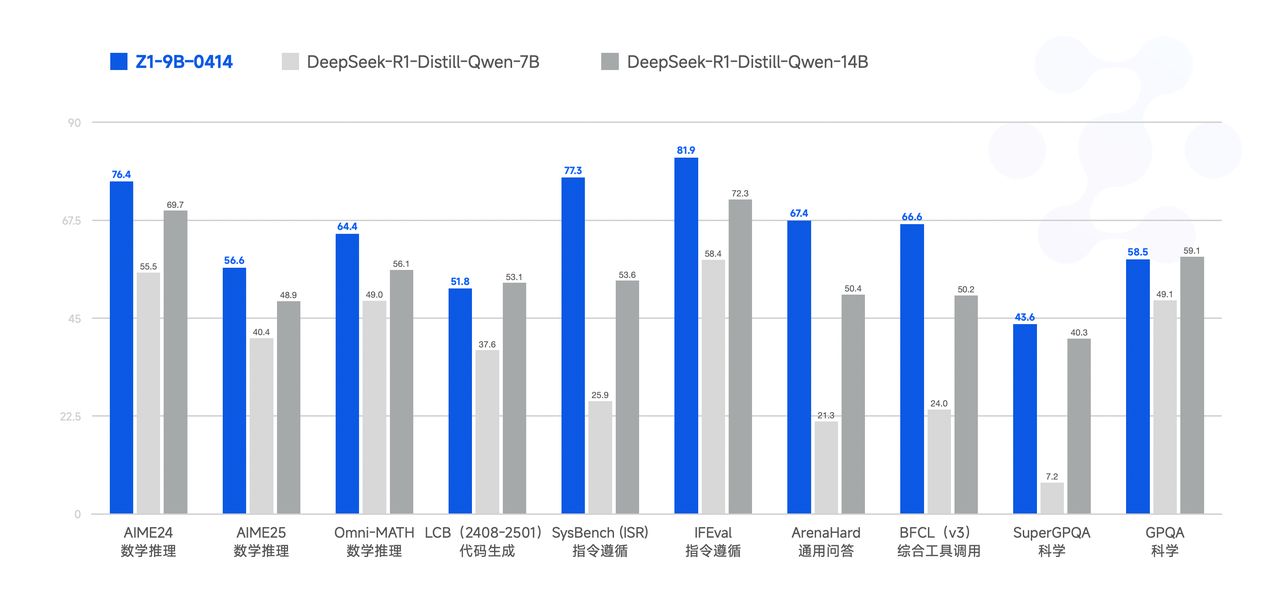

GLM-Z1-9B-0414

这是一个开源的小型 9B 模型,在数学推理和一般任务中同样表现出色,其整体性能在同尺寸开源模型中名列前茅。

测试结果

GLM-4 系列在多项基准测试中表现出色。例如,在 IFEval 指令遵循测试中得分 87.6;在 TAU-Bench 任务自动化测试中,零售场景得分 68.7,航空场景得分 51.2;在 SimpleQA 搜索增强问答测试中的得分为 88.1。

| 模型 | IFEval | BFCL-v3 (总体) | BFCL-v3 (多轮) | TAU-Bench (零售) | TAU-Bench (航空) | SimpleQA | HotpotQA |

|---|---|---|---|---|---|---|---|

| Qwen2.5-Max | 85.6 | 50.9 | 30.5 | 58.3 | 22.0 | 79.0 | 52.8 |

| GPT-4o-1120 | 81.9 | 69.6 | 41.0 | 62.8 | 46.0 | 82.8 | 63.9 |

| DeepSeek-V3-0324 | 83.4 | 66.2 | 35.8 | 60.7 | 32.4 | 82.6 | 54.6 |

| DeepSeek-R1 | 84.3 | 57.5 | 12.4 | 33.0 | 37.3 | 83.9 | 63.1 |

| GLM-4-32B-0414 | 87.6 | 69.6 | 41.5 | 68.7 | 51.2 | 88.1 | 63.8 |

在代码修复方面,GLM-4 在 SWE-bench 测试中的成功率为 33.8%。使用 MIT 许可证的 GLM-4 降低了计算成本,为研究和商业机构提供了高性能的 AI 解决方案。

| 模型 | 框架 | SWE-bench Verified | SWE-bench Verified mini |

|---|---|---|---|

| GLM-4-32B-0414 | Moatless[1] | 33.8 | 38.0 |

| GLM-4-32B-0414 | Agentless[2] | 30.7 | 34.0 |

| GLM-4-32B-0414 | OpenHands[3] | 27.2 | 28.0 |

参考地址